Plan zur automatischen Ausführung einer gespeicherten Suchabfrage erstellen

Nachdem Sie eine gespeicherte Suche erstellt haben, können Sie planen, die Abfrage in der gespeicherten Suche regelmäßig auszuführen und das Ergebnis der Abfrageausführung an den Monitoring-Service weiterzuleiten.

Weitere Themen zu geplanten Aufgaben:

-

Benutzer können alle Vorgänge für geplante Aufgaben ausführen

-

Alle geplanten Aufgaben in einem Compartment mit der API anzeigen

Die folgenden Schritte werden mit dem Monitoring-Service als Ziel für die Überwachung der geplanten Aufgabe erläutert. Die von Oracle Log Analytics ausgegebenen Metriken werden vom Monitoring-Service gespeichert.

-

Öffnen Sie das Navigationsmenü, und klicken Sie auf Observability and Management. Klicken Sie unter Log Analytics auf Administration.

Die Administrationsressourcen werden im linken Navigationsbereich unter Administration aufgeführt. Klicken Sie auf Erkennungsregeln.

Die Seite Erkennungsregeln wird geöffnet. Klicken Sie auf Regel erstellen.

Das Dialogfeld Erkennungsregel erstellen wird geöffnet.

-

Klicken Sie auf Erkennungsregel für geplante Suche.

-

Geben Sie einen Regelnamen für die geplante Aufgabe an.

-

Unter Gespeicherte Suche auswählen:

Geben Sie die gespeicherte Suche an, für die Sie einen Zeitplan erstellen möchten. Wählen Sie zunächst das Compartment aus, in dem die gespeicherte Suche gespeichert wird.

Wählen Sie als Nächstes im Menü die Gespeicherte Suche aus.

Dadurch werden die Details der gespeicherten Suche wie die Abfrage und ihre Beschreibung angezeigt.

-

Gehen Sie unter Setuphäufigkeit wie folgt vor:

Geben Sie Intervall an (das Aggregationsfenster). Sie können den Zeitplan für die Ausführung in den ausgewählten Werten für Minuten, Stunden, Tage oder Wochen optimieren. Wenn Sie größere Aggregationen auswählen, z.B. Tage, können Sie außerdem die feinere Aggregation innerhalb des Bereichs angeben, z.B. die Uhrzeit, zu der die Abfrage ausgeführt werden muss.

Sie können die Häufigkeit der Ausführung der Abfrage angeben, wie

Run indefinitely,Run onceoderCustom.Sie können auch Wiederholungsanzahl in die Häufigkeitsspezifikation aufnehmen, wie oft die Abfrage ausgeführt werden muss.

-

Wählen Sie unter Zu konfigurierenden Zielservice auswählen:

-

Wählen Sie den Zielservice aus, in dem die Ergebnisse der ausgeführten Abfrage gepostet werden, z.B.

Monitoring.Der Monitoring-Service speichert die Metriken für das Ergebnis der nach einem Zeitplan ausgeführten Abfrage.

-

Wählen Sie Metrik-Compartment aus (das Compartment, in dem die Metrik erstellt wird). Standardmäßig wird ein Compartment von Oracle Log Analytics ausgewählt.

-

Wählen Sie Metrik-Namespace aus (den Metrik-Namespace, in dem Sie die neue Metrik ablegen möchten). Welche Optionen zur Auswahl des Namespace verfügbar sind, hängt vom ausgewählten Metrik-Compartment im vorherigen Schritt ab. Wenn keine Optionen verfügbar sind, können Sie auch einen neuen Wert für den Namespace eingeben.

Hinweis

Wenn Sie einen neuen Wert für den Namespace angeben, wählen Sie einen Namen aus, der nicht mitoracle_undoci_beginnt. Sie sind reservierte Präfixe. Siehe Benutzerdefinierte Metriken veröffentlichen. -

Wählen Sie optional Ressourcengruppe aus (die Gruppe, zu der die Metrik gehört). Eine Ressourcengruppe ist eine benutzerdefinierte Zeichenfolge, die mit einer benutzerdefinierten Metrik angegeben wird.

-

Geben Sie Metrikname ein (den Namen der Metrik, der im Explorer des Monitoring-Service zur Anzeige der Metriken verwendet wird). Nur eine Metrik kann angegeben werden.

Zur einfachen Identifizierung im Metrik-Explorer wird empfohlen, den Namen der gespeicherten Suche in den Metriknamen aufzunehmen, z.B. <mysavedsearchname><metric_name>.

-

-

Blenden Sie optional den Abschnitt Erweiterte Optionen anzeigen ein, und fügen Sie Ihrer Erkennungsregel Tags hinzu.

-

Wenn die erforderlichen IAM-Policys noch nicht definiert sind, wird eine Benachrichtigung mit den Policys für folgende Aktionen angezeigt:

- Dynamische Gruppe erstellen

- Policys auf die dynamische Gruppe anwenden, damit die geplanten Aufgaben ausgeführt werden können

Notieren Sie sich die aufgeführten Policys, und erstellen Sie sie.

-

Klicken Sie auf Erkennungsregel erstellen.

Die Abfrage wird nun in regelmäßigen Abständen ausgeführt, und die resultierenden Metriken werden an den Monitoring-Service ausgegeben.

-

Klicken Sie auf der Listenseite für Erkennungsregeln für geplante Suchen auf den Namen der geplanten Suche. Klicken Sie auf der Detailseite für die geplante Suche auf In Metrik-Explorer anzeigen, um die Metriken im Monitoring-Service anzeigen zu können.

Benutzer können alle Vorgänge für geplante Aufgaben ausführen

Um geplante Aufgaben zu erstellen, richten Sie zuerst die richtigen Berechtigungen ein, indem Sie die folgenden IAM-Policys erstellen:

-

Erstellen Sie eine dynamische Gruppe, damit geplante Aufgaben Metriken aus einem bestimmten Compartment an den Monitoring-Service posten können:

ALL {resource.type='loganalyticsscheduledtask', resource.compartment.id='<compartment ocid>'}Alternativ können Sie zulassen, dass Metriken aus allen Compartments gepostet werden:

ALL {resource.type='loganalyticsscheduledtask'} -

Erstellen Sie Policys, damit die dynamische Gruppe Vorgänge für geplante Aufgaben im Mandanten ausführen kann:

allow group <group_name> to use loganalytics-scheduled-task in tenancy allow dynamic-group <dynamic_group_name> to use metrics in tenancy allow dynamic-group <dynamic_group_name> to read management-saved-search in tenancy allow dynamic-group <dynamic_group_name> to {LOG_ANALYTICS_QUERY_VIEW} in tenancy allow dynamic-group <dynamic_group_name> to {LOG_ANALYTICS_QUERYJOB_WORK_REQUEST_READ} in tenancy allow dynamic-group <dynamic_group_name> to READ loganalytics-log-group in tenancy allow dynamic-group <dynamic_group_name> to {LOG_ANALYTICS_LOOKUP_READ} in tenancy allow dynamic-group <dynamic_group_name> to read compartments in tenancy

-

Einige der oben genannten Policy-Anweisungen sind in den verfügbaren, von Oracle definierten Policy Templates enthalten. Sie können die Vorlage für Ihren Anwendungsfall verwenden. Siehe Von Oracle definierte Policy-Vorlagen für allgemeine Anwendungsfälle.

-

Informationen zu dynamischen Gruppen und IAM-Policys finden Sie in der OCI-Dokumentation: Dynamische Gruppen verwalten und der OCI-Dokumentation: Policys verwalten.

-

Die Policy-Details finden Sie unter Metrikabfragen erstellen - Voraussetzungen in der Oracle Cloud Infrastructure-Dokumentation.

-

Die API-Referenz zu geplanten Aufgaben finden Sie unter ScheduledTask-Referenz in der Oracle Cloud Infrastructure-API-Dokumentation.

Alle geplanten Aufgaben in einem Compartment mit der API anzeigen

Um die geplanten Aufgaben für eine bestimmte gespeicherte Suche anzuzeigen, können Sie die Detailseite der gespeicherten Suche aufrufen. Wenn Sie jedoch alle geplanten Aufgaben in einem bestimmten Compartment auflisten möchten, ohne die gespeicherten Suchvorgänge zu referenzieren, für die die geplanten Aufgaben erstellt wurden, fragen Sie die Liste der geplanten Aufgaben mit der API ab. Siehe ListScheduledTasks.

Geben Sie die folgenden Parameter im GET-Befehl an:

taskType=SAVED_SEARCHcompartmentId=<compartment_OCID>limit=1000sortOrder=DESCsortBy=timeUpdated

Zum Ausführen des Befehls benötigen Sie Folgendes:

- Namespace: Der Log Analytics-Namespace, den Sie beim Erstellen der geplanten Aufgaben angegeben haben.

- Compartment-OCID: Die OCID des Compartments, das Sie nach der Liste der darin erstellten geplanten Aufgaben abfragen möchten.

Geplante Aufgaben der gespeicherten Suche überwachen

Sie können den Zustand der geplanten Aufgaben der gespeicherten Suche über die Metriken Ausführungsstatus der geplanten Aufgabe im Monitoring-Service überwachen. Im Falle einer nicht erfolgreichen oder übersprungenen Ausführung einer Aufgabe aufgrund einer Infrastrukturanomalie oder wenn eine abhängige Ressource oder Konfiguration geändert wird, enthält die Metrik Details zu Fehlern, die Sie bei der Korrektur unterstützen.

Die Schritte zum Zugriff auf die Metrik "Ausführungsstatus für geplante Aufgaben" finden Sie unter Log Analytics mit Servicemetriken überwachen.

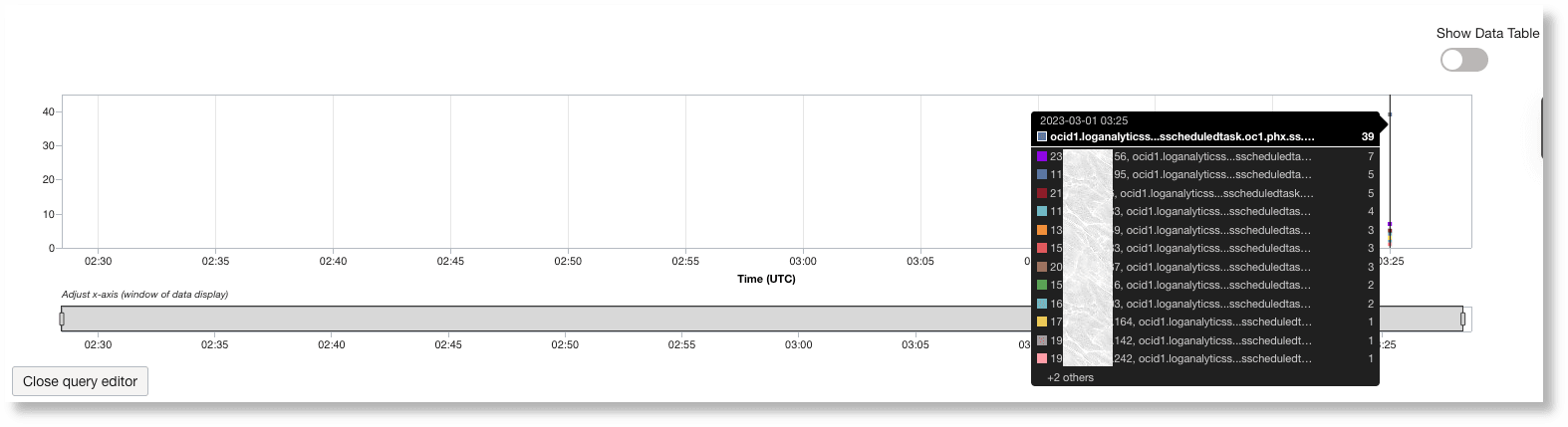

Jede geplante Aufgabe der gespeicherten Suche hat ein eigenes Intervall, wie im Aufgabenplan angegeben. Für jede geplante Aufgabenausführung wird eine Metrik an Ihren Mandanten ausgegeben. Bewegen Sie den Cursor auf die Datenpunkte im Diagramm, um weitere Details zur Aufgabe anzuzeigen. Sie können die Metrikdaten basierend auf einer der Dimensionen Status, DisplayName oder ResourceId filtern.

- Öffnen Sie das Navigationsmenü, und klicken Sie auf Observability and Management. Klicken Sie unter Log Analytics auf Administration.

-

Die Administrationsressourcen werden im linken Navigationsbereich unter Administration aufgeführt. Klicken Sie auf Erkennungsregeln. Klicken Sie auf der Listenseite für Erkennungsregeln auf den Namen der Erkennungsregel für gespeicherte Suchen, die Sie öffnen möchten. Die Detailseite der Erkennungsregel wird geöffnet.

-

Klicken Sie auf Metriken. Die Registerkarte "Metriken" wird geöffnet.

-

Klicken Sie oben rechts in der Metrik "Ausführungsstatus für geplante Aufgaben" auf das Menü Optionen, und wählen Sie In Metrik-Explorer anzeigen aus.

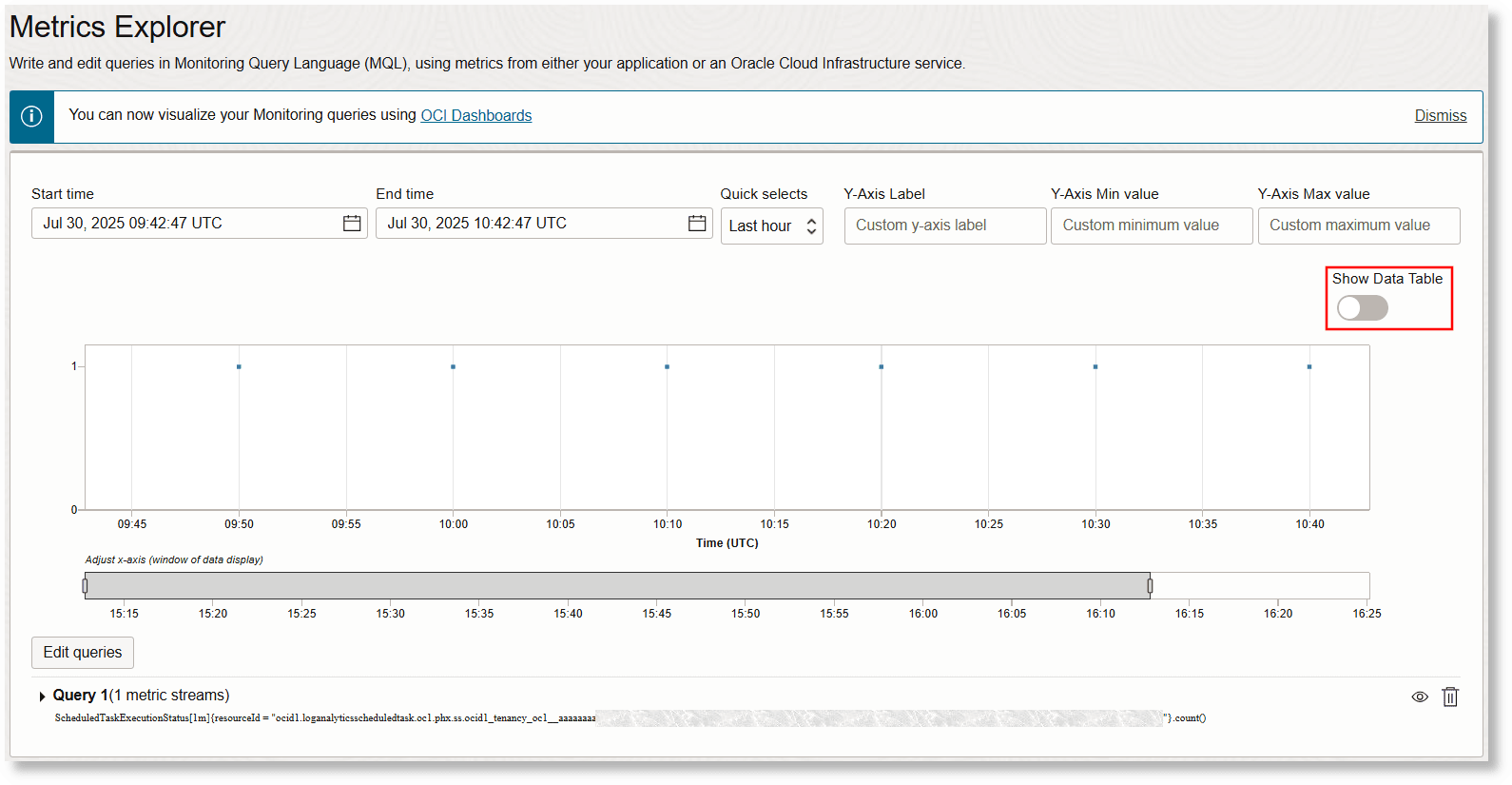

Die Metrik wird jetzt im Metrik-Explorer angezeigt. Hier können Sie das Diagramm genauer untersuchen.

Schieben Sie die Schaltfläche Datentabelle anzeigen, um die Details der Metriken anzuzeigen:

-

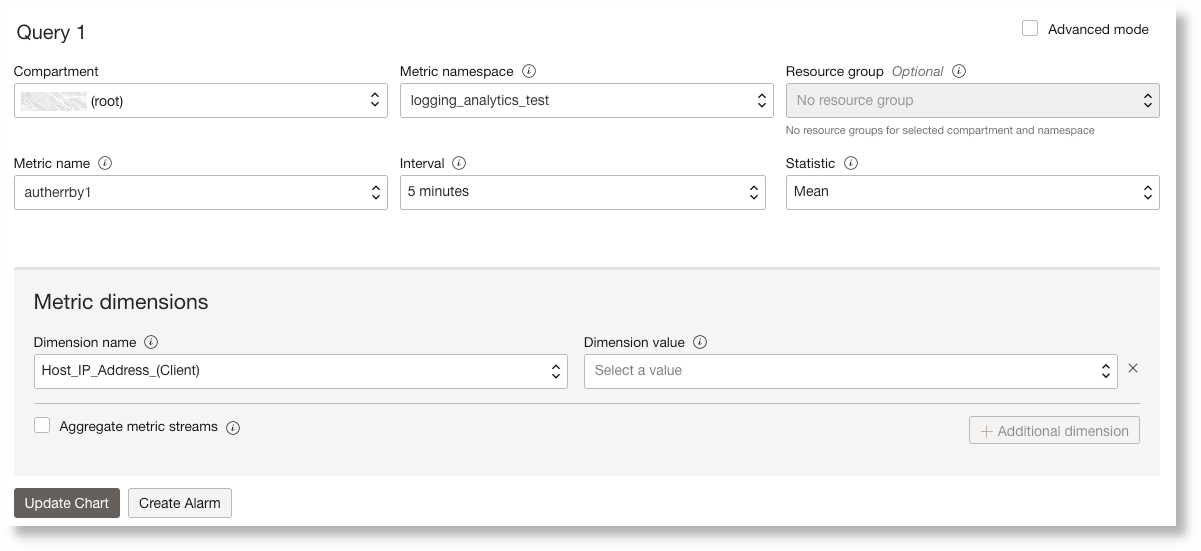

Klicken Sie auf Abfragen bearbeiten, und wählen Sie Dimensionsname und Dimensionswert für die Metrik aus. Sie können die Metrikdaten basierend auf

taskResultfiltern, dem Ergebnis der Ausführung der geplanten Aufgabe,Statusder Aufgabenausführung, demDisplayNameder Aufgabe, demqueryExecTimeRangeoder dem zugehörigenResourceId.Hinweis

Um Diagramme und tabellarische Daten im Metrik-Explorer anzuzeigen, indem Sie einen Dimensionsnamen und einen Dimensionswert angeben, vermeiden Sie die Verwendung von Feldern, die Klammern oder andere Sonderzeichen im Namen enthalten. Wenn das für den Dimensionsnamen ausgewählte Feld Sonderzeichen enthält, erstellen Sie ein virtuelles Feld mit dem Befehl

eval, oder benennen Sie das vorhandene Feld mit dem Befehlrenameum, sodass die Klammern oder Sonderzeichen entfernt werden. Beispiel: Wenn das Feld für den DimensionsnamenHost Name (Server)lautet, können Sie ein virtuelles Feldhostnamemit| eval hostname=“Host Name (Server)”erstellen.Die Dimension

queryExecTimeRangeist nützlich, um die Zeit für die Ausführung der geplanten Aufgabenabfrage zu bestimmen. Die verfügbaren Werte sind< 5s,>= 5s and < 10s,>= 10s and < 30sund> 30s. In der Regel werden Abfragen, die mehr als 30 Sekunden dauern, in Bezug auf die Ausführungszeit als teuer betrachtet. Lesen Sie dazu How to Make Your Queries Performant.Die Dimension

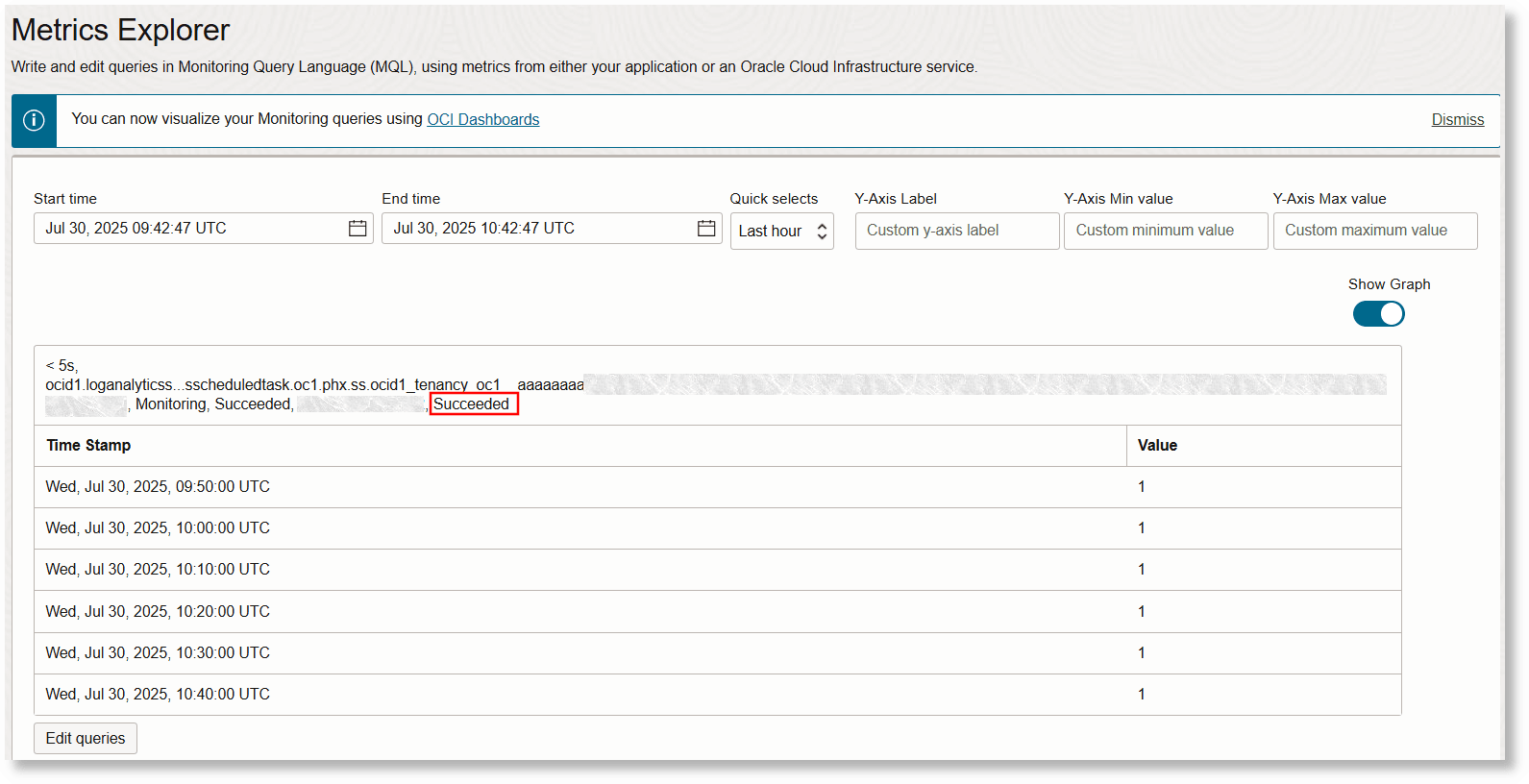

taskResultkann die WerteSucceeded,FailedundPausedaufweisen. Die DimensionStatusenthält weitere Details zutaskResult. Beispiel: Wenn der Wert vontaskResultPausedist, kann der Wert vonStatusPaused by Usersein.Klicken Sie auf Diagramm aktualisieren, um die Diagrammvisualisierung zu aktualisieren. Das Diagramm zeigt jetzt nur die Datenpunkte an, für die Sie den Filter angewendet haben.

Sie können zur Datentabelle-Ansicht wechseln, wenn Sie eine tabellarische Darstellung der erfassten Datenpunkte anzeigen möchten.

-

Ändern Sie den Dimensionsnamen, um verschiedene Perspektiven im Diagramm anzuzeigen.

Sie können Alerts einrichten, um Sie über den Status per E-Mail, SMS, Slack, PagerDuty, HTTPS-Endpunkt-URL oder Funktion zu benachrichtigen. Siehe Alerts für ermittelte Ereignisse erstellen.

Im Folgenden werden die verschiedenen Werte der Dimension status aufgeführt, die über diese Metrik für bestimmte taskResult-Werte gemeldet werden:

Wert taskResult

|

Wert Status

|

Beschreibung | Empfohlener Fix |

|---|---|---|---|

|

|

|

Die Ausführung der Task ist normal |

NA |

|

|

Die geplante Aufgabenausführung war erfolgreich, aber das Senden der Metriken an den Monitoring-Service wurde aufgrund der Metrikdatenlimits abgeschnitten. |

Stellen Sie sicher, dass die Metriken in den angegebenen Grenzwerten bleiben. Siehe OCI-CLI-Befehlsreferenz - Metrikdaten für Monitoring-Service. |

|

|

|

Wenn die Ausführung der geplanten Aufgabe erfolgreich war, die Abfrage jedoch keine Ergebnisse zurückgegeben hat. Daher werden keine Metrikdaten an den Monitoring-Service gepostet. |

Prüfen Sie Ihre gespeicherte Suchabfrage. Dieser Status bedeutet möglicherweise keinen Fehler. Es deutet nur darauf hin, dass das Ereignis, für das die Abfrage geschrieben wurde, nicht eingetreten ist. Beispiel: Wenn die Abfrage die Anzahl der Fehler in den Logs in den letzten 5 Minuten zählen soll und wenn die in den letzten 5 Minuten eingegangenen Logs keine Fehler aufweisen, wird |

|

|

|

Teilergebnisse aufgrund teurer Abfragen, die mehr als zwei Minuten dauern oder aufgrund einer Infrastrukturanomalie. |

Wenden Sie sich mit den Informationen zum Status an Oracle Support. |

|

|

|

Teilergebnisse aufgrund teurer Abfragen, die mehr als zwei Minuten dauern oder aufgrund einer Infrastrukturanomalie. |

Wenden Sie sich mit den Informationen zum Status an Oracle Support. |

|

|

|

|

Die Ausführung der Aufgabe war aufgrund einer Infrastrukturanomalie oder eines behebbaren Fehlers nicht erfolgreich. |

Wenden Sie sich mit den Informationen zum Status an Oracle Support. |

|

|

|

Die Abfragezeichenfolge oder der Geltungsbereichsfilter der gespeicherten Suche sind nicht gültig. |

Prüfen Sie, ob die gespeicherte Suche nach der Erstellung der geplanten Aufgabe bearbeitet wurde, und korrigieren Sie sie. |

|

|

Die gespeicherte Suche wird gelöscht, oder die IAM-Policy, die READ-Berechtigungen für die gespeicherte Suche bereitstellt, wurde geändert. |

Stellen Sie sicher, dass die IAM-Policy wiederhergestellt ist. |

|

|

|

Die gespeicherte Suchabfrage ist für die Generierung der Metrik nicht gültig. |

Prüfen Sie, ob die gespeicherte Suche nach der Erstellung der geplanten Aufgabe bearbeitet wurde, und korrigieren Sie sie. |

|

|

|

Wenn die geplante Aufgabe zum Löschen von Logdaten verwendet wird und das Compartment zum Löschen gelöscht wird oder wenn sich die IAM-Policy zum Löschen nach der Erstellung der geplanten Aufgabe geändert hat, wird dieser Status angezeigt. |

Prüfen Sie, ob das Lösch-Compartment gelöscht wurde, und stellen Sie es wieder her. Stellen Sie sicher, dass die IAM-Policy wiederhergestellt ist. |

|

|

|

Einer der folgenden beiden Gründe kann den Status auslösen:

|

Wenn die Metrikdetails unvollständig oder ungültig sind, aktualisieren Sie die Metrikdetails in der Definition der geplanten Aufgabe. Wenn die Metrikspalte nicht numerisch ist oder der Dimensionswert nicht "Kardinal" ist, aktualisieren Sie die gespeicherte Suche, um eine gültige Metrik und Dimension zu erstellen. |

|

|

|

Wenn der Wert von |

Geben Sie die Benutzeraktion an, mit der die Ausführung der geplanten Aufgabe unterbrochen und die geplante Aufgabe ausgeführt wurde. |

Wichtige Faktoren für die Erstellung geplanter Aufgaben

Notieren Sie sich die folgenden Faktoren für die Erstellung geplanter Aufgaben:

-

Anforderungen zum Verfassen von Abfragen:

Wenn Sie Abfragen erstellen, um geplante Aufgaben zu erstellen, stellen Sie sicher, dass Sie die folgenden Anforderungen erfüllen:

- Beachten Sie die folgenden Einschränkungen für Erkennungsregelabfragen:

-

Führen Sie keine Platzhaltersuche für das Feld Ursprünglicher Loginhalt in der Abfrage der geplanten Aufgabe durch. Weitere Informationen zu Platzhaltersuchen finden Sie unter Schlüsselwörter, Wortgruppen und Platzhalter verwenden.

-

Auf den Befehl

timestatsdürfen nichteval,extract,jsonextract,xmlextractundlookupfolgen. -

Der Befehl

regexdarf nicht für große Felder wieMessageverwendet werden, um zu vermeiden, dass die Abfragen für die Verarbeitung teuer werden.Die Befehle

likecompare undextract,jsonextract,xmlextractwerden bei großen Feldern wieMessagenicht unterstützt.Linkfelder oder -felder, die in der Klausel

BYverwendet werden, können nicht für große Felder wieMessageverwendet werden. -

The commands which are not supported in the queries for scheduled tasks are

cluster,clustercompare,clusterdetails,clustersplit,compare,createview,delta,fieldsummary,highlightgroups,geostats,linkdetails,map,nlpandtimecompare.

-

- Maximale Limits:

Die maximale Anzahl der für die

by-Klausel unterstützten Felder ist 3.Die maximale Anzahl der für den Befehl

timestatsunterstützten Felder ist 3.Die maximale Anzahl der unterstützten Aggregatfunktionen in einer Abfrage für geplante Aufgaben ist 1.

- Verwenden Sie die Werte der Felder

linkals Dimensionen zum Veröffentlichen von Metriken:Wählen Sie bis zu drei Dimensionsfelder und eine numerische Metrik aus, die in den Monitoring-Service übertragen werden soll. Um anzugeben, welche Felder für das Monitoring veröffentlicht werden müssen, müssen die Abfragen enden mit:

... | link ... | fields -*, dim1, dim2, dim3, metric1Der Befehl

linkenthält standardmäßig mehrere Spalten in der Ausgabe, wie Startzeit, Endzeit, Anzahl usw. Verwenden Sie-*im Befehlfields, um diese Felder zu entfernen und optional bis zu drei Dimensionsfelder und ein obligatorisches Metrikfeld anzugeben.Sie können mehrere

eval-Anweisungen nach demstats-Befehl und mehrerestats-Funktionen zur Berechnung von Zwischenergebnissen verwenden. Die Abfrage muss jedoch mitfields -*, dim1, dim2, dim3, metric1enden, das angibt, welche Dimensionen und Metriken gepostet werden müssen. Verwenden Sie die folgenden Richtlinien für Erkennungsregelabfragen:- Verwenden Sie den Befehl 2

addfields. - Verwenden Sie bis zu 3

stats-Funktionen. eval-Anweisungen sind für die Berechnung von Zwischen- und Endergebnissen erforderlich.

Beispielabfragen:

'Log Source' = 'OCI Email Delivery' | link 'Entity' | addfields [ * | where deliveryEventType = r and bounceType = hard | stats count as 'hard bounces' ], [ * | where deliveryEventType = e and length(ipPoolName) > 0 | stats count as 'total sent messages' ] | eval 'Total Rate' = ('hard bounces' / 'total sent messages') * 100 | fields -*, 'Entity', 'Total Rate''Log Source' = 'My Network Logs' | stats sum(Success) as TotalSuccess, sum(Failure) as TotalFailure | eval SuccessRate = (TotalSuccess / (TotalSuccess + TotalFailure)) * 100 | fields -*, SuccessRate - Verwenden Sie den Befehl 2

- Beachten Sie die folgenden Einschränkungen für Erkennungsregelabfragen:

-

Verspätete Ankunft von Logs:

Wenn die geplanten Aufgaben vor dem Eintreffen der Logs ausgeführt werden, geben die geplanten Aufgaben möglicherweise nicht wie erwartet die Ergebnisse zurück. Um zu vermeiden, dass solche Logs in den geplanten Aufgaben aufgrund ihrer verspäteten Ankunft fehlen, muss die Abfrage sie mit einer Anpassung des Zeitraums berücksichtigen.

Beispiel: Wenn die geplante Aufgabe alle 5 Minuten ausgeführt wird, um die Anzahl der Authentifizierungsfehler zu prüfen, und wenn zwischen dem Zeitpunkt, zu dem die Logs generiert werden, und dem Zeitpunkt, zu dem sie Oracle Log Analytics erreichen, eine Verzögerung von 3 Minuten auftritt, erkennt die geplante Aufgabe die Logs nicht. Die geplante Aufgabe wird alle 5 Minuten ausgeführt, z.B. 01:00, 01:05, 01:10 usw. Wenn der Logdatensatz L1, der um 01:04 generiert wird, um 01:07 Uhr Oracle Log Analytics erreicht. L1 wird in der geplanten Aufgabe, die um 1:05 ausgeführt wurde, nicht erkannt, weil das Log zu diesem Zeitpunkt nicht bei Oracle Log Analytics angekommen ist. Bei der nächsten Ausführung um 01:10 Uhr sucht die Abfrage nach Logs mit Zeitstempeln zwischen 01:05 und 01:10. Auch in diesem Zyklus wird L1 nicht erkannt, da er einen Zeitstempel von 01:04 hat. Bei der folgenden Abfrage werden möglicherweise nicht alle Logdatensätze angezeigt, wenn die Logs verspätet eingehen:

Label = 'Authentication Error' | stats count as logrecords by 'Log Source'Um die Verzögerung bei der Ankunft der Logs in Oracle Log Analytics zu bestimmen, berechnen Sie die Differenz zwischen dem im Logdatensatz angegebenen Zeitstempel und der Buchungszeit des Logprozessors. Mit der folgenden Beispielabfrage kann geprüft werden, ob eine Verzögerung vorliegt:

Label = 'Authentication Error' and 'Log Processor Posting Time (OMC INT)' != null | fields 'Agent Collection Time (OMC INT)', 'Data Services Load Time', 'Process Time', 'Log Processor Posting Time (OMC INT)'Die folgende Abfrage verwendet die Funktion

dateRelative, um die Verzögerung von 3 Minuten in einer Aufgabe anzupassen, die im 5-Minuten-Intervall ausgeführt wird:Label = 'Authentication Error' and Time between dateRelative(8minute, minute) and dateRelative(3minute, minute) | stats count as logrecords by 'Log Source' -

Weitere Faktoren:

-

Informationen zum Erstellen von Abfragen im Monitoring-Service finden Sie unter Metrikabfragen erstellen in der Oracle Cloud Infrastructure-Dokumentation.

-

Beachten Sie die Grenzwerte für die Veröffentlichung der Metrikdaten im Monitoring-Service. Die Limits entsprechen den Metriken für eine geplante Aufgabe. Siehe

PostMetricData APIin der Oracle Cloud Infrastructure-Dokumentation.Wenn Ihre gespeicherte Suche mehr als 200 eindeutige Werte für Feld generieren kann, werden Teilergebnisse aufgrund der vom Monitoring-Service festgelegten Limits veröffentlicht. Verwenden Sie in solchen Fällen den Befehl sort, um die Ergebnisse top 200 oder bottom anzuzeigen.

-

Beispielabfragen für geplante Aufgaben

Beispielabfragen zum Anzeigen von Metriken

-

Ein Beispiel, in dem Sie die Anzahl der Authentifizierungsfehler bei einer geplanten Ausführung alle 5 Minuten kennen möchten:

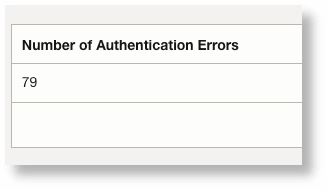

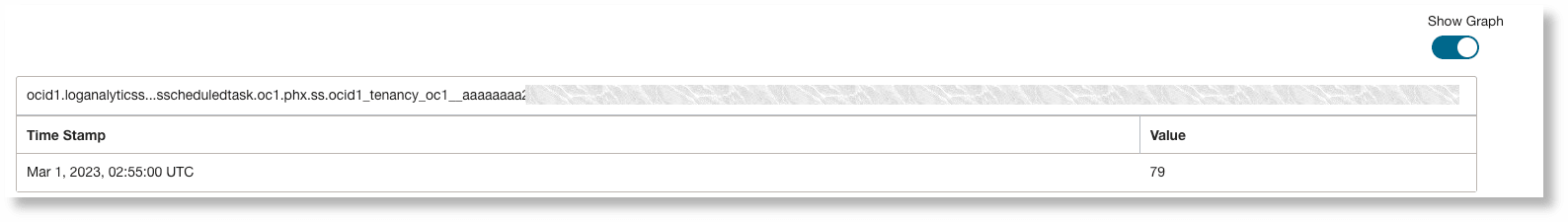

Label = 'Authentication Error' | stats count as 'Number of Authentication Errors'Wenn die Visualisierung der Übersichtstabelle im Log Explorer ausgewählt ist, wird die folgende Ausgabe angezeigt:

Wenn die geplante Aufgabe eine Metrik wie die oben genannte ausführt, wird diese im Monitoring-Service veröffentlicht.

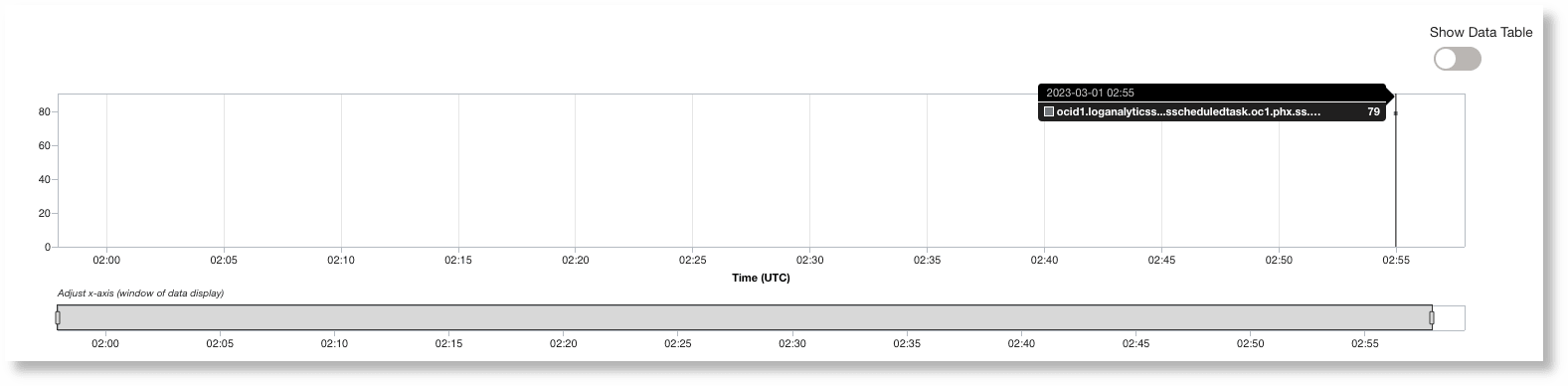

Im Metrik-Explorer können Sie die oben gepostete Metrik wie folgt anzeigen:

Klicken Sie auf Datentabelle anzeigen, um die Metrik im tabellarischen Format anzuzeigen:

-

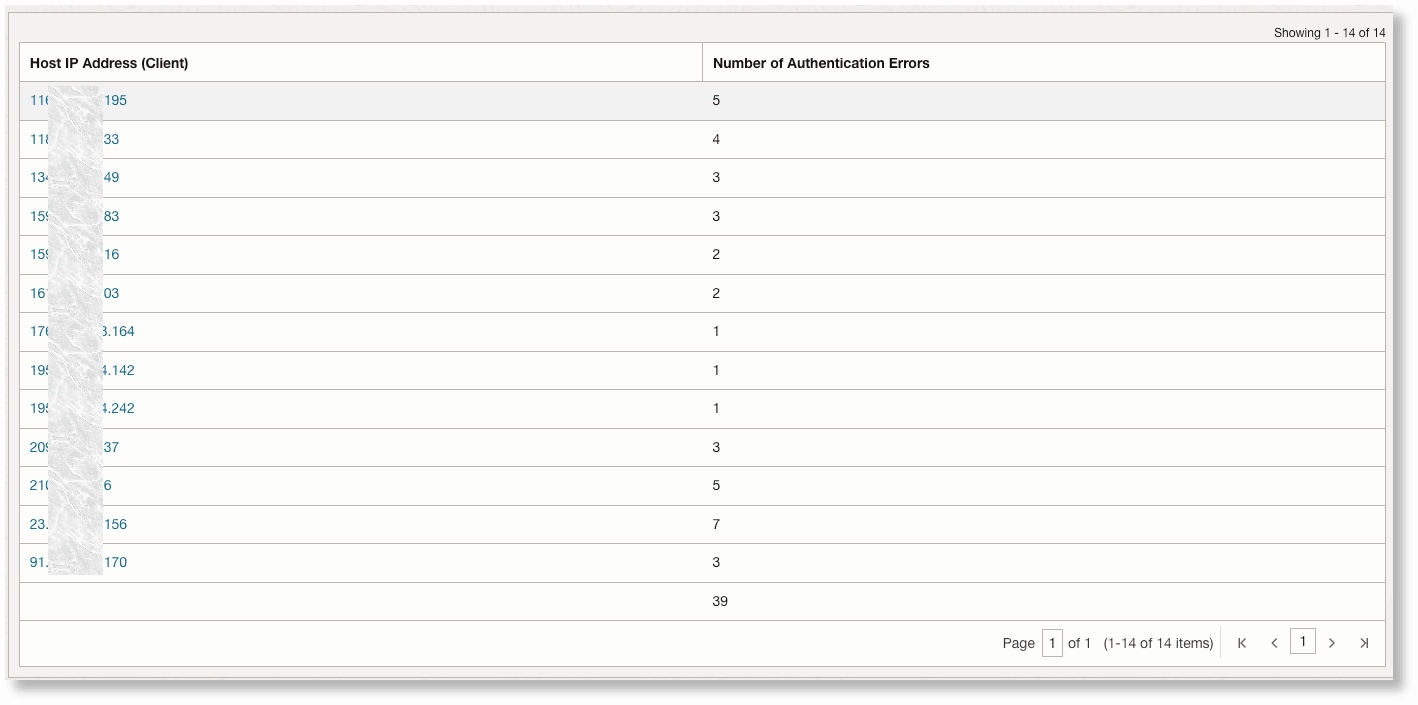

Wenn Sie die Aufschlüsselung der Authentifizierungsfehler in jedem Host kennen möchten:

Label = 'Authentication Error' | stats count as 'Number of Authentication Errors' by 'Host IP Address (Client)'Mit der Übersichtsvisualisierung können Sie eine Vorschau der Metrikausgabe für Ihre Abfrage anzeigen.

Auf der Seite "Metrik-Explorer" sieht dieselbe Metrik nach Host-IP-Diagramm folgendermaßen aus:

Um die Anzahl pro Host-IP anzuzeigen, geben Sie als Metrikdimensionsnamen Host_IP_Address_Client an, und deaktivieren Sie das Kontrollkästchen Metrikstreams aggregieren:

Wie Sie Ihre Abfragen ausführen

Einige der Abfragen führen zu hohen Ausführungszeiten oder in einigen Fällen zu einem Timeout und führen schließlich zu verzögerten Ausführungen ihrer eigenen Aufgaben. In solchen Fällen wird empfohlen, erweiterte Felder (EFD) oder Labels zu erstellen und sie in den Filtern in Ihren geplanten Abfragen zu verwenden, um die Abfragen kostengünstiger zu gestalten.

Beispiel: Wenn Sie die Anzahl der Verbindungstimeouts in den Datenbank-Alertlogs alle 5 Minuten posten möchten, können Sie sie mit der folgenden Abfrage ausführen:

'Log Source' = 'Database Alert Logs' and 'TNS-12535' | stats count as 'Number of Timeouts'Die obige Abfrage sucht nach der Zeichenfolge TNS-12535 in Ursprünglicher Loginhalt. Dies ist jedoch nicht der effizienteste Weg, um nach den Timeouts zu suchen, insbesondere wenn die Aufgabe alle 5 Minuten ausgeführt werden soll und Millionen von Datensätzen durchsucht werden.

Verwenden Sie stattdessen das Feld, in das diese Fehler-ID extrahiert wird, und erstellen Sie die Abfrage wie unten gezeigt:

'Log Source' = 'Database Alert Logs' and 'Error ID' = 'TNS-12535' | stats count as 'Number of Timeouts'Alternativ können Sie mit dem Label filtern:

'Log Source' = 'Database Alert Logs' and Label = Timeout | stats count as 'Number of Timeouts'In von Oracle definierten Logquellen sind viele EFDs und Labels definiert. Für benutzerdefinierte Logs wird empfohlen, eigene Labels und EFDs zu definieren und in den geplanten Abfragen zu verwenden, anstatt in Ursprünglicher Loginhalt zu suchen. Siehe Label erstellen und Erweiterte Felder in Quellen verwenden.