Formazione e test degli intenti

L'addestramento di un modello con il tuo corpus di addestramento consente al tuo bot di discernere ciò che gli utenti dicono (o, in alcuni casi, stanno cercando di dire).

È possibile migliorare l'acuità della cognizione attraverso cicli di test dell'intento e addestramento dell'intento. L'addestramento viene controllato solo mediante le definizioni degli intenti; l'abilità non può imparare da sola dalla chat utente.

Utensili di prova

Ti consigliamo di mettere da parte il 20% del tuo corpus per il test dell'intento e utilizzare il restante 80% per addestrare i tuoi intenti. Mantieni questi due set separati in modo che le espressioni di prova, che incorporerai nei casi di test, rimangano "sconosciute" alla tua abilità.

Applicare la divisione 80/20 al data set di ogni intento. Randomizza le tue espressioni prima di fare questa divisione per consentire ai modelli di allenamento di pesare equamente i termini e i modelli nelle espressioni.

Il tester di discorso

Il tester di pronuncia è la tua finestra sulla cognizione della tua abilità. Inserendo frasi che non fanno parte del corpus di addestramento, puoi scoprire quanto bene hai creato i tuoi intenti esaminando il ranking di affidabilità degli intenti e il JSON restituito. Questa classifica, che è la stima dello skill per il candidato migliore per risolvere l'input dell'utente, dimostra la sua acutezza al momento corrente.

Descrizione dell'immagine enunciance-tester-quick-test.png

Utilizzando il tester Utterance, è possibile eseguire test rapidi per test una tantum o incorporare un enunciato come caso di test per valutare la risoluzione dell'intento in diverse versioni dei modelli di addestramento.

Test di esempio

Ogni test ha un enunciato e l'intento che si prevede di risolvere, che è noto come una corrispondenza di etichetta. Un caso di test può anche includere valori di entità corrispondenti e la lingua prevista per l'espressione. È possibile eseguire casi di test quando si sviluppa uno skill e in seguito, quando lo skill è in produzione, è possibile utilizzare i casi di test per i test di regressione. In quest'ultimo caso, è possibile eseguire casi di test per scoprire se una nuova release del modello di addestramento ha influito negativamente sulla risoluzione dell'intento.

Analogamente ai casi di test creati con il tester conversazione, i casi di test di pronuncia fanno parte dello skill e vengono associati a ciascuna versione. Se si estende uno skill, l'estensione eredita i casi di test. Mentre i casi di test di conversazione hanno lo scopo di testare uno scenario, i casi di test di pronuncia hanno lo scopo di testare i frammenti di una conversazione in modo indipendente, garantendo che ogni pronuncia si risolva nell'intento corretto.

Gestisci casi di test

nluTestSuites che ospita le suite di test dello skill quando lo skill viene esportato.Crea suite di test

- Fare clic su + Test Suite.

- Nella scheda Generale, sostituire il nome del segnaposto (ad esempio, TestSuite0001) con un nome più significativo aggiungendo un valore nel campo Nome visualizzazione.

- Facoltativamente, aggiungere una descrizione che illustri la funzionalità inclusa nella suite di test.

- Popolare la suite di test con i casi di test utilizzando uno dei metodi seguenti (o una combinazione di):

- Aggiunta manuale di casi di test (creando un caso di test o salvando un'espressione come caso di test dal tester Utterance).

- Importazione dei casi di test.

Nota

Per assegnare un caso di test a una suite di test tramite importazione, il campotestSuitedel file CSV può essere vuoto oppure deve contenere un nome che corrisponda alla suite di test selezionata nella finestra di dialogo di importazione. - Modifica di un caso di test per riassegnare la suite di test.

- Se si desidera escludere la suite di test dalle esecuzioni di test avviate utilizzando le opzioni Tutto ed Esegui tutto, disattivare Abilita suite di test.

- Se non si desidera che la suite di test sia inclusa nell'esportazione degli skill, disattivare Includi nell'esportazione degli skill. Quando si disattiva questa opzione per una suite di test, non verrà inclusa nella cartella

nluTestSuitesche contiene le suite di test dello skill nel file ZIP esportato.

Crea casi di test di Utterance

È possibile aggiungere casi di test uno per uno utilizzando il tester di Utterance o la finestra di dialogo Nuovo caso di test (a cui è possibile accedere facendo clic su + Caso di test) oppure è possibile aggiungerli in massa caricando un file CSV.

Poiché ogni caso di test deve appartenere a una suite di test, prima di creare un caso di test è consigliabile creare una suite di test che rifletta la capacità della competenza o alcuni aspetti del test dell'intento, ad esempio test non riusciti, test nel dominio o test fuori dominio.

Suggerimento

Per fornire una copertura adeguata nei tuoi test, crea espressioni della suite di test che non sono solo diverse concettualmente, ma anche grammaticalmente poiché gli utenti non faranno richieste in modo uniforme. È possibile aggiungere queste dimensioni creando suite di test a partire da un messaggio utente effettivo su cui sono state eseguite query nel Ritrainer di approfondimenti e anche da input provenienti dalla massa raccolti da Data Manufacturing.Aggiungi casi di test dal tester di pronuncia

- Fare clic su Test degli argomenti.

- Se lo skill è multilingue, selezionare la lingua nativa.

- Immettere l'espressione, quindi fare clic su Test.

- Fare clic su Salva come caso di test, quindi scegliere una suite di test.

Creare un caso di test

- Fare clic su Vai a casi di test nel tester Utterance.

- Fare clic su + Caso di test.

- Completare la finestra di dialogo Nuovo caso di test:

- Se necessario, disabilitare il caso di test.

- Immettere l'espressione del test.

- Selezionare la suite di test.

- Selezionare l'intento previsto. Se si sta creando un caso di test per il test non riuscito, selezionare unresolvedIntent.

- Per le competenze multilingue, selezionare il tag della lingua e la lingua prevista.

- Fare clic su Aggiungi a suite. Nella pagina Casi di test è possibile eliminare un caso di test o modificare un caso di test, che include la riassegnazione del caso di test a una suite di test diversa.

- Per eseguire il test dei valori di entità:

- Attivare Entità di test. Fare clic su Continua.

- Evidenziare la parola (o le parole) e quindi applicare un'etichetta entità selezionando un'entità dall'elenco. Al termine, fare clic su Aggiungi a suite.

Nota

Selezionare sempre parole o frasi dall'espressione del caso di test dopo aver abilitato Entità di test. Il caso di test non riuscirà se è stata abilitata l'opzione Entità di test, ma non sono state evidenziate parole.

Importa casi di test per suite di test a livello di skill

testSuite: il nome della suite di test a cui appartiene il caso di test. Il campotestSuitein ogni riga del file CSV può avere un nome di suite di test diverso o può essere vuoto.- I casi di test con campi

testSuitevuoti vengono aggiunti a una suite di test selezionata quando si importa il file CSV. Se non si seleziona una suite di test, verrà assegnata alla suite di test predefinita. - I casi di test con campi

testSuitepopolati vengono assegnati alla suite di test selezionata quando si importa il file CSV solo quando il nome della suite di test selezionata corrisponde al nome nel campotestSuite. - Se una suite di test con il nome specificato nel campo

testSuitenon esiste già, verrà creata dopo l'importazione del file CSV.

- I casi di test con campi

utterance- Esempio di espressione (obbligatorio). È mappato aquerynelle versioni precedenti alla 21.04 di Oracle Digital Assistant.expectedIntent: l'intento corrispondente (obbligatorio). Questo campo è mappato aTopIntentnelle versioni precedenti alla 21.04 di Oracle Digital Assistant.Suggerimento

Importazione delle versioni precedenti alla versione 21.04 del file CSV indica come riformattare i file CSV precedenti alla versione 21.04 in modo da poterli utilizzare per il test di massa.enabled:TRUEinclude il caso di test nell'esecuzione del test.FALSElo esclude.languageTag: il tag della lingua (en, ad esempio). Se non è presente alcun valore, per impostazione predefinita viene utilizzata la lingua rilevata dalle impostazioni della lingua dello skill.expectedLanguageTag(facoltativo): per le competenze multilingue, questo è il tag della lingua che si desidera utilizzare dal modello quando si risolve l'espressione del test in un intento. Affinché il caso di test passi, questo tag deve corrispondere alla lingua rilevata.expectedEntities: le entità corrispondenti nell'espressione del caso di test, rappresentate come un array di oggettientityName. OgnientityNameidentifica la posizione del valore dell'entità nell'espressione utilizzando le proprietàbeginOffseteendOffset. Questo offset è determinato dal carattere, non dalla parola, ed è calcolato dal primo carattere dell'espressione (0-1). Ad esempio, l'oggettoentityNameper il valore di entità PizzaSize piccolo in Voglio ordinare una pizza piccola è:[{"entityName":"PizzaSize","beginOffset":18,"endOffset":23,"originalString":"small"}, …]

- Fare clic su Altro, quindi selezionare Importa.

- Individuare e selezionare il file CSV.

- Scegliere la suite di test. Il caso di test può essere assegnato alla suite di test selezionata solo se il campo

testSuiteè vuoto o corrisponde al nome della suite di test selezionata. - Fare clic su Carica.

Importazione delle versioni precedenti alla versione 21.04 del file CSV

query e TopIntent vengono aggiunti solo alla suite di test predefinita. È possibile riassegnare questi casi di test ad altre suite di test singolarmente modificandoli dopo aver importato il file CSV oppure aggiornare il file CSV nel formato corrente e quindi modificarlo prima di importarlo come indicato di seguito.

- Fare clic su Altro > Importa.

- Al termine dell'importazione, selezionare Suite di test predefinita, quindi fare clic su Altro > Esporta suite selezionata. Il file esportato verrà convertito nel formato corrente.

- Estrai il file ZIP e modifica il file CSV. Al termine, importare di nuovo il file CSV (Altro > Importa). Potrebbe essere necessario eliminare i casi di test duplicati dalla suite di test predefinita.

Nota

Se si carica lo stesso CSV più volte con modifiche di lieve entità, i dati nuovi o aggiornati verranno uniti al vecchio: vengono applicati nuovi aggiornamenti e vengono inserite nuove righe. Non è tuttavia possibile eliminare espressioni caricando un nuovo file CSV. Se è necessario eliminare le espressioni, è necessario eliminarle manualmente dall'interfaccia utente.

Crea esecuzioni del test

Le esecuzioni dei test sono una raccolta di casi di test o suite di test volti a valutare alcuni aspetti della cognizione dell'abilità. Il contenuto (e il volume) di un'esecuzione di test dipende dalla capacità che si desidera sottoporre a test, pertanto un'esecuzione di test potrebbe includere un sottoinsieme di casi di test da una suite di test, una suite di test completa o più suite di test.

I casi di test inclusi in un'esecuzione di test vengono valutati in base alla soglia di affidabilità impostata per lo skill. Affinché un caso di test passi nell'esecuzione del test complessivo, deve raggiungere o superare la soglia di affidabilità prevista. Se specificato, il caso di test deve soddisfare anche il valore dell'entità e i criteri di corrispondenza della lingua. Esaminando i risultati dell'esecuzione del test, è possibile scoprire se le modifiche apportate alla piattaforma o all'abilità stessa hanno compromesso l'accuratezza della risoluzione dell'intento.

Oltre a testare il modello, è possibile utilizzare i risultati dell'esecuzione del test per valutare l'affidabilità del test. Ad esempio, i risultati che mostrano che quasi tutti i casi di test sono stati superati potrebbero, in superficie, indicare il funzionamento ottimale del modello. Tuttavia, una revisione dei casi di test di superamento può rivelare che i casi di test non riflettono l'allenamento corrente perché le loro espressioni sono troppo semplici o hanno una sovrapposizione significativa in termini di concetti e verbosità per cui stanno testando. Un numero elevato di test non riusciti, d'altra parte, potrebbe indicare carenze nei dati di addestramento, ma una revisione di questi casi di test potrebbe rivelare che le loro affermazioni sono accoppiate con gli intenti previsti sbagliati.

- Fare clic su Esegui tutto per creare un'esecuzione di test per tutti i casi di test in una suite di test selezionata. In alternativa, se si desidera eseguire tutte le suite di test, selezionare Tutto, quindi fare clic su Esegui tutto.

- Per creare un'esecuzione di test per una selezione di casi di test all'interno di una suite (o un'esecuzione di test per un subset di tutti i casi di test se si seleziona Tutti), filtrare i casi di test aggiungendo una stringa che corrisponda al testo dell'espressione e a un intento previsto. Selezionare le espressioni, quindi fare clic su Esegui.

- Per escludere la suite di test dall'esecuzione del test, selezionare prima la suite di test, aprire la scheda Generale, quindi disattivare Abilita suite di test.

- Per le competenze multilingue, è inoltre possibile filtrare in base alle opzioni Tag lingua e Lingua prevista (a cui si accede tramite Attributi facoltativi).

- Per creare un'esecuzione di test per una selezione di casi di test all'interno di una suite (o un'esecuzione di test per un subset di tutti i casi di test se si seleziona Tutti), filtrare i casi di test aggiungendo una stringa che corrisponda al testo dell'espressione e a un intento previsto. Selezionare le espressioni, quindi fare clic su Esegui.

- Immettere un nome di esecuzione del test che rifletta l'oggetto del test. Questo passo è facoltativo.

- Fare clic su Avvia

- Fare clic su Risultati del test, quindi selezionare l'esecuzione del test.

Suggerimento

Il completamento delle esecuzioni dei test che contengono un numero elevato di casi di test può richiedere alcuni minuti. Per queste grandi esecuzioni di test, potrebbe essere necessario fare clic periodicamente su Aggiorna fino al completamento del test. Una percentuale sostituisce lo stato In corso per la metrica Precisione e il report Intenti viene visualizzato dopo che tutti i casi di test sono stati valutati.

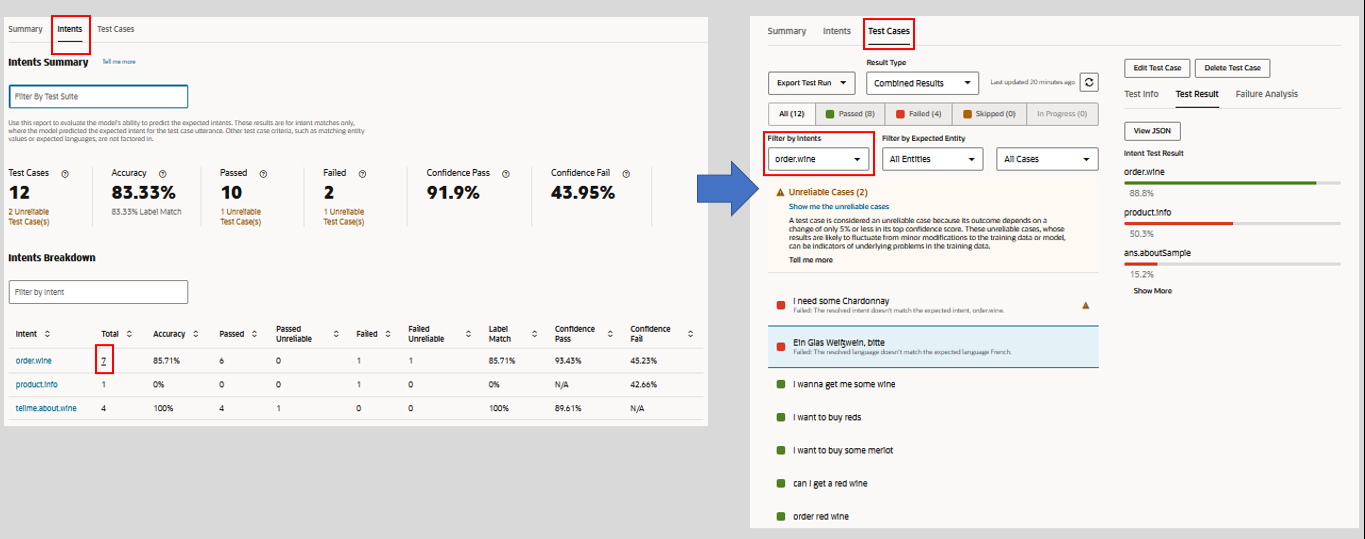

- Rivedere i report di esecuzione test. Ad esempio, rivedere prima le metriche di alto livello per l'esecuzione del test fornite dal report di panoramica. Successivamente, convalidare i risultati dei test rispetto ai casi di test effettivi filtrando il report Casi di test, in cui sono elencati tutti i casi di test inclusi nell'esecuzione del test, per i casi di test passati e non riusciti. È quindi possibile esaminare i singoli risultati del caso di test. È inoltre possibile confrontare il punteggio Precisione nel report Panoramica con il punteggio Precisione nel report Intenti, che misura la capacità del modello di prevedere gli intenti corretti. Per esaminare i casi di test elencati in questo report, aprire il report Casi di test e filtrare in base agli intenti.

Rapporto Sintetico esecuzione test

Il report Riepilogo fornisce una valutazione complessiva della capacità del modello di gestire il tipo di input utente coperto nell'esecuzione del test. Per le suite di test incluse nell'esecuzione del test, viene visualizzato il numero totale di casi di test utilizzati per valutare il modello e, da tale totale, il numero di casi di test (sia affidabili che inaffidabili) non riusciti insieme al numero di casi di test affidabili e inaffidabili passati. L'accuratezza complessiva del modello, ovvero la capacità di prevedere gli intenti previsti al livello di affidabilità o al di sopra del livello di competenza, riconoscere i valori delle entità e risolvere le espressioni nella lingua dello skill, viene misurata in base al tasso di successo dei test di superamento nell'esecuzione del test.

Descrizione dell'immagine test-run-test-results-summary.png

Parametri report sintetico

- Precisione: l'accuratezza del modello in termini di percentuale di successo dei casi di test di superamento (il numero di casi di test di superamento rispetto al numero totale di casi di test inclusi nell'esecuzione del test).

Nota

I casi di test disabilitati non vengono presi in considerazione nel punteggio Accuracy. Nessuno dei test è fallito a causa di errori. Qualsiasi test non riuscito viene invece aggiunto al conteggio degli errori.Un punteggio di precisione basso potrebbe indicare che l'esecuzione del test sta valutando il modello in base a concetti e linguaggio non adeguatamente supportati dai dati di addestramento. Per aumentare il punteggio di precisione, riaddestrare il modello con espressioni che riflettono i casi di test nell'esecuzione del test.

Questa metrica Precisione si applica all'intera esecuzione del test e fornisce un punteggio separato dalla metrica Precisione nel report Intenti. Questa metrica indica la percentuale di casi di test in cui il modello ha superato tutti i criteri del caso di test. Il punteggio Accuracy nel report Intents, invece, non è un test end-to-end. Si tratta della percentuale di casi di test in cui il modello doveva solo prevedere l'intento previsto al livello o al di sopra della soglia di affidabilità dello skill. Non vengono presi in considerazione altri criteri del caso di test (ad esempio il valore di entità o il linguaggio di abilità). Considerati i diversi criteri relativi al significato di un test di superamento per questi due report, i rispettivi punteggi di precisione potrebbero non essere sempre al passo. Il punteggio di accuratezza della corrispondenza dell'intento può essere superiore al punteggio complessivo dell'esecuzione del test quando i dati del test non sono allineati ai dati dell'addestramento. Ridefinire il modello con espressioni che supportano i casi di test gli consentirà di prevedere gli intenti previsti con maggiore sicurezza che, a sua volta, aumenterà il punteggio di precisione per l'esecuzione del test.

Nota

La metrica Precisione non è disponibile fino al completamento dell'esecuzione del test e non è disponibile per le esecuzioni del test completate quando lo skill è stato eseguito in versioni precedenti alla 22.12 della piattaforma Oracle Digital Assistant. - Casi di test: il numero totale di casi di test (sia affidabili che non affidabili) inclusi nell'esecuzione del test. I casi di test saltati sono inclusi in questo conteggio, ma non vengono considerati durante il calcolo della metrica Precisione.

- Superato: il numero di casi di test (sia affidabili che inaffidabili) passati mediante la risoluzione all'intento alla soglia di affidabilità e la corrispondenza dei valori di entità o della lingua selezionati.

- Non riuscito: il numero di casi di test (robot affidabili e inaffidabili) che non sono riusciti a risolvere l'intento previsto alla soglia di affidabilità e non sono riusciti a trovare la corrispondenza tra i valori entità o la lingua selezionata.

Per esaminare i casi di test effettivi alla base delle metriche Passato e Non riuscito in questo report, aprire il report Casi di test, quindi applicare i filtri Passato o Non riuscito.

Descrizione dell'immagine test-runs-intent-report.png

Analisi stratificata suite di test

Nella tabella Analisi stratificata suite di test sono elencate le suite di test incluse nell'esecuzione del test e le relative statistiche individuali. È possibile esaminare i casi di test effettivi appartenenti a una suite di test facendo clic sul collegamento nella colonna Suite di test.

Descrizione della suite di test di illustrazione breakdown.png

Report intenti

Le metriche in questo report tengono traccia delle corrispondenze delle etichette del modello nei casi di test dell'esecuzione del test. Questo è dove il modello prevede correttamente l'intento previsto per l'espressione del caso di test. Nel contesto di questo report, l'accuratezza, il passaggio e l'errore vengono misurati in termini di casi di test in cui il modello ha previsto l'intento previsto corretto al livello o al di sopra della soglia di affidabilità. Non vengono presi in considerazione altri criteri considerati nel report di riepilogo, ad esempio le corrispondenze dei valori entità o la lingua dello skill. Di conseguenza, questo report fornisce una visione diversa dell'accuratezza del modello, che consente di verificare se l'addestramento corrente consente al modello di prevedere in modo coerente gli intenti corretti.

Questo report non è disponibile per le esecuzioni di test completate quando la competenza è stata eseguita su una versione precedente alla 22.12 della piattaforma Oracle Digital Assistant.

Metriche report intenti

- Casi di test: numero di casi di test inclusi in questa esecuzione di test. Questo totale include casi di test affidabili e inaffidabili. I casi di test saltati non sono inclusi in questo conteggio.

Suggerimento

I collegamenti dei casi di test inaffidabili per le metriche Casi di test, Superati e Non riusciti consentono di aprire il report Casi di test filtrato in base a casi di test inaffidabili. Questa navigazione non è disponibile quando si filtra il report in base alla suite di test. - Precisione: l'accuratezza del modello nella corrispondenza dell'intento previsto con o al di sopra della soglia di affidabilità dello skill nei casi di test in questa esecuzione del test. La sottometrica Corrispondenza etichetta rappresenta la percentuale di casi di test nell'esecuzione del test in cui il modello ha previsto correttamente l'intento previsto, indipendentemente dal punteggio di affidabilità. Poiché i fattori di corrispondenza etichetta nei casi di test non riusciti insieme al superamento dei casi di test, il relativo punteggio può essere superiore al punteggio di precisione.

È possibile confrontare questa metrica Precisione con la metrica Precisione del report Riepilogo. Quando il punteggio Accuratezza nel report Riepilogo è basso, è possibile utilizzare questo report per scoprire rapidamente se le carenze del modello possono essere attribuite alla sua incapacità di prevedere l'intento previsto. Quando il punteggio di precisione in questo report è alto, tuttavia, è possibile escludere la corrispondenza delle etichette come radice del problema e, invece di dover rivedere pesantemente i dati di addestramento per aumentare il punteggio di precisione dell'esecuzione del test, è possibile concentrarsi invece aggiungendo espressioni che riflettono i concetti e il linguaggio nelle espressioni del caso di test.

- Superato: numero di casi di test (affidabili e inaffidabili) in cui il modello ha previsto l'intento previsto alla soglia di affidabilità dello skill.

- Non riuscito: il numero di casi di test (affidabili e inaffidabili) in cui il modello ha previsto l'intento previsto al di sotto della soglia di affidabilità dello skill.

- Confidence Pass: media dei punteggi di affidabilità per tutti i casi di test passati in questa esecuzione del test.

- Errore di affidabilità: media dei punteggi di affidabilità per tutti i casi di test non riusciti in questa esecuzione del test.

Quando si filtra il report Intenti in base alla suite di test, l'accesso al report dei casi di test dai collegamenti dei casi di test inaffidabili nelle caselle Casi di test, Passato e Non riuscito non è disponibile. Questi collegamenti diventano nuovamente attivi quando si rimuovono tutte le voci dal campo Filtra per suite di test.

Filtra per suite di test

Il report regola le metriche per ogni suite di test aggiunta (o successivamente rimossa). Consente di tabulare i risultati della corrispondenza degli intenti in termini di numero di casi di test abilitati che appartengono alla suite di test selezionata.

Non è possibile filtrare in base alle suite di test eseguite su una piattaforma prima della versione 23.06. Per includere queste suite di test, è necessario eseguirle di nuovo dopo l'aggiornamento alle versioni 23.06 o successive.

Il filtro per suite di test disabilita la navigazione al report dei casi di test dai collegamenti dei casi di test inaffidabili nelle caselle Casi di test, Passato e Non riuscito. Vengono disabilitati anche i collegamenti nella colonna Totale dell'analisi stratificata intenti. Tutti questi collegamenti diventano nuovamente attivi dopo aver rimosso tutte le voci dal campo Filtra per suite di test.

Analisi stratificata intenti

Il campo Filtra per intento modifica la vista della tabella Analisi stratificata intenti, ma non modifica le metriche complessive del report. Queste metriche riflettono le voci (o la mancanza di voci) nel campo Filtra per suite di test.

- Intento: nome dell'intento previsto.

- Totale: il numero di casi di test, rappresentati come collegamento, per l'intento previsto. È possibile passare al report Casi di test facendo clic su questo collegamento.

Nota

Non è possibile passare al report Casi di test dopo aver applicato un filtro della suite di test a questo report. Questo collegamento diventa nuovamente attivo quando si rimuovono tutte le voci dal campo Filtra per suite di test. - Precisione: la percentuale di casi di test che hanno restituito corrispondenze di etichette per l'intento previsto al o al di sopra della soglia di affidabilità dello skill.

- Superato: numero di casi di test (inclusi casi di test inaffidabili) in cui il modello prevedeva l'intento previsto al livello o al di sopra della soglia di affidabilità dello skill.

- Superato - Non affidabile: il numero di casi di test in cui il modello prevedeva l'intento previsto al 5% o meno sopra la soglia di affidabilità dello skill.

- Non riuscito: il numero di casi di test nell'esecuzione del test non riusciti perché il modello prevedeva l'intento previsto al di sotto della soglia di affidabilità dello skill.

- Non riuscito - Non affidabile: il numero di casi di test non riusciti perché la fiducia del modello nel prevedere l'intento previsto è scesa del 5% al di sotto della soglia di affidabilità dello skill. Questi casi di test possono essere considerati

- Corrispondenza etichette: numero di casi di test in cui il modello ha previsto correttamente l'intento previsto, indipendentemente dal livello di attendibilità. Poiché si tratta di fattori nei casi di test non riusciti, i punteggi di corrispondenza etichetta e precisione potrebbero non essere sempre al passo l'uno con l'altro. Ad esempio, quattro casi di test di superamento su cinque hanno restituito un punteggio di precisione dell'80% per l'intento. Tuttavia, se il modello prevedeva correttamente l'intento per un caso di test non riuscito, Label Match supererebbe l'accuratezza del 20%.

- Confidence Pass: media dei punteggi di affidabilità per tutti i casi di test che hanno soddisfatto l'intento previsto.

- Errore di attendibilità: media dei punteggi di attendibilità per tutti i casi di test che non corrispondono all'intento previsto.

Suggerimento

Per esaminare i casi di test effettivi, aprire il report Casi di test e il filtro in base all'intento.

Report casi di test

- È possibile filtrare i risultati facendo clic su Tutto, Passato (verde) o Non riuscito (rosso). I casi di test conteggiati come ignorati includono sia i casi di test disabilitati che i casi di test in cui l'intento previsto è stato disabilitato.

È possibile filtrare i risultati in base a casi di test non affidabili facendo clic su Mostra casi non affidabili nel messaggio di avvertenza oppure selezionando il filtro Solo casi non affidabili. - Se necessario, filtrare i risultati per un intento o un'entità specifica o per casi di test affidabili o inaffidabili.

- Per i casi di test non affidabili e non riusciti, fare clic su Visualizza informazioni simili (situato nella pagina Informazioni sul test) per scoprire se l'espressione del caso di test ha qualsiasi somiglianza con le espressioni nel set di formazione.

- Controllare i seguenti risultati:

- Informazioni test: presenta la panoramica del caso di test, inclusi la soglia di affidabilità target, l'intento previsto e i valori di entità corrispondenti.

- Risultato test: la classificazione dell'intento in base al livello di attendibilità. Se presente, il report identifica anche le entità contenute nell'espressione in base al nome e al valore dell'entità. È inoltre possibile visualizzare l'oggetto JSON contenente i risultati completi.

- Analisi errori: spiega perché il caso di test non è riuscito. Ad esempio, l'intento effettivo non è l'intento previsto, il valore dell'entità con etichetta nel caso di test non corrisponde all'entità risolta o la lingua prevista non è uguale alla lingua rilevata.

Casi di test inaffidabili

Alcuni casi di test non possono fornire risultati coerenti perché si risolvono entro il 5% o meno della soglia di affidabilità. Questo margine stretto rende questi casi di prova inaffidabili. Quando la soglia di affidabilità dello skill è impostata su 0,7, ad esempio, un caso di test che supera il 74% potrebbe non riuscire dopo aver apportato solo modifiche di lieve entità ai dati di addestramento o perché lo skill è stato aggiornato a una nuova versione del modello. La fragilità di questi casi di test può indicare che le espressioni che rappresentano nei dati di addestramento possono essere troppo poche e che potrebbe essere necessario bilanciare i dati di addestramento dell'intento con espressioni simili.

- Eseguire la suite di test. Fare quindi clic su Risultati del test e selezionare l'esecuzione del test. I casi di test inaffidabili vengono ordinati all'inizio dei risultati dell'esecuzione del test e contrassegnati con avvertenze

.

. - Per isolare i casi di test inaffidabili:

- Fare clic su Mostra casi inaffidabili nel messaggio.

- Selezionare Solo casi non affidabili dal menu Filtra per casi.

- Fare clic su Mostra casi inaffidabili nel messaggio.

- Per trovare la prossimità dell'intento di primo livello del caso di test alla soglia di affidabilità, aprire la finestra Risultato del test. Per un confronto tra il punteggio di affidabilità di primo livello e la soglia di affidabilità, fare clic su

.

. - Se è necessario integrare i dati di formazione per l'intento di primo livello, fare clic su Vai all'intento principale nel messaggio di avvertenza.

- Se si desidera determinare la quantità di espressioni rappresentate dal caso di test nei dati di addestramento, fare clic su Visualizza informazioni simili.

È inoltre possibile verificare se una delle espressioni più simili all'espressione del caso di test sono anomalie nel set di formazione eseguendo il report sulle anomalie.

Esecuzioni del test esportate

Le esecuzioni dei test non vengono rese persistenti con la competenza, ma è possibile scaricarle nel sistema per l'analisi facendo clic su Esporta esecuzione test. Se gli intenti non risolvono più l'input dell'utente come previsto o se le modifiche alla piattaforma hanno avuto un impatto negativo sulla risoluzione dell'intento, è possibile raccogliere i dettagli di una richiesta di servizio utilizzando i log delle esecuzioni di test esportate.

Test errore

I test di errore (o negativi) consentono di eseguire test in blocco delle espressioni che non devono mai essere risolte, sia perché generano unresolvedIntent, sia perché risolvono solo altri intenti al di sotto della soglia di affidabilità per tutti gli intenti.

- Specificare unresolvedIntent come intento previsto per tutti i casi di test che si prevede di non risolvere. Idealmente, queste frasi "false" rimarranno irrisolte.

- Se necessario, modificare la soglia di affidabilità durante la creazione di un'esecuzione del test per confermare che le frasi false (quelle con l'intento previsto

unresolvedIntent) possono essere risolte solo al di sotto del valore impostato qui. Ad esempio, l'aumento della soglia potrebbe comportare la mancata risoluzione delle frasi false a livello di attendibilità a qualsiasi intento (incluso unresolvedIntent), il che significa che passano perché sono considerate irrisolte. - Esaminare i risultati del test, verificando che i casi di test superati corrispondano a unresolvedIntent alla soglia o non corrispondano a nessun intento (unresolvedIntent o altro) alla soglia.

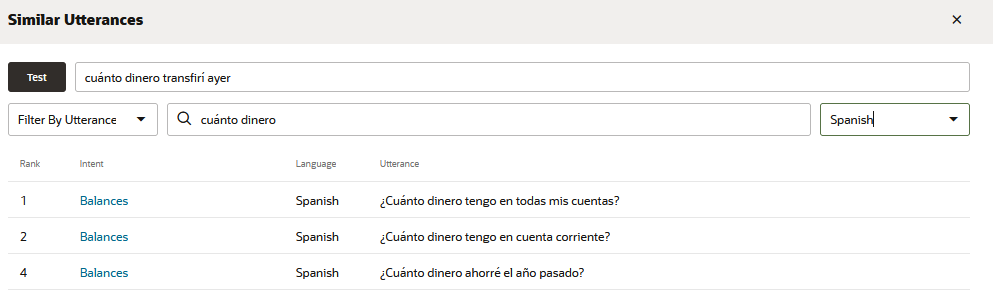

Discorsi simili

È possibile scoprire quanto sia simile la frase di test alle espressioni nel corpus di formazione facendo clic su Visualizza dichiarazioni simili. Questo strumento ti offre una prospettiva aggiuntiva sui dati di allenamento dell'abilità mostrandoti quanto siano simili le sue espressioni alla frase di prova e, per estensione, quanto siano simili le espressioni tra loro attraverso gli intenti. Utilizzando questo strumento, è possibile scoprire se la somiglianza della frase di prova alle espressioni appartenenti ad altri intenti è la ragione per cui la frase di prova non si risolve come previsto. Potrebbe anche indicare dove i dati dell'addestramento appartengono all'intento errato perché se sono simili alla frase di test.

Descrizione dell'immagine similar-utterance-report-all-intents.png

L'elenco generato da questo strumento classifica 20 espressioni (insieme ai loro intenti associati) più vicine alla frase di prova. Idealmente, l'espressione di primo livello in questa lista - quella più simile alla frase di test - appartiene all'intento che è mirato per la frase di test. Se l'espressione più vicina che appartiene all'intento previsto è più in basso, una revisione dell'elenco potrebbe fornire alcuni suggerimenti sul perché. Ad esempio, se si sta testando un'espressione dell'intento Transazioni, quanto denaro ho trasferito ieri?, ci si aspetterebbe che anche l'espressione di primo livello appartenga a un intento Transazioni. Tuttavia, se questa espressione di prova si risolve con l'intento sbagliato o si risolve al di sotto del livello di fiducia, l'elenco potrebbe rivelare che ha più in comune con espressioni altamente classificate con una formulazione simile che appartengono ad altri intenti. L'intento Saldi Quanto denaro ho in tutti i miei conti?, ad esempio, potrebbe essere più vicino all'espressione del test rispetto all'espressione Quanto ho depositato ad aprile? di livello inferiore dell'intento Transazioni.

Questo strumento può essere utilizzato solo per le competenze acquisite su Trainer Tm (non è disponibile per le competenze acquisite con Ht).

- Filtra per intento: restituisce 20 espressioni più vicine all'espressione di test che appartengono all'intento o agli intenti selezionati.

- Filtro per parola: restituisce 20 delle espressioni più vicine all'espressione di test che contengono una parola o una frase.

- Lingua: per le competenze multilingue, è possibile eseguire query e filtrare il report selezionando una lingua.

L'applicazione di questi filtri non modifica le classificazioni, ma solo la vista. Un enunciato classificato terzo, per esempio, sarà notato come tale indipendentemente dal filtro. Le classifiche e i contenuti del report cambiano solo dopo aver aggiornato il corpus e riqualificato l'abilità con Trainer Tm.