Andere Möglichkeiten zum Ausführen von Jobs

Sie können Jobs auf vielfältige Weise verwenden, wie z.B. mit Conda-Umgebungen und ZIP-Dateien.

ZIP- oder komprimierte TAR-Dateien verwenden

Sie können über Jobs ein ganzes Python-Projekt ausführen, das Sie in einer einzelnen Datei archivieren.

ZIP- oder komprimierte TAR-Dateien, die als Job ausgeführt werden, können die Data Science-Service-Conda-Umgebungen und die benutzerdefinierten Conda-Umgebungen nutzen.

Beim Joblauf verweisen Sie mit der Umgebungsvariable JOB_RUN_ENTRYPOINT auf die Haupteintragsdatei. Diese Variable wird nur mit Jobs verwendet, die ZIP- oder komprimierte TAR-Jobartefakte verwenden.

Data Science-Conda-Umgebungen verwenden

Sie können eine der Conda-Umgebungen von Data Science verwenden, die im Service enthalten sind.

Eine Conda-Umgebung kapselt alle Drittanbieter-Python-Abhängigkeiten (wie Numpy, Dask oder XGBoost), die für den Joblauf erforderlich sind. Data Science-Conda-Umgebungen sind im Service enthalten und werden dort verwaltet. Wenn Sie im Rahmen von Job- und Joblaufkonfigurationen keine Conda-Umgebung angeben, wird keine Conda-Umgebung verwendet, weil kein Standardwert vorhanden ist.

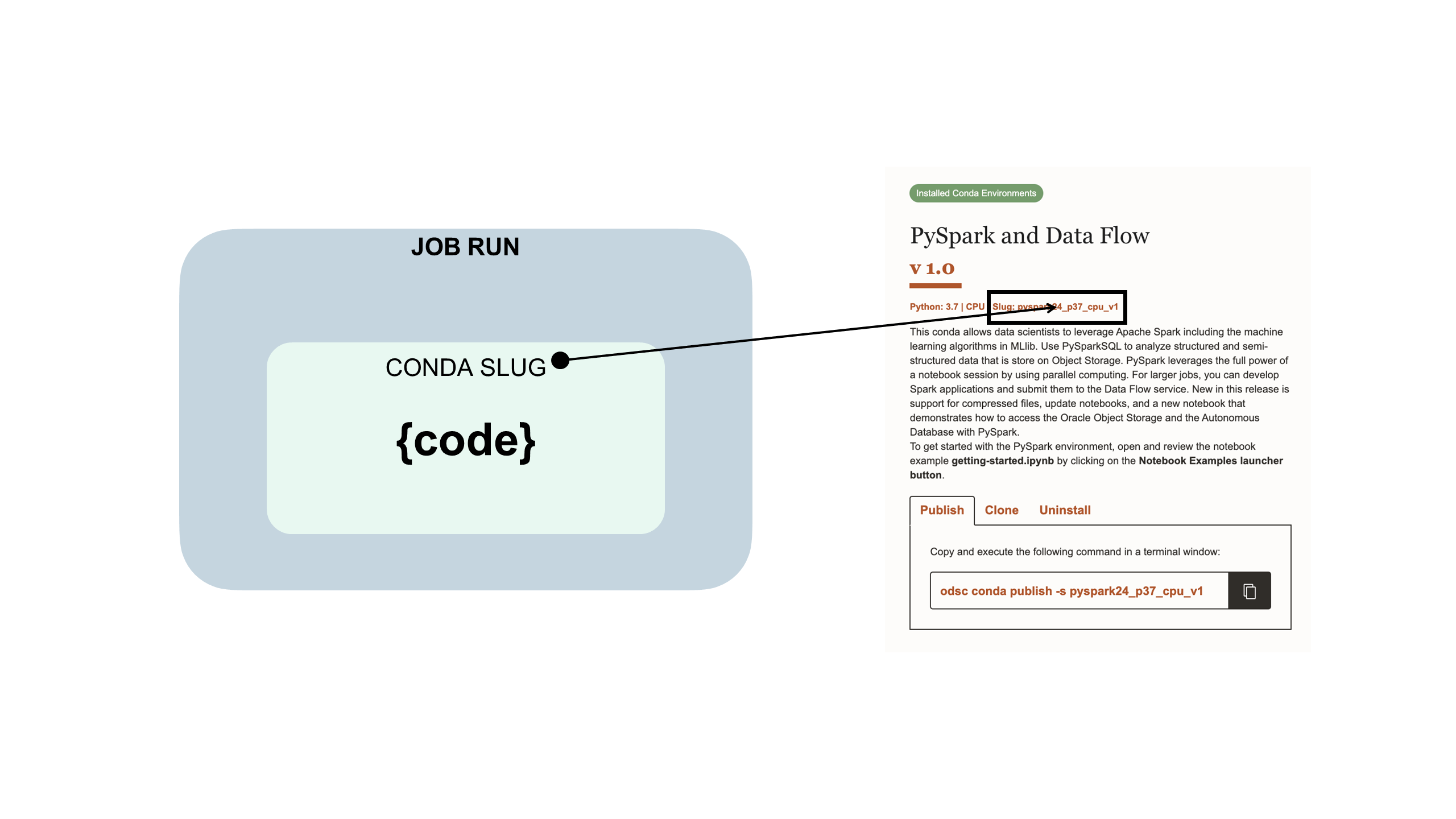

Der Jobcode ist in eine Data Science-Conda-Umgebung integriert:

Benutzerdefinierte Conda-Umgebungen verwenden

Sie können Jobs mit ZIP- und komprimierten Tar-Dateien mit benutzerdefinierten Conda-Umgebungen oder Data Science-Conda-Umgebungen verwenden.

Eine Conda-Umgebung kapselt alle für Ihren Joblauf erforderlichen Drittanbieter-Python-Abhängigkeiten (wie Numpy, Dask oder XGBoost). Sie erstellen, veröffentlichen und verwalten benutzerdefinierte Conda-Umgebungen. Wenn Sie im Rahmen von Job- und Joblaufkonfigurationen keine Conda-Umgebung angeben, wird keine Conda-Umgebung verwendet, weil kein Standardwert vorhanden ist.

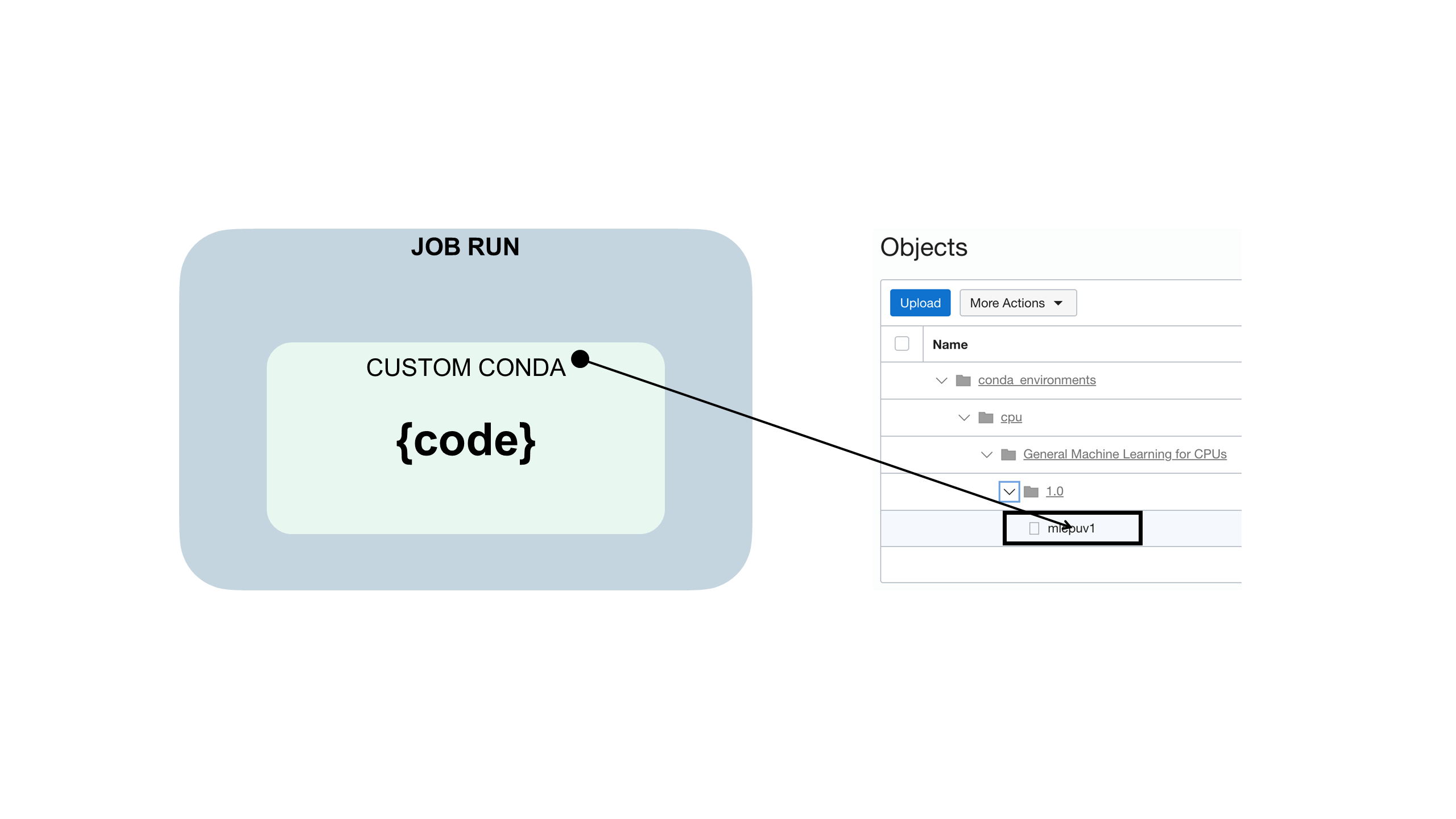

Der Jobcode ist wie folgt in eine benutzerdefinierte Conda-Umgebung eingebettet:

YAML-Laufzeitdatei verwenden

Sie können eine YAML-Laufzeitdatei anstelle der Konsole oder des SDK verwenden, um Jobumgebungsvariablen zu konfigurieren.

Bevor Sie beginnen:

Laden Sie die Beispieldateien jobruntime.yaml und conda_pack_test.py herunter, dekomprimieren Sie sie, und prüfen Sie sie, um Ihr Jobprojekt zu erstellen und zu testen.

Die Verwendung einer jobruntime.yaml-Datei erleichtert das Festlegen benutzerdefinierter Umgebungsvariablen in Ihrem Projekt.

Vault verwenden

Sie können den OCI-Vault-Service mit Resource Principals in Data Science-Jobs integrieren.

Bevor Sie beginnen:

-

Damit der Resource Principal im Job auf einen Vault zugreifen kann, richten Sie eine dynamische Gruppe in Ihrem Compartment ein, die entweder die Instanz oder den Resource Principal angibt. Beispiel: Sie können den Resource Principal und eine dynamische Gruppe mit dieser Regel verwenden:

all {resource.type='datasciencejobrun',resource.compartment.id='<compartment_ocid>'} -

Damit der Job ausgeführt werden kann, müssen Sie sicherstellen, dass Sie die Secret-Familie mindestens für die dynamische Gruppe verwalten können. Beispiel:

Allow dynamic-group <dynamic_group_name> to manage secret-family in compartment <compartment_name>Der Blogpost OCI-Instanz-Principals und Vault mit Python zum Abrufen eines Secrets verwenden enthält nützliche Details.

-

Laden Sie die Beispieldatei

zipped_python_job.zipherunter, dekomprimieren Sie sie, und prüfen Sie sie. Sie enthält Folgendes:- Sie initialisiert einen Vault-Client im Job mit dem Python-SDK.

- Sie liest ein Secret mit der Secret-OCID.

- Sie decodiert das Secret Bundle und zeigt den tatsächlichen Secret-Inhalt an.

Da Jobs Zugriff auf den Resource Principal haben, können Sie alle Vault-Clients initialisieren, die im Python-SDK verfügbar sind.

-

Erstellen Sie einen Vault mit einem Masterschlüssel, erstellen Sie ein Secret, und fügen Sie eine Policy-Anweisung mit

manage secret-familyzu allen Job-Resource-Principals hinzu.

- Erstellen Sie in der Konsole einen neuen Job.

- Führen Sie den Job aus, um zu testen, ob er funktioniert.

- Überwachen Sie den Joblauf, um zu prüfen, ob er erfolgreich abgeschlossen wird.

- (Optional) Wenn Sie Logging verwendet haben, können Sie die Werte des Joblaufs in den Logs prüfen.