Bidirektionale Replikationen konfigurieren

Nachdem Sie eine unidirektionale Replikation eingerichtet haben, können Sie mit nur wenigen zusätzlichen Schritten die Daten in die entgegengesetzte Richtung replizieren. In diesem Schnellstartbeispiel werden Autonomous AI Transaction Processing und Autonomous AI Lakehouse als zwei Cloud-Datenbanken verwendet.

Verwandte Themen

Bevor Sie beginnen

Sie benötigen zwei Datenbanken im gleichen Mandanten und in der gleichen Region, um mit diesem Schnellstart fortzufahren. Wenn Sie Beispieldaten benötigen, laden Sie Archive.zip herunter, und befolgen Sie die Anweisungen unter Übung 1, Aufgabe 3: ATP-Schema laden.

Überblick

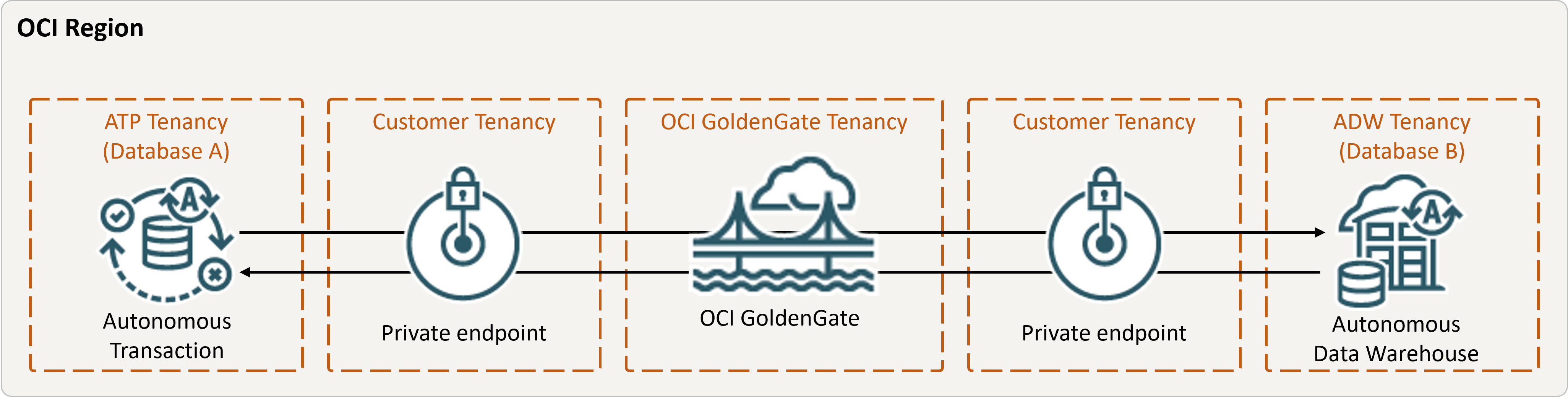

In den folgenden Schritten wird beschrieben, wie Sie eine Zieldatenbank mit Oracle Data Pump instanziieren und die bidirektionale (wechselseitige) Replikation zwischen zwei Datenbanken in der gleichen Region einrichten.

Beschreibung der Abbildung bidirectional.png

Aufgabe 2: Transaktionsinformationen und eine Checkpoint-Tabelle für beide Datenbanken hinzufügen

Gehen Sie in der OCI GoldenGate-Deployment-Konsole zu der Seite "Konfiguration" für den Administrationsservice, und führen Sie dann die folgenden Schritte aus:

Aufgabe 3: Integrierten Extract erstellen

Ein integrierter Extract erfasst fortlaufende Änderungen an der Quelldatenbank.

Aufgabe 4: Daten mit Oracle Data Pump (ExpDP) exportieren

Mit Oracle Data Pump (ExpDP) können Sie Daten aus der Quelldatenbank in Oracle Object Storage exportieren.

Aufgabe 5: Zieldatenbank mit Oracle Data Pump (ImpDP) instanziieren

Mit Oracle Data Pump (ImpDP) können Sie Daten aus der Datei SRC_OCIGGLL.dmp, die aus der Quelldatenbank exportiert wurde, in die Zieldatenbank importieren.

Aufgabe 6: Nicht integriertes Replicat hinzufügen und ausführen

- Fügen Sie ein Replicat hinzu, und führen Sie es aus.

- Nehmen Sie einige Änderungen an Datenbank A vor, um zu prüfen, ob sie in Datenbank B repliziert werden.

Aufgabe 7: Replikation von Datenbank B in Datenbank A konfigurieren

In den Aufgaben 1 bis 6 haben Sie die Replikation von Datenbank A in Datenbank B eingerichtet. Mit den folgenden Schritten richten Sie die Replikation von Datenbank B in Datenbank A ein.