Entrenamiento y prueba de las intenciones

Al entrenar un modelo utilizando su corpus de entrenamiento, el bot puede entender qué dicen los usuarios (o, en ocasiones, qué intentan decir).

Puede mejorar la agudeza del conocimiento realizando rondas de pruebas de intenciones y entrenamientos de intenciones. El entrenamiento se controla únicamente a través de las definiciones de intenciones; la aptitud no puede aprender por sí misma a partir del chat con el usuario.

Prueba de expresiones

Se recomienda reservar el 20% del corpus para las pruebas de intenciones y utilizar el 80% restante para entrenar las intenciones. Mantenga estos dos juegos separados para que las expresiones de prueba, que se incorporan en los casos de prueba, sigan siendo "desconocidas" para su aptitud.

Aplique la división 80/20 al conjunto de datos de cada una de las intenciones. Aleatorice las expresiones antes de aplicar esta división. Así, los modelos de entrenamiento podrán examinar los términos y los patrones de las expresiones por igual.

Probador de expresiones

El probador de expresiones es la ventana a la cognición de la aptitud. Si introduce frases que no formen parte del corpus de entrenamiento, puede averiguar si ha diseñado correctamente las intenciones revisando la clasificación de confianza de la intención y el JSON devuelto. Esta clasificación, que es la estimación que hace la aptitud del mejor candidato para resolver la entrada de usuario, demuestra su agudeza actual.

Descripción de la ilustración dot-tester-quick-test.png

Con el probador de Expresiones, puede realizar pruebas rápidas para pruebas puntuales y sobre la mar, o puede incorporar una expresión como caso de prueba que calcule las resoluciones de intenciones en diferentes versiones de modelos de entrenamiento.

Casos de prueba

Cada prueba tiene una expresión y la intención a la que se espera que se resuelva, lo que se conoce como coincidencia de etiqueta. Un caso de prueba también puede incluir valores de entidad coincidentes y el idioma esperado para la expresión. Puede ejecutar casos de prueba cuando esté desarrollando una aptitud y, más adelante, cuando la aptitud esté en producción, puede utilizar los casos de prueba para pruebas de regresión. En este último caso, puede ejecutar casos de prueba para averiguar si una nueva versión del modelo de entrenamiento ha afectado negativamente a la resolución de la intención.

Al igual que los casos de prueba que crea con el probador de conversaciones, los casos de prueba de expresiones forman parte de la aptitud y se trasladan con cada versión. Si amplía una aptitud, la extensión hereda los casos de prueba. Mientras que los casos de prueba de conversación están pensados para probar un escenario, los casos de prueba de expresión están pensados para probar los fragmentos de una conversación de forma independiente, garantizando que cada expresión se resuelva con la intención correcta.

Gestión de casos de prueba

nluTestSuites que aloja los conjuntos de pruebas de la aptitud cuando se exporta la aptitud.Crear conjuntos de pruebas

- Haga clic en + Conjunto de pruebas.

- En el separador General, sustituya el nombre del marcador de posición (TestSuite0001, por ejemplo) por otro más significativo agregando un valor en el campo Nombre mostrado.

- Opcionalmente, agregue una descripción que explique la funcionalidad que cubre el conjunto de pruebas.

- Rellene el conjunto de pruebas con casos de prueba utilizando cualquiera (o una combinación de) los siguientes métodos:

- Agregación manual de casos de prueba (ya sea mediante la creación de un caso de prueba o guardado de una expresión como caso de prueba desde el comprobador de expresiones).

- Importación de casos de prueba

Nota

Para asignar un caso de prueba a un conjunto de pruebas mediante la importación, el campotestSuitedel CSV puede estar vacío o debe contener un nombre que coincida con el conjunto de pruebas seleccionado en el cuadro de diálogo de importación. - Edición de un caso de prueba para reasignar su conjunto de pruebas.

- Si desea excluir el conjunto de pruebas de las ejecuciones de prueba iniciadas mediante las opciones Todo y Ejecutar todo, desactive Activar conjunto de pruebas.

- Si no desea que el conjunto de pruebas se incluya con la exportación de aptitudes, desactive Incluir en exportación de aptitudes. Cuando desactiva esta opción para un conjunto de pruebas, no se incluirá en la carpeta

nluTestSuitesque aloja los conjuntos de pruebas de la aptitud en el archivo ZIP exportado.

Creación de casos de prueba de expresiones

Puede agregar casos de prueba uno a uno mediante el probador de expresiones o el cuadro de diálogo Nuevo caso de prueba (al que se accede haciendo clic en + Caso de prueba), o bien puede agregarlos en bloque mediante la carga de un CSV.

Todos los casos de prueba deben pertenecer a un conjunto de prueba, por lo tanto, es posible que desee crear primero un conjunto de prueba que refleje algún aspecto de las pruebas de intención, como pruebas de fallos, pruebas en dominios o pruebas fuera de dominio.

Consejo:

Para proporcionar una cobertura adecuada en las pruebas, cree expresiones del conjunto de pruebas que no solo sean variadas conceptualmente, sino también gramaticalmente, ya que los usuarios no realizarán solicitudes de manera uniforme. Puede agregar estas dimensiones mediante la creación de conjuntos de pruebas a partir de mensajes de usuario reales que se hayan consultado en Insights Retrainer y también a partir de entradas de origen colaborativo recopiladas de Data Manufacturing.Adición de casos de prueba desde el probador de expresiones

- Haga clic en Probar expresiones.

- Si la aptitud es multilingüe, seleccione el idioma nativo.

- Introduzca la expresión y, a continuación, haga clic en Probar.

- Haga clic en Guardar como caso de prueba y, a continuación, seleccione un conjunto de pruebas.

Creación de un caso de prueba

- Haga clic en Ir a casos de prueba en el probador de expresiones.

- Haga clic en + Caso de prueba.

- Complete el cuadro de diálogo Nuevo caso de prueba:

- Si es necesario, desactive el caso de prueba.

- Introduzca la expresión de prueba.

- Seleccione el conjunto de pruebas.

- Seleccione la intención esperada. Si está creando un caso de prueba para pruebas de fallos, seleccione unresolvedIntent.

- Para las aptitudes multilingües, seleccione la etiqueta de idioma y el idioma esperado.

- Haga clic en Agregar a conjunto. En la página Casos de Prueba, puede suprimir un caso de prueba o editar un caso de prueba, lo que incluye reasignar el caso de prueba a un conjunto de pruebas diferente.

- Para probar valores de entidad:

- Active Probar entidades. A continuación, haga clic en Continuar.

- Resalte la palabra (o palabras) y, a continuación, aplique una etiqueta de entidad seleccionando una entidad de la lista. Cuando haya terminado, haga clic en Agregar a conjunto.

Nota

Seleccione siempre palabras o frases de la expresión del caso de prueba después de activar Entidades de prueba. El caso de prueba fallará si ha activado Entidades de prueba, pero no ha resaltado ninguna palabra.

Importación de casos de prueba para conjuntos de pruebas de nivel de aptitud

testSuite: nombre del conjunto de pruebas al que pertenece el caso de prueba. El campotestSuitede cada fila del CSV puede tener un nombre de conjunto de pruebas diferente o puede estar vacío.- Los casos de prueba con campos

testSuitevacíos se agregan a un conjunto de pruebas que seleccione al importar el CSV. Si no selecciona un conjunto de pruebas, se asignarán al conjunto de pruebas predeterminado. - Los casos de prueba con campos

testSuiterellenados se asignan al conjunto de pruebas que seleccione al importar el CSV solo cuando el nombre del conjunto de pruebas seleccionado coincida con el nombre del campotestSuite. - Si aún no existe un conjunto de pruebas con el nombre del especificado en el campo

testSuite, se creará después de importar el CSV.

- Los casos de prueba con campos

utterance: ejemplo de expresión (obligatorio). Se asigna aqueryen versiones anteriores a la 21.04 de Oracle Digital Assistant.expectedIntent: intención coincidente (obligatoria). Este campo se asigna aTopIntenten versiones anteriores a la versión 21.04 de Oracle Digital Assistant.Consejo:

Importar versiones anteriores a la versión 21.04 del CSV le indica cómo cambiar el formato de los CSV anteriores a la versión 21.04 para que pueda usarlos para pruebas masivas.enabled:TRUEincluye el caso de prueba en la ejecución de la prueba.FALSElo excluye.languageTag: etiqueta de idioma (en, por ejemplo). Cuando no hay ningún valor, el idioma detectado en la configuración de idioma de la aptitud se utiliza por defecto.expectedLanguageTag(opcional): para aptitudes multilingües, esta es la etiqueta de idioma para el idioma que desea que utilice el modelo al resolver la expresión de prueba en una intención. Para que el caso de prueba pase, esta etiqueta debe coincidir con el idioma detectado.expectedEntities: entidades coincidentes en la expresión de caso de prueba, representadas como una matriz de objetosentityName. CadaentityNameidentifica la posición del valor de entidad en la expresión mediante las propiedadesbeginOffsetyendOffset. Este desplazamiento se determina por carácter, no por palabra, y se calcula a partir del primer carácter de la expresión (0-1). Por ejemplo, el objetoentityNamepara el valor de entidad PizzaSize de pequeño en Quiero pedir una pizza pequeña es:[{"entityName":"PizzaSize","beginOffset":18,"endOffset":23,"originalString":"small"}, …]

- Haga clic en Más y, a continuación, seleccione Importar.

- Busque el fichero CSV y, a continuación, seleccione el

- Seleccione el conjunto de pruebas. El caso de prueba solo se puede asignar al conjunto de pruebas seleccionado si el campo

testSuiteestá vacío o coincide con el nombre del conjunto de pruebas seleccionado. - Haga clic en Cargar.

Importación de versiones anteriores a la versión 21.04 del CSV

query y TopIntent, se agregan solo al conjunto de pruebas predeterminado. Puede reasignar estos casos de prueba a otros conjuntos de pruebas individualmente editándolos después de importar el CSV, o bien puede actualizar el CSV al formato actual y, a continuación, editarlo antes de importarlo de la siguiente manera:

- Haga clic en Más > Importar.

- Una vez finalizada la importación, seleccione Conjunto de pruebas por defecto y, a continuación, haga clic en Más > Exportar conjunto seleccionado. El archivo exportado se convertirá al formato actual.

- Extraiga el archivo ZIP y edite el CSV. Cuando haya terminado, vuelva a importar el CSV ( Más > Importar). Puede que necesite suprimir casos de prueba duplicados de Conjunto de pruebas por defecto.

Nota

Si carga el mismo CSV varias veces con cambios menores, los datos nuevos o actualizados se fusionarán con los antiguos: se aplican nuevas actualizaciones y se insertan nuevas filas. Sin embargo, no puede suprimir ninguna expresión cargando un nuevo CSV. Si necesita suprimir expresiones, debe suprimirlas manualmente desde la interfaz de usuario.

Creación de ejecuciones de prueba

Las pruebas son una compilación de casos de prueba o conjuntos de pruebas destinados a evaluar algún aspecto de la cognición de la habilidad. El contenido (y el volumen) de una ejecución de prueba depende de la capacidad que desee probar, por lo que una ejecución de prueba puede incluir un subconjunto de casos de prueba de un conjunto de pruebas, un conjunto de pruebas completo o varios conjuntos de pruebas.

Los casos de prueba incluidos en una ejecución de prueba se evalúan con respecto al umbral de confianza definido para la aptitud. Para que un caso de prueba pase en la ejecución de prueba general, se debe resolver en la intención esperada en el umbral de confianza o por encima de él. Si se especifica, el caso de prueba también debe cumplir el valor de entidad y los criterios de coincidencia de idioma. Al revisar los resultados de las ejecuciones de prueba, puede averiguar si las modificaciones realizadas en la plataforma, o en la propia aptitud, han comprometido la precisión de la resolución de la intención.

Además de probar el modelo, también puede utilizar los resultados de la ejecución de prueba para evaluar la fiabilidad de las pruebas. Por ejemplo, los resultados que muestran que casi todos los casos de prueba han pasado podrían, en la superficie, indicar un funcionamiento óptimo del modelo. Sin embargo, una revisión de los casos de prueba aprobados puede revelar que los casos de prueba no reflejan el entrenamiento actual porque sus expresiones son demasiado simples o tienen una superposición significativa en términos de conceptos y lenguaje para los que están probando. Por otro lado, un gran número de pruebas fallidas puede indicar deficiencias en los datos de entrenamiento, pero una revisión de estos casos de prueba puede revelar que sus expresiones están emparejadas con las intenciones esperadas incorrectas.

- Haga clic en Ejecutar todo para crear una ejecución de prueba para todos los casos de prueba de un conjunto de pruebas seleccionado. (O si desea ejecutar todos los conjuntos de pruebas, seleccione Todos y, a continuación, haga clic en Ejecutar todo).

- Para crear una ejecución de prueba para una selección de casos de prueba dentro de un conjunto (o una ejecución de prueba para un subjuego de todos los casos de prueba si ha seleccionado Todos), filtre los casos de prueba agregando una cadena que coincida con el texto de expresión y una intención esperada. Seleccione las expresiones y, a continuación, haga clic en Ejecutar.

- Para excluir el conjunto de pruebas de la ejecución de prueba, seleccione primero el conjunto de pruebas, abra el separador General y, a continuación, desactive Activar conjunto de pruebas.

- Para aptitudes multilingües, también puede filtrar por la opción Etiqueta de idioma e Idioma previsto (al que se acceder mediante Atributos opcional).

- Para crear una ejecución de prueba para una selección de casos de prueba dentro de un conjunto (o una ejecución de prueba para un subjuego de todos los casos de prueba si ha seleccionado Todos), filtre los casos de prueba agregando una cadena que coincida con el texto de expresión y una intención esperada. Seleccione las expresiones y, a continuación, haga clic en Ejecutar.

- Introduzca un nombre de ejecución de prueba que refleje el asunto del examen. Éste es un paso opcional.

- Haga clic en Iniciar

- Haga clic en Resultados de prueba y, a continuación, seleccione la ejecución de prueba.

Consejo:

Las ejecuciones de pruebas que contienen un gran número de casos de prueba pueden tardar varios minutos en completarse. Para estas ejecuciones de prueba grandes, puede que tenga que hacer clic en Refrescar periódicamente hasta que finalice la prueba. Un porcentaje sustituye el estado En curso de la métrica Precisión y el informe Intenciones se presenta después de que se hayan evaluado todos los casos de prueba.

- Revise los informes de ejecución de prueba. Por ejemplo, primero revise las métricas de alto nivel para la ejecución de prueba proporcionada por el informe de visión general. A continuación, valide los resultados de la prueba con respecto a los casos de prueba reales filtrando el informe Casos de prueba, que enumera todos los casos de prueba incluidos en la ejecución de prueba, para los casos de prueba aprobados y fallidos. A continuación, puede examinar los resultados de casos de prueba individuales. También puede comparar la puntuación de precisión del informe Visión general con la puntuación de precisión del informe Intenciones, que mide la capacidad del modelo para predecir las intenciones correctas. Para revisar los casos de prueba que se muestran en este informe, abra el informe Casos de prueba y filtre por intenciones.

Informe de resumen de ejecución de prueba

El informe de resumen le proporciona una evaluación general de cómo el modelo puede manejar correctamente el tipo de entrada de usuario que se trata en la ejecución de prueba. Para los conjuntos de pruebas incluidos en la ejecución de prueba, muestra el número total de casos de prueba que se han utilizado para evaluar el modelo y, a partir de ese total, el número de casos de prueba (tanto fiables como no fiables) que han fallado junto con el número de casos de prueba fiables y no fiables que han pasado. La precisión general del modelo (su capacidad para predecir intenciones esperadas en o por encima del nivel de confianza de la aptitud, reconocer valores de entidad y resolver expresiones en el idioma de la aptitud) se mide por el ratio de éxito de las pruebas de aprobación en la ejecución de prueba.

Descripción de la ilustración test-run-test-results-summary.png

Métricas de informe resumido

- Precisión: la precisión del modelo en términos de la tasa de éxito de los casos de prueba aprobados (el número de casos de prueba aprobados en comparación con el número total de casos de prueba incluidos en la ejecución de prueba).

Nota

Los casos de prueba desactivados no se tienen en cuenta en la puntuación de precisión. Tampoco son las pruebas que fallaron debido a errores. Cualquier prueba que haya fallado se agrega al recuento de fallos.Una puntuación de precisión baja podría indicar que la ejecución de la prueba está evaluando el modelo en conceptos y lenguaje que no están adecuadamente soportados por los datos de entrenamiento. Para aumentar la puntuación de precisión, vuelva a entrenar el modelo con expresiones que reflejen los casos de prueba en la ejecución de prueba.

Esta métrica de precisión se aplica a toda la ejecución de prueba y proporciona una puntuación independiente de la métrica de precisión en el informe Intenciones. Esta métrica es el porcentaje de casos de prueba en los que el modelo ha pasado todos los criterios de caso de prueba. Por otro lado, la puntuación de precisión del informe Intenciones no es una prueba integral. Es el porcentaje de casos de prueba en los que el modelo solo tenía que predecir la intención esperada en el umbral de confianza de la aptitud o por encima de este. No se tienen en cuenta otros criterios de casos de prueba (como el valor de enidad o el lenguaje de aptitudes). Dados los diferentes criterios de lo que significa un caso de prueba aprobado para estos dos informes, sus respectivas puntuaciones de precisión pueden no estar siempre en el paso. La puntuación de precisión de coincidencia de intención puede ser superior a la puntuación general de ejecución de prueba cuando los datos de prueba no están alineados con los datos de entrenamiento. Al volver a entrenar el modelo con expresiones que soporten los casos de prueba, podrá predecir las intenciones esperadas con una mayor confianza que, a su vez, aumentará la puntuación de precisión para la ejecución de prueba.

Nota

La métrica de precisión no estará disponible hasta que finalice la ejecución de prueba y no estará disponible para las ejecuciones de prueba que se hayan completado cuando la aptitud se haya ejecutado en versiones anteriores a la versión 22.12 de la plataforma Oracle Digital Assistant. - Casos de prueba: el número total de casos de prueba (tanto fiables como no fiables) incluidos en la ejecución de prueba. Los casos de prueba omitidos se incluyen en esta cuenta, pero no se tienen en cuenta al calcular la métrica de precisión.

- Aprobado: número de casos de prueba (tanto fiables como no fiables) que se transfieren resolviendo la intención en el umbral de confianza y haciendo coincidir los valores de entidad o el idioma seleccionados.

- Con fallos: número de casos de prueba (fiable y poco fiable del bot) que no se resolvieron en la intención esperada en el umbral de confianza y que no coincidieron con los valores o el idioma de la entidad seleccionados.

Para revisar los casos de prueba reales detrás de las métricas aprobadas y fallidas de este informe, abra el informe Casos de prueba y, a continuación, aplique los filtros aprobados o con fallos.

Descripción de la ilustración test-runs-intent-report.png

Desglose de conjunto de pruebas

La tabla Desglose de Conjunto de Pruebas muestra los conjuntos de pruebas incluidos en la ejecución de prueba y sus estadísticas individuales. Puede revisar los casos de prueba reales que pertenecen a un conjunto de pruebas haciendo clic en el enlace de la columna Conjunto de pruebas.

Descripción de la ilustración test-suite-breakdown.png

Informe de intenciones

Las métricas de este informe realizan un seguimiento de las coincidencias de etiqueta del modelo en los casos de prueba de la ejecución de prueba. Aquí es donde el modelo predice correctamente la intención esperada para la expresión del caso de prueba. En el contexto de este informe, la precisión, el paso y el fallo se miden en términos de los casos de prueba en los que el modelo predijo la intención esperada correcta en o por encima del umbral de confianza. No se tienen en cuenta otros criterios que se tienen en cuenta en el informe de resumen, como coincidencias de valores de entidad o idioma de aptitud. Como resultado, este informe le proporciona una vista diferente de la precisión del modelo, que le ayuda a verificar si el entrenamiento actual permite al modelo predecir de forma consistente las intenciones correctas.

Este informe no está disponible para ejecuciones de prueba que se hayan completado cuando la aptitud se ejecutó en una versión anterior a la 22.12 de la plataforma Oracle Digital Assistant.

Métricas de informe de intenciones

- Casos de prueba: número de casos de prueba incluidos en esta ejecución de prueba. Este total incluye casos de prueba confiables y no confiables. Los casos de prueba omitidos no se incluyen en este recuento.

Consejo:

Los enlaces de casos de prueba no fiables para las métricas Casos de prueba, Pasados y Fallidos abren el informe Casos de prueba filtrado por casos de prueba no fiables. Esta navegación no está disponible al filtrar el informe por conjunto de pruebas. - Precisión: la precisión del modelo al coincidir con la intención esperada en el umbral de confianza de la aptitud o por encima de este en los casos de prueba de esta ejecución de prueba. La submétrica Coincidencia de etiqueta representa el porcentaje de casos de prueba en la ejecución de prueba en los que el modelo predijo correctamente la intención esperada, independientemente de la puntuación de confianza. Debido a que los factores de coincidencia de etiquetas en casos de prueba fallidos junto con la aprobación de casos de prueba, su puntuación puede ser superior a la puntuación de precisión.

Puede comparar esta métrica de precisión con la métrica de precisión del informe de resumen. Cuando la puntuación de precisión en el informe de resumen es baja, puede utilizar este informe para averiguar rápidamente si los fallos del modelo se pueden atribuir a su incapacidad para predecir la intención esperada. Sin embargo, cuando la puntuación de precisión de este informe es alta, puede descartar la coincidencia de etiquetas como raíz del problema y, en lugar de tener que revisar en gran medida los datos de entrenamiento para aumentar la puntuación de precisión de la ejecución de prueba, puede centrarse en agregar expresiones que reflejen los conceptos y el idioma en las expresiones del caso de prueba.

- Aprobado: número de casos de prueba (confiables y no fiables) en los que el modelo predijo la intención esperada en el umbral de confianza de la aptitud.

- Con fallos: número de casos de prueba (confiables y no fiables) en los que el modelo predijo la intención esperada por debajo del umbral de confianza de la aptitud.

- Confidence Pass: media de las puntuaciones de confianza de todos los casos de prueba que se aprobaron en esta ejecución de prueba.

- Fallo de confianza: media de las puntuaciones de confianza de todos los casos de prueba que han fallado en esta ejecución de prueba.

Al filtrar el informe de intenciones por conjunto de pruebas, el acceso al informe de casos de prueba desde los enlaces de casos de prueba no fiables en los mosaicos Casos de prueba, Aprobados y Fallidos no está disponible. Estos vínculos vuelven a activarse al eliminar todas las entradas del campo Filtrar por conjunto de pruebas.

Filtrar por conjunto de pruebas

El informe ajusta las métricas de cada conjunto de pruebas que agregue (o elimine posteriormente). Tabula los resultados de coincidencia de intención en términos del número de casos de prueba activados que pertenecen al conjunto de pruebas seleccionado.

No puede filtrar por conjuntos de pruebas que se ejecutaron en una plataforma antes de la versión 23.06. Para incluir estos conjuntos de prueba, debe volver a ejecutarlos después de actualizar a la versión 23.06 o superior.

El filtrado por conjunto de pruebas desactiva la navegación al informe de casos de prueba desde los enlaces de casos de prueba no fiables en los mosaicos Casos de prueba, Aprobados y Fallidos. Los enlaces de la columna Total del desglose de intenciones también están desactivados. Todos estos enlaces vuelven a estar activos después de eliminar todas las entradas del campo Filtrar por conjunto de pruebas.

Desglose de intenciones

El campo Filtrar por intención cambia la vista de la tabla Desglose de intenciones, pero no cambia las métricas generales del informe. Estas métricas reflejan las entradas (o la falta de entradas) en el campo Filtrar por conjunto de pruebas.

- Intención: nombre de la intención esperada.

- Total: número de casos de prueba, representados como un enlace, para la intención esperada. Puede desplazarse hasta el informe Casos de prueba haciendo clic en este enlace.

Nota

No puede navegar al informe Casos de prueba cuando ha aplicado un filtro de conjunto de pruebas a este informe. Este vínculo vuelve a activarse al eliminar todas las entradas del campo Filtrar por Conjunto de Pruebas. - Precisión: porcentaje de casos de prueba que han dado como resultado coincidencias de etiquetas para la intención esperada en el umbral de confianza de la aptitud o por encima de este.

- Aprobado: número de casos de prueba (incluidos los casos de prueba no fiables) en los que el modelo predijo la intención esperada en el umbral de confianza de la aptitud o por encima de este.

- Aprobado: no fiable: número de casos de prueba en los que el modelo predijo la intención esperada en un 5 % o menos por encima del umbral de confianza de la aptitud.

- Fallo: número de casos de prueba en la ejecución de prueba que han fallado porque el modelo predijo la intención esperada por debajo del umbral de confianza de la aptitud.

- Con fallos: no fiable: número de casos de prueba que han fallado porque la confianza del modelo en la predicción de la intención esperada ha caído un 5 % por debajo del umbral de confianza de la aptitud. Estos casos de prueba pueden tener en cuenta

- Coincidencia de etiquetas: número de casos de prueba en los que el modelo predijo correctamente la intención esperada, independientemente del nivel de confianza. Debido a que influye en los casos de prueba fallidos, es posible que las puntuaciones de coincidencia de etiquetas y precisión no siempre estén alineadas entre sí. Por ejemplo, cuatro casos de prueba aprobados de cinco resultados en una puntuación de precisión del 80% para la intención. Sin embargo, si el modelo predijo la intención correctamente para el caso de prueba que falla, la coincidencia de etiquetas superaría la precisión en un 20 %.

- Paso de confianza: media de las puntuaciones de confianza de todos los casos de prueba que coinciden correctamente con la intención esperada.

- Fallo de confianza: media de las puntuaciones de confianza de todos los casos de prueba que no coinciden con la intención esperada.

Consejo:

Para revisar los casos de prueba reales, abra el informe Casos de prueba y el filtro por intención.

Informe de casos de prueba

- Puede filtrar los resultados haciendo clic en Todas, Aprobada (verde) o Con fallos (rojo). Los casos de prueba contados como omitidos incluyen casos de prueba desactivados y casos de prueba en los que se haya desactivado la intención esperada.

Puede filtrar los resultados por casos de prueba no confiables haciendo clic en Mostrar casos no confiables en el mensaje de advertencia o seleccionando el filtro Solo casos no confiables. - Si es necesario, filtre los resultados para una intención o entidad específica o por casos de prueba fiables o no fiables.

- Para los casos de prueba no fiables y con fallos, haga clic en Ver expresiones similares (ubicado en la página Información de prueba) para averiguar si la expresión de caso de prueba tiene cualquier similitud con las expresiones del juego de entrenamiento.

- Compruebe los siguientes resultados:

- Información de prueba: presenta la visión general del caso de prueba, incluido el umbral de confianza de destino, la intención esperada y los valores de entidad coincidentes.

- Resultado de la prueba: clasificación de la intención por nivel de confianza. Cuando está presente, el informe también identifica las entidades incluidas en la expresión por nombre y valor de entidad. También puede ver el objeto JSON que contiene los resultados completos.

- Análisis de fallos: explica por qué falló el caso de prueba. Por ejemplo, la intención real no es la intención esperada, el valor de la entidad etiquetada en el caso de prueba no coincide con la entidad resuelta o el idioma esperado no es el mismo que el idioma detectado.

Casos de prueba no fiables

Algunos casos de prueba no pueden proporcionar resultados consistentes porque se resuelven dentro del 5 % o menos del umbral de confianza. Este margen estrecho hace que estos casos de prueba sean poco fiables. Cuando el umbral de confianza de la aptitud se define en 0,7, por ejemplo, un caso de prueba que se supere en el 74 % puede fallar después de realizar solo modificaciones menores en los datos de entrenamiento o porque la aptitud se ha actualizado a una nueva versión del modelo. La fragilidad de estos casos de prueba puede indicar que las expresiones que representan en los datos de entrenamiento pueden ser demasiado pocas en número y que puede que necesite equilibrar los datos de entrenamiento de la intención con expresiones similares.

- Ejecute el conjunto de pruebas. A continuación, haga clic en Resultados de la prueba y seleccione la ejecución de la prueba. Los casos de prueba no fiables se ordenan al principio de los resultados de la ejecución de prueba y se marcan con advertencias

.

. - Para aislar los casos de prueba poco fiables:

- Haga clic en Mostrar los casos no fiables en el mensaje.

- Seleccione Solo casos no fiables en el menú Filtrar por casos.

- Haga clic en Mostrar los casos no fiables en el mensaje.

- Para buscar la proximidad de la intención de clasificación superior del caso de prueba al umbral de confianza, abra la ventana Resultado de la prueba. Para comparar la puntuación de confianza de la clasificación superior con el umbral de confianza, haga clic en

.

. - Si necesita complementar los datos de entrenamiento para la intención de primer nivel, haga clic en Ir a la intención principal en el mensaje de advertencia.

- Si desea determinar la cantidad de expresiones que representa el caso de prueba en los datos de entrenamiento, haga clic en Ver expresiones similares.

También puede comprobar si alguna de las expresiones más similares a la expresión de caso de prueba también son anomalías en el juego de entrenamiento ejecutando el informe de anomalías.

Ejecuciones de prueba exportadas

Las ejecuciones de pruebas no se conservan con la aptitud, pero puede descargarlas en el sistema para su análisis haciendo clic en Exportar ejecución de prueba. Si las intenciones ya no resuelven los datos introducidos por el usuario como se esperaba, o si los cambios de la plataforma han afectado negativamente a la resolución de la intención, puede recopilar los detalles de una SS (solicitud de servicio) mediante los logs de ejecuciones de prueba exportadas.

Prueba de fallos

La prueba de fallos (o negativa) permite realizar pruebas masivas a expresiones que nunca se deben resolver, ya sea porque dan como resultado unresolvedIntent o porque solo se resuelven en otras intencionespor debajo del umbral de seguridad para todas las intenciones.

- Especifique unresolvedIntent como intención esperada para todos los casos de prueba que espera que no se resuelvan. En una situación idea, estas frases "falsas" se quedarán sin resolver.

- Si es necesario, ajuste el umbral de seguridad al crear una ejecución de prueba para confirmar que las frases falsas (las cuales tienen

unresolvedIntentcomo intención esperada) solo puedan resolverse con el valor inferior al definido aquí. Por ejemplo, si aumenta el umbral podría causar que las frases falsas no se resuelvan en el nivel de confianza en ninguna intención (incluida unresolvedIntent), lo que significa que lo superarían porque se considerarían no resueltas. - Revise los resultados de la prueba y compruebe que los casos de prueba coinciden con unresolvedIntent en el umbral o que no coinciden con ninguna intención (unresolvedIntent u otra) en el umbral.

Expresiones similares

Puede averiguar cuán similar es la frase de prueba a las expresiones del corpus de entrenamiento haciendo clic en Ver expresiones similares. Esta herramienta proporciona una perspectiva adicional sobre los datos de entrenamiento de la aptitud mostrándole lo similares que son sus expresiones a la frase de prueba y, por extensión, lo similares que son las expresiones entre las intenciones. Con esta herramienta, puede averiguar si la similitud de la frase de prueba con las expresiones que pertenecen a otras intenciones es el motivo por el que la frase de prueba no se resuelve como se esperaba. Incluso puede indicar dónde pertenecen los datos de entrenamiento a la intención incorrecta porque si son similares a la frase de prueba.

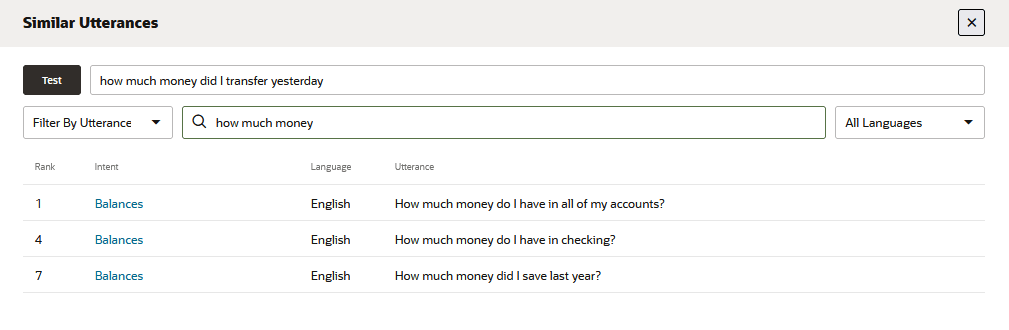

Descripción de la ilustración similar-utterance-report-all-intents.png

La lista generada por esta herramienta clasifica 20 expresiones (junto con sus intenciones asociadas) que están más cerca de la frase de prueba. Lo ideal es que la expresión de mayor rango de esta lista, la más parecida a la frase de prueba, pertenezca a la intención que se dirige a la frase de prueba. Si la expresión más cercana que pertenece a la intención esperada está más abajo, una revisión de la lista puede proporcionar algunas indicaciones sobre el motivo. Por ejemplo, si está probando una expresión de intención de transacciones, ¿Cuánto dinero transferí ayer?, esperaría que la expresión de mayor rango perteneciera también a una intención de transacciones. Sin embargo, si esta expresión de prueba se resuelve en una intención incorrecta o se resuelve por debajo del nivel de confianza, la lista puede revelar que tiene más en común con expresiones altamente clasificadas con una redacción similar que pertenece a otras intenciones. La expresión ¿Cuánto dinero tengo en todas mis cuentas? de la intención Balances, por ejemplo, podría estar más cerca de la expresión de prueba que la expresión ¿Cuánto deposité en abril? de menor rango de la intención Transacciones.

Solo puede utilizar esta herramienta para las aptitudes entrenadas en Trainer Tm (no está disponible para las aptitudes entrenadas con Ht).

- Filtrar por intención: devuelve 20 expresiones que están más cerca de la expresión de prueba que pertenecen a la intención (o intenciones) seleccionada.

- Filtrar por expresión: devuelve 20 de las expresiones más cercanas a la expresión de prueba que contienen una palabra o frase.

- Idioma: para aptitudes multilingües, puede consultar y filtrar el informe seleccionando un idioma.

La aplicación de estos filtros no cambia las clasificaciones, solo la vista. Una expresión clasificada en tercer lugar, por ejemplo, se indicará como tal independientemente del filtro. Las clasificaciones y el contenido del informe solo cambian cuando se actualiza el corpus y se vuelve a entrenar la aptitud con Trainer Tm.