Ejemplo

Configuración de replicación de datos basada en host con el software Sun StorageTek Availability Suite

En este apéndice, se proporciona una replicación alternativa basada en host que no utiliza Oracle Solaris Cluster Cluster Geographic Edition. Oracle recomienda el uso de Oracle Solaris Cluster Geographic Edition para la replicación basada en host con el fin de simplificar la configuración y el funcionamiento de la replicación basada en host entre clusters. Consulte Comprensión de la replicación de datos.

En el ejemplo de este apéndice, se muestra cómo configurar la replicación de datos basada en host entre clusters con el software Función Availability Suite de Oracle Solaris. El ejemplo muestra una configuración de cluster completa para una aplicación NFS que proporciona información detallada sobre cómo realizar tareas individuales. Todas las tareas deben llevarse a cabo en el cluster global. El ejemplo no incluye todos los pasos necesarios para otras aplicaciones ni las configuraciones de otros clusters.

Si utiliza el control de acceso basado en roles (RBAC) para acceder a los nodos del cluster, asegúrese de poder asumir un rol de RBAC que proporcione autorización para todos los comandos de Oracle Solaris Cluster. Esta serie de replicación de datos necesita las siguientes autorizaciones RBAC de Oracle Solaris Cluster:

solaris.cluster.modify

solaris.cluster.admin

solaris.cluster.read

Consulte Protección de los usuarios y los procesos en Oracle Solaris 11.2 para obtener más información sobre el uso de roles RBAC. Consulte las páginas del comando man de Oracle Solaris Cluster para saber la autorización de RBAC que requiere cada subcomando de Oracle Solaris Cluster.

Comprensión del software Sun StorageTek Availability Suite en un cluster

Esta sección presenta la tolerancia ante desastres y describe los métodos de replicación de datos que utiliza el software de Sun StorageTek Availability Suite

La tolerancia a desastres es la capacidad de restaurar una aplicación en un cluster alternativo cuando el cluster principal falla. La tolerancia a desastres se basa en la replicación de datos y la recuperación. Una recuperación reubica un servicio de aplicaciones en un cluster secundario estableciendo en línea uno o más grupos de recursos y grupos de dispositivos.

Si los datos se replican de manera síncrona entre el cluster principal y el secundario, no se pierde ningún dato comprometido cuando el sitio principal falla. Sin embargo, si los datos se replican de manera asíncrona, es posible que algunos datos no se repliquen en el cluster secundario antes del fallo del sitio principal y, por lo tanto, se pierdan.

Métodos de replicación de datos utilizados por Sun StorageTek Availability Suite

Esta sección describe los métodos de replicación por duplicación remota y de instantánea de un momento determinado utilizados por Sun StorageTek Availability Suite. Este software utiliza los comandos sndradm e iiadm para replicar datos. Para obtener más información, consulte las páginas del comando man sndradm(1M) y iiadm(1M).

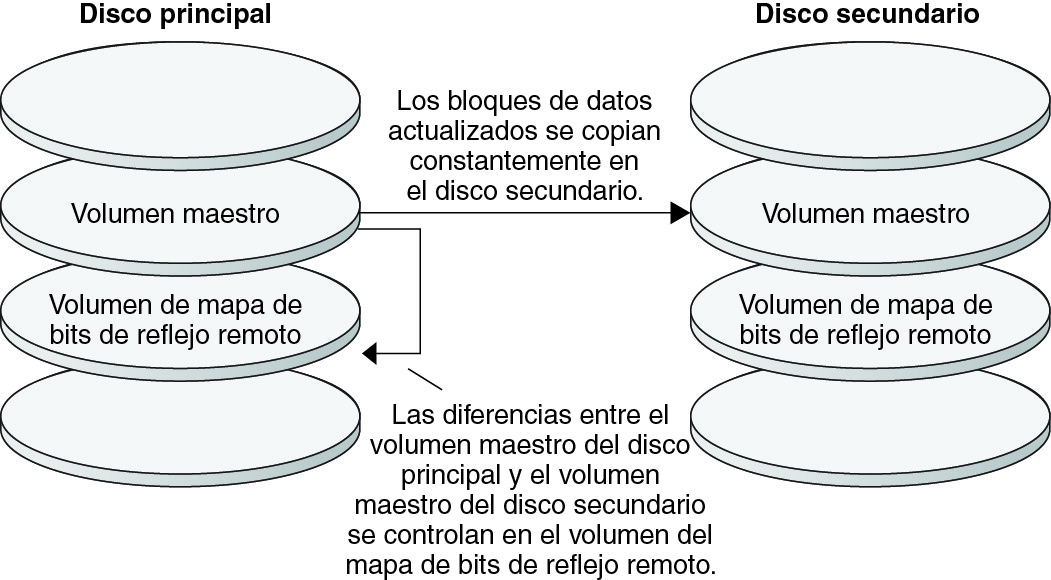

Replicación de reflejo remoto

La Figure A–1 muestra la replicación de reflejo remoto. Los datos del volumen maestro del disco primario se duplican en el volumen maestro del disco secundario mediante una conexión TCP/IP. Un mapa de bits de duplicación remota controla las diferencias entre el volumen maestro del disco primario y el del secundario.

Figura A-1 Replicación de reflejo remoto

En una replicación de datos síncrona, no se confirma la finalización de una operación de escritura hasta que se haya actualizado el volumen remoto.

En una replicación de datos asíncrona, se confirma la finalización de una operación de escritura antes de que se actualice el volumen remoto La replicación asincrónica de datos proporciona una mayor flexibilidad en largas distancias y poco ancho de banda.

La replicación por duplicación remota se puede efectuar de manera sincrónica en tiempo real o de manera asincrónica. Cada volumen definido en cada cluster se puede configurar de manera individual, para replicación sincrónica o asincrónica.

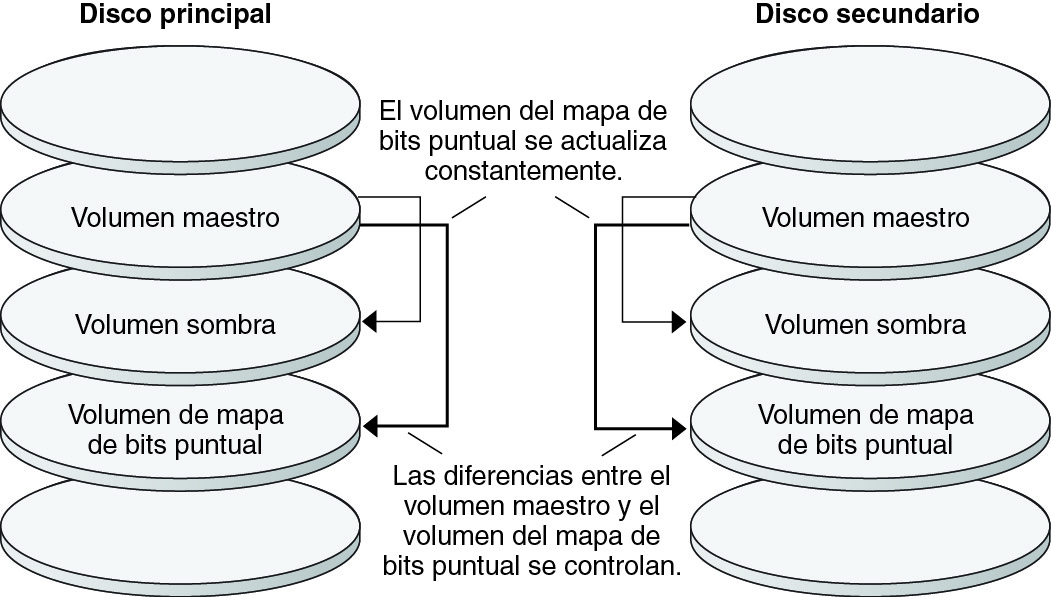

Instantánea de un momento determinado

La Figure A–2 muestra una instantánea de un momento determinado. Los datos del volumen primario de cada disco se copian en el volumen sombra del mismo disco. El mapa de bits instantáneo controla y detecta las diferencias entre el volumen primario y el volumen sombra. Cuando los datos se copian en el volumen sombra, el mapa de bits de un momento determinado se vuelve a configurar.

Figura A-2 Instantánea de un momento determinado

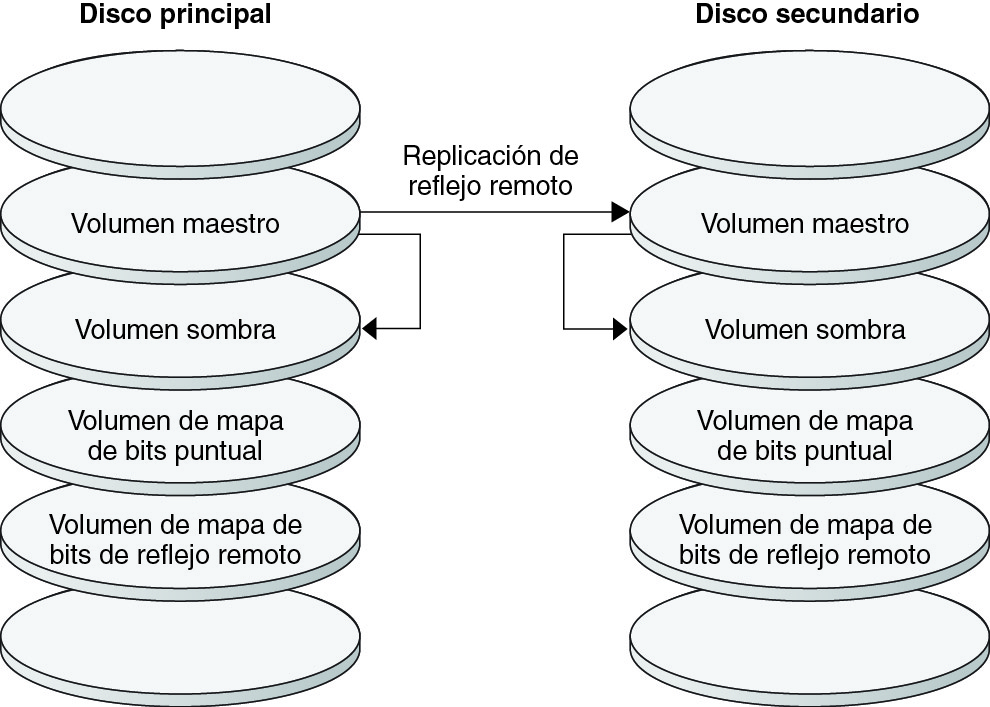

Replicación en la configuración de ejemplo

La Figure A–3 ilustra la forma en que se usan la replicación por duplicación remota y la instantánea de un momento determinado en este ejemplo de configuración.

Figura A-3 Replicación en la configuración de ejemplo

Directrices para la configuración de replicación de datos basada en host entre clusters

En esta sección, se proporcionan directrices para configurar la replicación de datos entre clusters. Asimismo, se proporcionan consejos para configurar los grupos de recursos de replicaciones y los de recursos de aplicaciones. Use estas directrices cuando esté configurando la replicación de datos en el cluster.

En esta sección se analizan los aspectos siguientes:

Configuración de grupos de recursos de replicaciones

Los grupos de recursos de replicaciones sitúan el grupo de dispositivos bajo el control del software Sun StorageTek Availability Suite con un recurso de nombre de host lógico. Debe existir un nombre de host lógico en cada extremo del flujo de replicación de datos y debe encontrarse en el mismo nodo del cluster que actúa como la ruta de E/S principal para el dispositivo. Un grupo de recursos de replicaciones debe tener las características siguientes:

Ser un grupo de recursos de migración tras error.

Un recurso de migración tras error sólo puede ejecutarse en un nodo a la vez. Cuando se produce la migración tras error, los recursos de recuperación participan en ella.

Tener un recurso de nombre de host lógico.

Un nombre de host lógico se aloja en un nodo de cada cluster (principal y secundario) y se utiliza para proporcionar direcciones de origen y destino para el flujo de replicación de datos del software Sun StorageTek Availability Suite.

Tener un recurso HAStoragePlus.

El recurso de HAStoragePlus fuerza la migración tras error del grupo de dispositivos si el grupo de recursos de replicaciones se conmuta o migra tras error. Oracle Solaris Cluster también fuerza la migración tras error del grupo de recursos de replicaciones si el grupo de dispositivos se conmuta. De este modo, es siempre el mismo nodo el que sitúa o controla el grupo de recursos de replicaciones y el de dispositivos.

Las propiedades de extensión siguientes se deben definir en el recurso de HAStoragePlus:

GlobalDevicePaths. La propiedad de esta extensión define el grupo de dispositivos al que pertenece un volumen.

AffinityOn property = True. La propiedad de esta extensión provoca que el grupo de dispositivos se conmute o migre tras error si el grupo de recursos de replicaciones también lo hace. Esta función se denomina conmutación de afinidad.

Para obtener más información sobre HAStoragePlus, consulte la página del comando man SUNW.HAStoragePlus(5).

Recibir el nombre del grupo de dispositivos con el que se coloca, seguido de -stor-rg

Por ejemplo, devgrp-stor-rg.

Estar en línea en el cluster primario y en el secundario

Configuración de grupos de recursos de aplicaciones

Para estar ampliamente disponible, una aplicación se debe gestionar como un recurso en un grupo de recursos de aplicaciones. Un grupo de recursos de aplicaciones se puede configurar en una aplicación de migración tras error o en una aplicación escalable.

La propiedad de extensión ZPoolsSearchDir se debe definir en el recurso HAStoragePlus. Esta propiedad de extensión es necesaria para utilizar el sistema de archivos ZFS.

Los recursos de aplicaciones y los grupos de recursos de aplicaciones configurados en el cluster primario también se deben configurar en el cluster secundario. Asimismo, se deben replicar en el cluster secundario los datos a los que tiene acceso el recurso de aplicaciones.

Esta sección proporciona directrices para la configuración de grupos de recursos de aplicaciones siguientes:

Configuración de grupos de recursos en una aplicación de migración tras error

Configuración de grupos de recursos en una aplicación escalable

Configuración de grupos de recursos en una aplicación de migración tras error

En una aplicación de migración tras error, una aplicación se ejecuta en un solo nodo a la vez. Si éste falla, la aplicación migra a otro nodo del mismo cluster. Un grupo de recursos de una aplicación de migración tras error debe tener las características siguientes:

Debe tener un recurso de HAStoragePlus para aplicar la conmutación por error del sistema de archivos o zpool cuando el grupo de recursos de aplicaciones se conmuta.

El grupo de dispositivos se coloca con el grupo de recursos de replicaciones y el grupo de recursos de aplicaciones. Por este motivo, la migración tras error del grupo de recursos de aplicaciones fuerza la migración de los grupos de dispositivos y de recursos de replicaciones. El mismo nodo controla los grupos de recursos de aplicaciones y de recursos de replicaciones, y el grupo de dispositivos.

Sin embargo, que una migración tras error del grupo de dispositivos o del grupo de recursos de replicaciones no desencadena una migración tras error en el grupo de recursos de aplicaciones.

Si los datos de la aplicación están montados de manera global, la presencia de un recurso de HAStoragePlus en el grupo de recursos de aplicaciones no es obligatoria, aunque sí aconsejable.

Si los datos de la aplicación se montan de manera local, la presencia de un recurso de HAStoragePlus en el grupo de recursos de aplicaciones es obligatoria.

Para obtener más información sobre HAStoragePlus, consulte la página del comando man SUNW.HAStoragePlus(5).

Debe estar en línea en el cluster principal y sin conexión en el cluster secundario.

El grupo de recursos de aplicaciones debe estar en línea en el cluster secundario cuando éste hace las funciones de cluster primario.

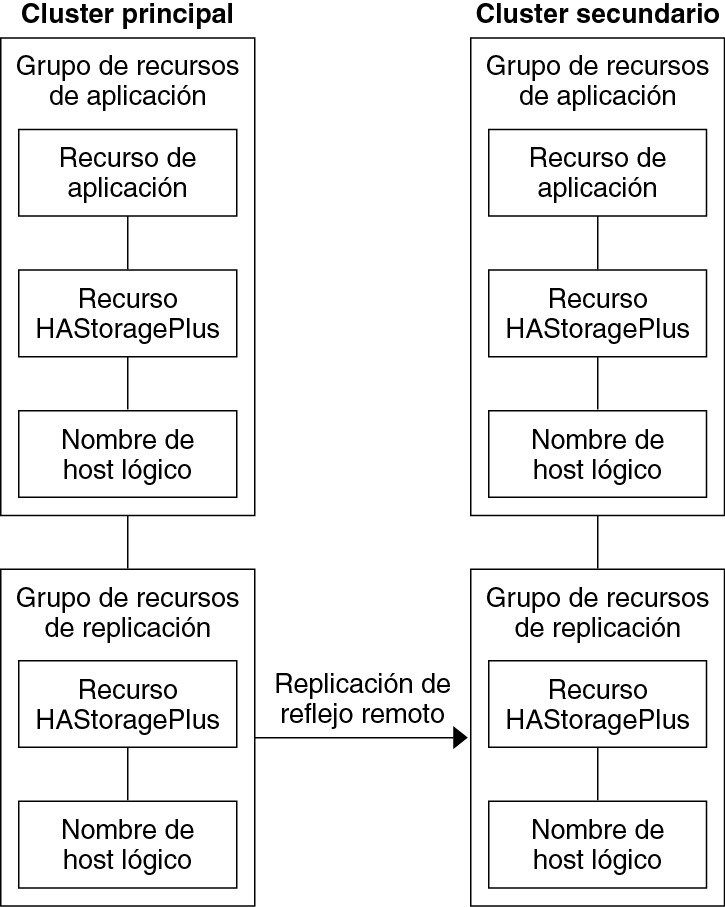

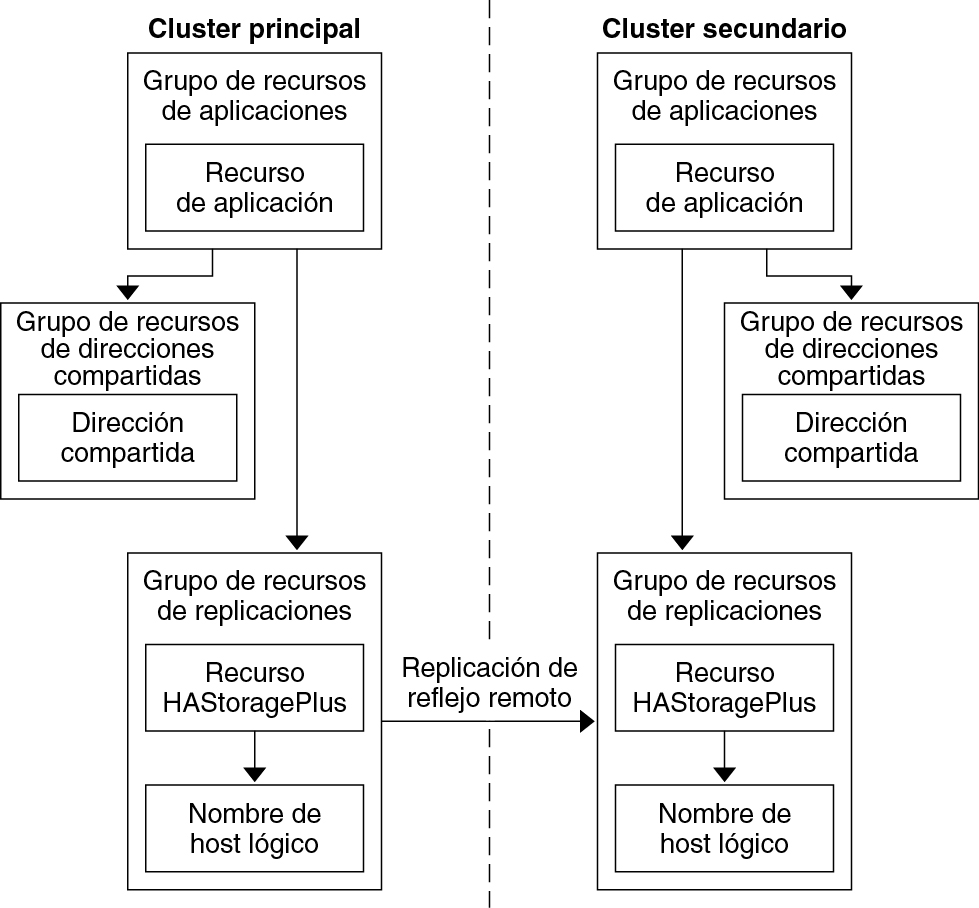

La Figure A–4 ilustra la configuración de grupos de recursos de aplicaciones y de recursos de replicaciones en una aplicación de migración tras error.

Figura A-4 Configuración de grupos de recursos en una aplicación de migración tras error

Configuración de grupos de recursos en una aplicación escalable

En una aplicación escalable, una aplicación se ejecuta en varios nodos con el fin de crear un único servicio lógico. Si se produce un error en un nodo que ejecuta una aplicación escalable, no habrá migración tras error. La aplicación continúa ejecutándose en los otros nodos.

Cuando una aplicación escalable se administra como recurso en un grupo de recursos de aplicaciones, no es necesario acoplar el grupo de recursos de aplicaciones con el grupo de dispositivos. Por este motivo, no es necesario crear un recurso de HAStoragePlus para el grupo de recursos de aplicaciones.

Tener una dependencia en el grupo de recursos de direcciones compartidas.

Los nodos que ejecutan la aplicación escalable utilizan la dirección compartida para distribuir datos entrantes.

Estar en línea en el cluster primario y fuera de línea en el secundario.

Un grupo de recursos de una aplicación escalable debe tener las características siguientes:

La Figure A–5 ilustra la configuración de grupos de recursos en una aplicación escalable.

Figura A-5 Configuración de grupos de recursos en una aplicación escalable

Directrices para la gestión de una recuperación

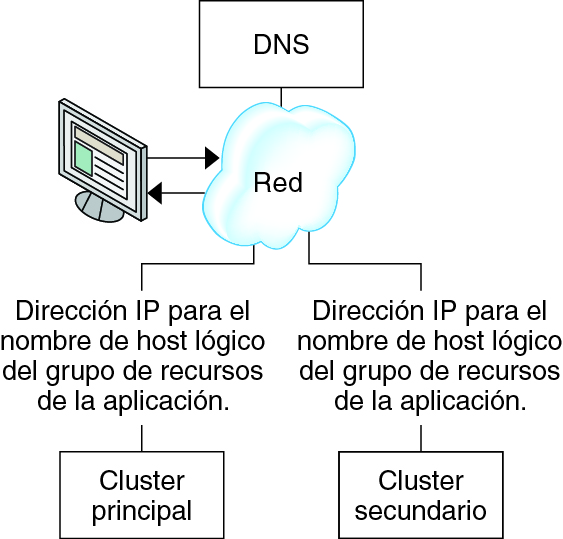

Si el cluster principal falla, la aplicación se debe conmutar al cluster secundario lo antes posible. Para que el cluster secundario pueda realizar las funciones del principal, se debe actualizar el DNS.

Los clientes usan el DNS para asignar el nombre de host lógico de una aplicación a una dirección IP. Después de una recuperación, donde la aplicación se mueve a un cluster secundario, la información del DNS debe actualizarse para reflejar la asignación entre el nombre de host lógico de la aplicación y la dirección IP nueva.

Figura A-6 Asignación del DNS de un cliente a un cluster

Si desea actualizar el DNS, utilice el comando nsupdate. Para obtener información, consulte la página del comando man nsupdate(1M). Por ver un ejemplo de cómo gestionar una recuperación, consulte Ejemplo de cómo gestionar una recuperación.

Después de la reparación, el cluster principal se puede volver a colocar en línea. Para volver al cluster primario original, siga estos pasos:

Sincronice el cluster primario con el secundario para asegurarse de que el volumen principal esté actualizado. Puede hacerlo deteniendo el grupo de recursos en el nodo secundario, de modo que el flujo de datos de replicación pueda drenar.

Revierta la dirección de la replicación de datos, de modo que el nodo principal original esté ahora, otra vez, replicando los datos en el nodo secundario original.

Inicie el grupo de recursos en el cluster principal.

Actualice el DNS de modo que los clientes tengan acceso a la aplicación en el cluster primario.

Mapa de tareas: ejemplo de configuración de una replicación de datos

La Table A–1 enumera las tareas pertenecientes a este ejemplo de configuración de replicación de datos para una aplicación NFS mediante el software de Sun StorageTek Availability Suite.

|

Conexión e instalación de clusters

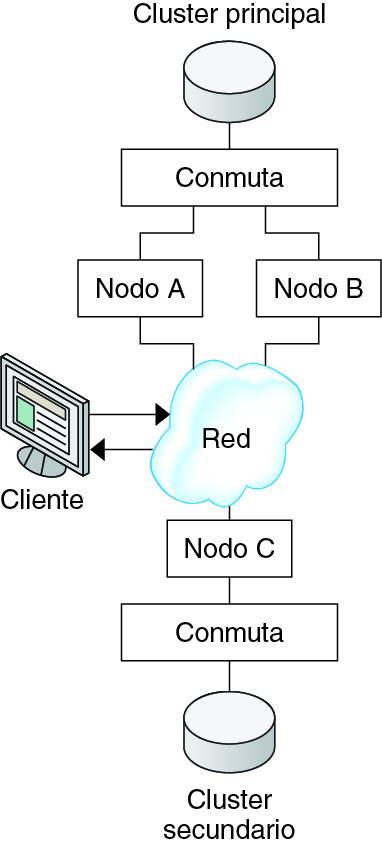

La Figure A–7 ilustra la configuración de clusters utilizada en la configuración de ejemplo. El cluster secundario de la configuración de ejemplo contiene un nodo, pero se pueden usar otras configuraciones de cluster.

Figura A-7 Ejemplo de configuración del cluster

La Table A–2 resume el hardware y el software necesarios para la configuración de ejemplo. El sistema operativo Oracle Solaris, el software Oracle Solaris Cluster y el software Volume Manager deben instalarse en los nodos del cluster antes de instalar las actualizaciones del software y el software Sun StorageTek Availability Suite.

|

Ejemplo de configuración de grupos de dispositivos y de recursos

Esta sección describe cómo se configuran los grupos de dispositivos y los de recursos en una aplicación NFS. Para obtener más información, consulte Configuración de grupos de recursos de replicaciones y Configuración de grupos de recursos de aplicaciones.

Configuración de un grupo de dispositivos en el cluster primario

Configuración de un grupo de dispositivos en el cluster secundario

Configuración de sistemas de archivos en el cluster primario para la aplicación NFS

Configuración del sistema de archivos en el cluster secundario para la aplicación NFS

Creación de un grupo de recursos de replicaciones en el cluster primario

Creación de un grupo de recursos de replicaciones en el cluster secundario

Creación de un grupo de recursos de aplicaciones NFS en el cluster primario

Creación de un grupo de recursos de aplicaciones NFS en el cluster secundario

Procedimiento para comprobar la configuración de la replicación

Esta sección incluye los procedimientos siguientes:

La tabla siguiente enumera los nombres de los grupos y recursos creados para la configuración de ejemplo.

|

Con la excepción de devgrp-stor-rg, los nombres de los grupos y recursos son nombres de ejemplos que se pueden cambiar cuando sea necesario. El grupo de recursos de replicaciones debe tener un nombre con el formato devicegroupname-stor-rg.

Para obtener información sobre el software de Solaris Volume Manager, consulte el Capítulo 4, Configuración del software de Solaris Volume Manager de Guía de instalación del software de Oracle Solaris Cluster .

Configuración de un grupo de dispositivos en el cluster primario

Antes de empezar

Asegúrese de realizar las tareas siguientes:

Lea las directrices y los requisitos de las secciones siguientes:

Configure los clusters primario y secundario como se describe en Conexión e instalación de clusters.

- Para acceder a nodeA, asuma el rol que proporciona la autorización RBAC solaris.cluster.modify.

El nodo nodeA es el primero del cluster primario. Si desea recordar qué nodo es nodeA, consulte la Figure A–7.

- Cree un metaconjunto para colocar los datos NFS y la replicación asociada.

nodeA# metaset -s nfsset a -h nodeA nodeB

- Agregue discos al metaconjunto.

nodeA# metaset -s nfsset -a /dev/did/dsk/d6 /dev/did/dsk/d7

- Agregue mediadores al metaconjunto.

nodeA# metaset -s nfsset -a -m nodeA nodeB

- Cree los volúmenes requeridos (o metadispositivos).

Cree dos componentes de un reflejo:

nodeA# metainit -s nfsset d101 1 1 /dev/did/dsk/d6s2 nodeA# metainit -s nfsset d102 1 1 /dev/did/dsk/d7s2

Cree el reflejo con uno de los componentes:

nodeA# metainit -s nfsset d100 -m d101

Conecte el otro componente al reflejo y deje que se sincronice:

nodeA# metattach -s nfsset d100 d102

Cree particiones de software a partir del reflejo, siguiendo estos ejemplos:

d200: los datos NFS (volumen maestro).

nodeA# metainit -s nfsset d200 -p d100 50G

d201: el volumen de copia puntual para los datos NFS.

nodeA# metainit -s nfsset d201 -p d100 50G

d202: el volumen de mapa de bits puntual.

nodeA# metainit -s nfsset d202 -p d100 10M

d203: el volumen de mapa de bits de sombra remoto.

nodeA# metainit -s nfsset d203 -p d100 10M

d204: el volumen para la información de configuración SUNW.NFS de Oracle Solaris Cluster.

nodeA# metainit -s nfsset d204 -p d100 100M

- Cree sistemas de archivos para los datos NFS y el volumen de configuración.

nodeA# yes | newfs /dev/md/nfsset/rdsk/d200 nodeA# yes | newfs /dev/md/nfsset/rdsk/d204

Pasos siguientes

Vaya a Configuración de un grupo de dispositivos en el cluster secundario.

Configuración de un grupo de dispositivos en el cluster secundario

Antes de empezar

Complete el procedimiento Configuración de un grupo de dispositivos en el cluster primario.

- Para acceder a nodeC, asuma el rol que proporciona la autorización de RBAC solaris.cluster.modify.

- Cree un metaconjunto para colocar los datos NFS y la replicación asociada.

nodeC# metaset -s nfsset a -h nodeC

- Agregue discos al metaconjunto.

En el siguiente ejemplo, se asume que los números DID del disco son diferentes.

nodeC# metaset -s nfsset -a /dev/did/dsk/d3 /dev/did/dsk/d4

Notas - Los mediadores no son requeridos en un único cluster de nodo. - Cree los volúmenes requeridos (o metadispositivos).

Cree dos componentes de un reflejo:

nodeC# metainit -s nfsset d101 1 1 /dev/did/dsk/d3s2 nodeC# metainit -s nfsset d102 1 1 /dev/did/dsk/d4s2

Cree el reflejo con uno de los componentes:

nodeC# metainit -s nfsset d100 -m d101

Conecte el otro componente al reflejo y deje que se sincronice:

metattach -s nfsset d100 d102

Cree particiones de software a partir del reflejo, siguiendo estos ejemplos:

d200: el volumen maestro de los datos NFS.

nodeC# metainit -s nfsset d200 -p d100 50G

d201: el volumen de copia puntual para los datos NFS.

nodeC# metainit -s nfsset d201 -p d100 50G

d202: el volumen de mapa de bits puntual.

nodeC# metainit -s nfsset d202 -p d100 10M

d203: el volumen de mapa de bits de sombra remoto.

nodeC# metainit -s nfsset d203 -p d100 10M

d204: el volumen para la información de configuración SUNW.NFS de Oracle Solaris Cluster.

nodeC# metainit -s nfsset d204 -p d100 100M

- Cree sistemas de archivos para los datos NFS y el volumen de configuración.

nodeC# yes | newfs /dev/md/nfsset/rdsk/d200 nodeC# yes | newfs /dev/md/nfsset/rdsk/d204

Pasos siguientes

Vaya a Configuración de sistemas de archivos en el cluster primario para la aplicación NFS.

Configuración de sistemas de archivos en el cluster primario para la aplicación NFS

Antes de empezar

Complete el procedimiento Configuración de un grupo de dispositivos en el cluster secundario.

- En nodeA y nodeB, asuma el rol que proporciona la autorización RBAC solaris.cluster.admin.

- En el nodo nodeA y el nodo nodeB, cree un directorio de punto de montaje para el sistema de archivos NFS.

Por ejemplo:

nodeA# mkdir /global/mountpoint

- En nodeA y nodeB, configure el volumen maestro para que no se monte automáticamente en el punto de montaje.

Agregue o sustituya el texto siguiente en el archivo /etc/vfstab del nodo nodeA y el nodo nodeB. El texto debe estar en una sola línea.

/dev/md/nfsset/dsk/d200 /dev/md/nfsset/rdsk/d200 \ /global/mountpoint ufs 3 no global,logging

- En nodeA y nodeB, cree un punto de montaje para el metadispositivo d204.

El ejemplo siguiente crea el punto de montaje /global/etc.

nodeA# mkdir /global/etc

- En nodeA y nodeB, configure el metadispositivo d204 para que se monte automáticamente en el punto de montaje.

Agregue o sustituya el texto siguiente en el archivo /etc/vfstab del nodo nodeA y el nodo nodeB. El texto debe estar en una sola línea.

/dev/md/nfsset/dsk/d204 /dev/md/nfsset/rdsk/d204 \ /global/etc ufs 3 yes global,logging

- Monte el metadispositivo d204 en nodeA.

nodeA# mount /global/etc

- Cree los archivos de configuración y la información para el servicio de datos NFS de Oracle Solaris Cluster HA.

- Cree un directorio denominado /global/etc/SUNW.nfs en nodeA.

nodeA# mkdir -p /global/etc/SUNW.nfs

- Cree el archivo /global/etc/SUNW.nfs/dfstab.nfs-rs en nodeA.

nodeA# touch /global/etc/SUNW.nfs/dfstab.nfs-rs

- Agregue la línea siguiente al archivo /global/etc/SUNW.nfs/dfstab.nfs-rs en nodeA.

share -F nfs -o rw -d "HA NFS" /global/mountpoint

- Cree un directorio denominado /global/etc/SUNW.nfs en nodeA.

Pasos siguientes

Vaya a Configuración del sistema de archivos en el cluster secundario para la aplicación NFS.

Configuración del sistema de archivos en el cluster secundario para la aplicación NFS

Antes de empezar

Complete el procedimiento Configuración de sistemas de archivos en el cluster primario para la aplicación NFS.

- En nodeC, asuma el rol que proporciona la autorización RBAC solaris.cluster.admin.

- En el nodo nodeC, cree un directorio de punto de montaje para el sistema de archivos de NFS.

Por ejemplo:

nodeC# mkdir /global/mountpoint

- En el nodo nodeC, configure el volumen maestro para que se monte automáticamente en el punto de montaje.

Agregue o sustituya el texto siguiente en el archivo /etc/vfstab del nodo nodeC. El texto debe estar en una sola línea.

/dev/md/nfsset/dsk/d200 /dev/md/nfsset/rdsk/d200 \ /global/mountpoint ufs 3 yes global,logging

- Monte el metadispositivo d204 en nodeA.

nodeC# mount /global/etc

- Cree los archivos de configuración y la información para el servicio de datos NFS de Oracle Solaris Cluster HA.

- Cree un directorio denominado /global/etc/SUNW.nfs en nodeA.

nodeC# mkdir -p /global/etc/SUNW.nfs

- Cree el archivo /global/etc/SUNW.nfs/dfstab.nfs-rs en nodeA.

nodeC# touch /global/etc/SUNW.nfs/dfstab.nfs-rs

- Agregue la línea siguiente al archivo /global/etc/SUNW.nfs/dfstab.nfs-rs en nodeA.

share -F nfs -o rw -d "HA NFS" /global/mountpoint

- Cree un directorio denominado /global/etc/SUNW.nfs en nodeA.

Pasos siguientes

Vaya a Creación de un grupo de recursos de replicaciones en el cluster primario.

Creación de un grupo de recursos de replicaciones en el cluster primario

Antes de empezar

Complete el procedimiento Configuración del sistema de archivos en el cluster secundario para la aplicación NFS.

Asegúrese de que el archivo /etc/netmasks tenga las entradas de la máscara de red y la subred de la dirección IP para todos los nombres de host lógicos. Si es necesario, edite el archivo /etc/netmasks para agregar las entradas que faltan.

- Acceda a nodeA con el rol que proporciona las autorizaciones de RBAC solaris.cluster.modify, solaris.cluster.admin y solaris.cluster.read.

- Registre el tipo de recurso SUNW.HAStoragePlus.

nodeA# clresourcetype register SUNW.HAStoragePlus

- Cree un grupo de recursos de replicaciones para el grupo de dispositivos.

nodeA# clresourcegroup create -n nodeA,nodeB devgrp-stor-rg

- -n nodeA,nodeB

Especifica que los nodos del cluster nodeA y nodeB pueden controlar el grupo de recursos de replicaciones.

- devgrp-stor-rg

El nombre del grupo de recursos de replicaciones. En este nombre, devgrp especifica el nombre del grupo de dispositivos.

- Agregue un recurso SUNW.HAStoragePlus al grupo de recursos de replicaciones.

nodeA# clresource create -g devgrp-stor-rg -t SUNW.HAStoragePlus \ -p GlobalDevicePaths=nfsset \ -p AffinityOn=True \ devgrp-stor

- –g

Especifica el grupo de recursos en el que se agrega el recurso.

- -p GlobalDevicePaths=

Especifica el grupo de dispositivos del que depende el software de Sun StorageTek Availability Suite.

- -p AffinityOn=True

Especifica que el recurso SUNW.HAStoragePlus debe realizar un switchover de afinidad para los dispositivos globales y los sistemas de archivos de cluster definidos por -p GlobalDevicePaths=. Por ese motivo, si el grupo de recursos de replicaciones migra tras error o se conmuta, el grupo de dispositivos asociados también se conmuta.

Para obtener más información sobre estas propiedades de extensión, consulte la página del comando man SUNW.HAStoragePlus(5).

- Agregue un recurso de nombre de host lógico al grupo de recursos de replicaciones.

nodeA# clreslogicalhostname create -g devgrp-stor-rg lhost-reprg-prim

El nombre de host lógico para el grupo de recursos de replicaciones en el cluster primario es lhost-reprg-prim.

- Active los recursos, administre el grupo de recursos y póngalo en línea.

nodeA# clresourcegroup online -emM -n nodeA devgrp-stor-rg

- –e

Activa los recursos asociados.

- –M

Administra el grupo de recursos.

- –n

Especifica el nodo en el que poner el grupo de recursos en línea.

- Compruebe que el grupo de recursos esté en línea.

nodeA# clresourcegroup status devgrp-stor-rg

Examine el campo de estado del grupo de recursos para confirmar que el grupo de recursos de replicaciones esté en línea para el nodo nodeA.

Pasos siguientes

Vaya a Creación de un grupo de recursos de replicaciones en el cluster secundario.

Creación de un grupo de recursos de replicaciones en el cluster secundario

Antes de empezar

Complete el procedimiento Creación de un grupo de recursos de replicaciones en el cluster primario.

Asegúrese de que el archivo /etc/netmasks tenga las entradas de la máscara de red y la subred de la dirección IP para todos los nombres de host lógicos. Si es necesario, edite el archivo /etc/netmasks para agregar las entradas que faltan.

- Acceda a nodeC con el rol que proporciona las autorizaciones de RBAC solaris.cluster.modify, solaris.cluster.admin y solaris.cluster.read.

- Registre SUNW.HAStoragePlus como un tipo de recurso.

nodeC# clresourcetype register SUNW.HAStoragePlus

- Cree un grupo de recursos de replicaciones para el grupo de dispositivos.

nodeC# clresourcegroup create -n nodeC devgrp-stor-rg

- create

Crea el grupo de recursos.

- –n

Especifica la lista de nodos para el grupo de recursos.

- devgrp

El nombre del grupo de dispositivos.

- devgrp-stor-rg

El nombre del grupo de recursos de replicaciones.

- Agregue un recurso SUNW.HAStoragePlus al grupo de recursos de replicaciones.

nodeC# clresource create \ -t SUNW.HAStoragePlus \ -p GlobalDevicePaths=nfsset \ -p AffinityOn=True \ devgrp-stor

- create

Crea el recurso.

- –t

Especifica el tipo de recurso.

- -p GlobalDevicePaths=

Especifica el grupo de dispositivos en el que se basa el software Sun StorageTek Availability Suite.

- -p AffinityOn=True

Especifica que el recurso SUNW.HAStoragePlus debe realizar un switchover de afinidad para los dispositivos globales y los sistemas de archivos de cluster definidos por -p GlobalDevicePaths=. Por ese motivo, si el grupo de recursos de replicaciones migra tras error o se conmuta, el grupo de dispositivos asociados también se conmuta.

- devgrp-stor

El recurso de HAStoragePlus para el grupo de recursos de replicaciones.

Para obtener más información sobre estas propiedades de extensión, consulte la página del comando man SUNW.HAStoragePlus(5).

- Agregue un recurso de nombre de host lógico al grupo de recursos de replicaciones.

nodeC# clreslogicalhostname create -g devgrp-stor-rg lhost-reprg-sec

El nombre de host lógico para el grupo de recursos de replicaciones en el cluster secundario es lhost-reprg-sec.

- Active los recursos, administre el grupo de recursos y póngalo en línea.

nodeC# clresourcegroup online -eM -n nodeC devgrp-stor-rg

- online

Lo establece en línea.

- –e

Activa los recursos asociados.

- –M

Administra el grupo de recursos.

- –n

Especifica el nodo en el que poner el grupo de recursos en línea.

- Compruebe que el grupo de recursos esté en línea.

nodeC# clresourcegroup status devgrp-stor-rg

Examine el campo de estado del grupo de recursos para confirmar que el grupo de recursos de replicaciones esté en línea para el nodo nodeC.

Pasos siguientes

Vaya a Creación de un grupo de recursos de aplicaciones NFS en el cluster primario.

Creación de un grupo de recursos de aplicaciones NFS en el cluster primario

Este procedimiento describe la creación de los grupos de recursos de aplicaciones para NFS. Es un procedimiento específico de esta aplicación: no se puede usar para otro tipo de aplicación.

Antes de empezar

Complete el procedimiento Creación de un grupo de recursos de replicaciones en el cluster secundario.

Asegúrese de que el archivo /etc/netmasks tenga las entradas de la máscara de red y la subred de la dirección IP para todos los nombres de host lógicos. Si es necesario, edite el archivo /etc/netmasks para agregar las entradas que faltan.

- Acceda a nodeA con el rol que proporciona las autorizaciones de RBAC solaris.cluster.modify, solaris.cluster.admin y solaris.cluster.read.

-

Registre SUNW.nfs como tipo de recurso.

nodeA# clresourcetype register SUNW.nfs

-

Si SUNW.HAStoragePlus no se registró como un tipo de recurso, hágalo.

nodeA# clresourcetype register SUNW.HAStoragePlus

-

Cree un grupo de recursos de aplicaciones para el servicio NFS.

nodeA# clresourcegroup create \ -p Pathprefix=/global/etc \ -p Auto_start_on_new_cluster=False \ -p RG_affinities=+++devgrp-stor-rg \ nfs-rg

- Pathprefix=/global/etc

-

Especifica el directorio en el que los recursos del grupo pueden guardar los archivos de administración.

- Auto_start_on_new_cluster=False

-

Especifica que el grupo de recursos de aplicaciones no se inicie de forma automática.

- RG_affinities=+++devgrp-stor-rg

-

Especifica el grupo de recursos con el que el grupo de recursos de aplicaciones se debe colocar. En este ejemplo, el grupo de recursos de aplicaciones debe colocarse con el grupo de recursos de replicaciones devgrp-stor-rg.

Si el grupo de recursos de replicaciones se conmuta a un nodo principal nuevo, el grupo de recursos de aplicaciones se conmuta automáticamente. Sin embargo, los intentos de conmutar el grupo de recursos de aplicaciones a un nodo principal nuevo se bloquean porque la acción interrumpe el requisito de colocación.

- nfs-rg

-

El nombre del grupo de recursos de aplicaciones.

-

Agregue un recurso SUNW.HAStoragePlus al grupo de recursos de aplicaciones.

nodeA# clresource create -g nfs-rg \ -t SUNW.HAStoragePlus \ -p FileSystemMountPoints=/global/mountpoint \ -p AffinityOn=True \ nfs-dg-rs

- create

-

Crea el recurso.

- –g

-

Especifica el grupo de recursos en el que se agrega el recurso.

- -t SUNW.HAStoragePlus

-

Especifica que el recurso es del tipo SUNW.HAStoragePlus.

- -p FileSystemMountPoints=/global/punto_montaje

-

Especifica que el punto de montaje del sistema de archivos es global.

- -p AffinityOn=True

-

Especifica que el recurso de aplicaciones debe efectuar una conmutación de afinidad para los dispositivos globales y los sistemas de archivos del cluster definidos por -p FileSystemMountPoints. Por lo tanto, si el grupo de recursos de aplicaciones migra tras error o se conmuta, el grupo de dispositivos asociados también se conmuta.

- nfs-dg-rs

-

El nombre del recurso de HAStoragePlus para la aplicación NFS.

Para obtener más información sobre estas propiedades de extensión, consulte la página del comando man SUNW.HAStoragePlus(5).

-

Agregue un recurso de nombre de host lógico al grupo de recursos de aplicaciones.

nodeA# clreslogicalhostname create -g nfs-rg \ lhost-nfsrg-prim

El nombre de host lógico del grupo de recursos de aplicaciones del cluster primario es lhost-nfsrg-prim.

-

Cree el archivo de configuración dfstab.resource-name y colóquelo en el subdirectorio SUNW.nfs, en el directorio Pathprefix del grupo de recursos que lo contiene.

-

Cree un directorio denominado SUNW.nfs en nodeA.

nodeA# mkdir -p /global/etc/SUNW.nfs

-

Cree un archivo dfstab.resource-name en nodeA.

nodeA# touch /global/etc/SUNW.nfs/dfstab.nfs-rs

-

Agregue la línea siguiente al archivo /global/etc/SUNW.nfs/dfstab.nfs-rs en nodeA.

share -F nfs -o rw -d "HA NFS" /global/mountpoint

-

Cree un directorio denominado SUNW.nfs en nodeA.

-

Establezca en línea el grupo de recursos de aplicaciones.

nodeA# clresourcegroup online -M -n nodeA nfs-rg

- online

-

Pone el grupo de recursos en línea.

- –e

-

Activa los recursos asociados.

- –M

-

Administra el grupo de recursos.

- –n

-

Especifica el nodo en el que poner el grupo de recursos en línea.

- nfs-rg

-

El nombre del grupo de recursos.

-

Compruebe que el grupo de recursos de aplicaciones esté en línea.

nodeA# clresourcegroup status

Examine el campo de estado del grupo de recursos para determinar si el grupo de recursos de aplicaciones está en línea para el nodo nodeA y el nodo nodeB.

Pasos siguientes

Vaya a Creación de un grupo de recursos de aplicaciones NFS en el cluster secundario.

Creación de un grupo de recursos de aplicaciones NFS en el cluster secundario

Antes de empezar

Siga los pasos de Creación de un grupo de recursos de aplicaciones NFS en el cluster primario.

Asegúrese de que el archivo /etc/netmasks tenga las entradas de la máscara de red y la subred de la dirección IP para todos los nombres de host lógicos. Si es necesario, edite el archivo /etc/netmasks para agregar las entradas que faltan.

- Acceda a nodeC con el rol que proporciona las autorizaciones de RBAC solaris.cluster.modify, solaris.cluster.admin y solaris.cluster.read.

- Registre SUNW.nfs como tipo de recurso.

nodeC# clresourcetype register SUNW.nfs

- Si SUNW.HAStoragePlus no se registró como un tipo de recurso, hágalo.

nodeC# clresourcetype register SUNW.HAStoragePlus

- Cree un grupo de recursos de replicaciones para el grupo de dispositivos.

nodeC# clresourcegroup create \ -p Pathprefix=/global/etc \ -p Auto_start_on_new_cluster=False \ -p RG_affinities=+++devgrp-stor-rg \ nfs-rg

- create

Crea el grupo de recursos.

- –p

Especifica una propiedad del grupo de recursos.

- Pathprefix=/global/etc

Especifica un directorio en el que los recursos del grupo pueden guardar los archivos de administración.

- Auto_start_on_new_cluster=False

Especifica que el grupo de recursos de aplicaciones no se inicie de forma automática.

- RG_affinities=+++devgrp-stor-rg

Especifica el grupo de recursos donde el grupo de recursos de aplicaciones debe colocarse. En este ejemplo, el grupo de recursos de aplicaciones debe colocarse con el grupo de recursos de replicaciones devgrp-stor-rg.

Si el grupo de recursos de replicaciones se conmuta a un nodo principal nuevo, el grupo de recursos de aplicaciones se conmuta automáticamente. Sin embargo, los intentos de conmutar el grupo de recursos de aplicaciones a un nodo principal nuevo se bloquean porque la acción interrumpe el requisito de colocación.

- nfs-rg

El nombre del grupo de recursos de aplicaciones.

- Agregue un recurso SUNW.HAStoragePlus al grupo de recursos de aplicaciones.

nodeC# clresource create -g nfs-rg \ -t SUNW.HAStoragePlus \ -p FileSystemMountPoints=/global/mountpoint \ -p AffinityOn=True \ nfs-dg-rs

- create

Crea el recurso.

- –g

Especifica el grupo de recursos en el que se agrega el recurso.

- -t SUNW.HAStoragePlus

Especifica que el recurso es del tipo SUNW.HAStoragePlus.

- –p

Especifica una propiedad del recurso.

- FileSystemMountPoints=/global/mountpoint

Especifica que el punto de montaje del sistema de archivos es global.

- AffinityOn=True

Especifica que el recurso de aplicaciones debe efectuar una conmutación de afinidad para los dispositivos globales y los sistemas de archivos del cluster definidos por -p FileSystemMountPoints=. Por lo tanto, si el grupo de recursos de aplicaciones migra tras error o se conmuta, el grupo de dispositivos asociados también se conmuta.

- nfs-dg-rs

El nombre del recurso de HAStoragePlus para la aplicación NFS.

- Agregue un recurso de nombre de host lógico al grupo de recursos de aplicaciones.

nodeC# clreslogicalhostname create -g nfs-rg \ lhost-nfsrg-sec

El nombre de host lógico del grupo de recursos de aplicaciones del cluster secundario es lhost-nfsrg-sec.

- Agregue un recurso de NSF al grupo de recursos de aplicaciones.

nodeC# clresource create -g nfs-rg \ -t SUNW.nfs -p Resource_dependencies=nfs-dg-rs nfs-rg

- Si el volumen global se monta en el cluster primario, desmonte el volumen

global del cluster secundario.

nodeC# umount /global/mountpoint

Si el volumen está montado en un cluster secundario, se da un error de sincronización.

Pasos siguientes

Vaya a Ejemplo de cómo activar la replicación de datos.

Ejemplo de cómo activar la replicación de datos

Esta sección describe cómo activar la replicación de datos en la configuración de ejemplo. Esta sección utiliza los comandos sndradm e iiadm del software de Sun StorageTek Availability Suite. Si desea más información sobre estos comandos, consulte la documentación de. Sun StorageTek Availability Suite

Esta sección incluye los procedimientos siguientes:

Activación de la replicación en el cluster primario

- Acceda a nodeA con el rol que proporciona la autorización de RBAC solaris.cluster.modify.

- Vacíe todas las transacciones.

nodeA# lockfs -a -f

- Compruebe que los nombres de host lógicos lhost-reprg-prim y lhost-reprg-sec estén en línea.

nodeA# clresourcegroup status nodeC# clresourcegroup status

Examine el campo de estado del grupo de recursos.

- Active la duplicación por duplicación remota del cluster primario al secundario.

Este paso permite realizar la replicación del cluster principal al secundario. Este paso permite realizar la replicación del volumen maestro (d200) en el cluster principal al volumen maestro (d200) en el cluster secundario. Además, este paso permite la replicación en el mapa de bits de reflejo remoto de d203.

Si los clusters primario y secundario no están sincronizados, ejecute este comando para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -n -e lhost-reprg-prim \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 lhost-reprg-sec \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 ip sync

Si el cluster primario y el secundario están sincronizados, ejecute este comando para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -n -E lhost-reprg-prim \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 lhost-reprg-sec \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 ip sync

- Active la sincronización automática.

Ejecute este comando para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -n -a on lhost-reprg-prim \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 lhost-reprg-sec \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 ip sync

Este paso activa la sincronización automática. Si el estado activo de la sincronización automática es on, los conjuntos de volúmenes se vuelven a sincronizar cuando el sistema reinicie o cuando haya un error.

- Compruebe que el cluster esté en modo de registro.

Utilice el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -P

La salida debe ser similar a la siguiente:

/dev/md/nfsset/rdsk/d200 -> lhost-reprg-sec:/dev/md/nfsset/rdsk/d200 autosync: off, max q writes:4194304, max q fbas:16384, mode:sync,ctag: devgrp, state: logging

En modo de registro, el estado es logging y el estado activo de la sincronización automática es off. Cuando se escribe el volumen de datos en el disco, se actualiza el archivo de mapa de bits en el mismo disco.

- Active la instantánea de un momento determinado.

Utilice el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/iiadm -e ind \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d201 \ /dev/md/nfsset/rdsk/d202 nodeA# /usr/sbin/iiadm -w \ /dev/md/nfsset/rdsk/d201

Este paso activa la copia del volumen maestro del cluster primario en el volumen sombra del mismo cluster. El volumen maestro, el volumen sombra y el volumen de mapa de bits de un momento determinado deben estar en el mismo grupo de dispositivos. En este ejemplo, el volumen maestro es d200, el volumen shadow es d201 y el volumen de mapa de bits de un momento determinado es d203.

- Vincule la instantánea de un momento determinado con el grupo de duplicación remota.

Utilice el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -I a \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d201 \ /dev/md/nfsset/rdsk/d202

Este paso asocia la instantánea de un momento determinado con el conjunto duplicado remoto de volúmenes. El software Sun StorageTek Availability Suite comprueba que se tome una instantánea de un momento determinado antes de que pueda haber una replicación por duplicación remota.

Pasos siguientes

Vaya a Activación de la replicación en el cluster secundario.

Activación de la replicación en el cluster secundario

Antes de empezar

Complete el procedimiento Activación de la replicación en el cluster primario.

- Acceda a nodeC como el rol root.

- Vacíe todas las transacciones.

nodeC# lockfs -a -f

- Active la duplicación por duplicación remota del cluster primario al secundario.

Utilice el comando siguiente para el software Sun StorageTek Availability Suite:

nodeC# /usr/sbin/sndradm -n -e lhost-reprg-prim \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 lhost-reprg-sec \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 ip sync

El cluster primario detecta la presencia del cluster secundario y comienza la sincronización. Si desea información sobre el estado de los clusters, consulte el archivo de registro del sistema /var/adm de Sun StorageTek Availability Suite.

- Active la instantánea de un momento determinado independiente.

Utilice el comando siguiente para el software Sun StorageTek Availability Suite:

nodeC# /usr/sbin/iiadm -e ind \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d201 \ /dev/md/nfsset/rdsk/d202 nodeC# /usr/sbin/iiadm -w \ /dev/md/nfsset/rdsk/d201

- Vincule la instantánea de un momento determinado con el grupo de duplicación remota.

Utilice el comando siguiente para el software Sun StorageTek Availability Suite:

nodeC# /usr/sbin/sndradm -I a \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d201 \ /dev/md/nfsset/rdsk/d202

Pasos siguientes

Vaya a Ejemplo de cómo efectuar una replicación de datos.

Ejemplo de cómo efectuar una replicación de datos

Esta sección describe la ejecución de la replicación de datos en la configuración de ejemplo. Esta sección utiliza los comandos sndradm e iiadm del software de Sun StorageTek Availability Suite. Si desea más información sobre estos comandos, consulte la documentación de. Sun StorageTek Availability Suite

Procedimiento para comprobar la configuración de la replicación

Esta sección incluye los procedimientos siguientes:

Replicación por duplicación remota

En este procedimiento, el volumen maestro del disco primario se replica en el volumen maestro del disco secundario. El volumen maestro es d200 y el volumen del mapa de bits de reflejo remoto es d203.

- Acceda a nodeA como el rol root.

- Compruebe que el cluster esté en modo de registro.

Ejecute el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -P

La salida debe ser similar a la siguiente:

/dev/md/nfsset/rdsk/d200 -> lhost-reprg-sec:/dev/md/nfsset/rdsk/d200 autosync: off, max q writes:4194304, max q fbas:16384, mode:sync,ctag: devgrp, state: logging

En modo de registro, el estado es logging y el estado activo de la sincronización automática es off. Cuando se escribe el volumen de datos en el disco, se actualiza el archivo de mapa de bits en el mismo disco.

- Vacíe todas las transacciones.

nodeA# lockfs -a -f

- Repita los pasos del Step 1 al Step 3 en el nodo nodeC.

- Copie el volumen principal del nodo nodeA en el volumen principal del nodo nodeC.

Ejecute el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -n -m lhost-reprg-prim \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 lhost-reprg-sec \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 ip sync

- Espere hasta que la termine replicación y los volúmenes se sincronicen.

Ejecute el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -n -w lhost-reprg-prim \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 lhost-reprg-sec \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 ip sync

- Confirme que el cluster esté en modo de replicación.

Ejecute el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -P

La salida debe ser similar a la siguiente:

/dev/md/nfsset/rdsk/d200 -> lhost-reprg-sec:/dev/md/nfsset/rdsk/d200 autosync: on, max q writes:4194304, max q fbas:16384, mode:sync,ctag: devgrp, state: replicating

En modo de replicación, el estado es logging y el estado activo de la sincronización automática es off. Cuando se escribe en el volumen principal, el software Sun StorageTek Availability Suite, actualiza el volumen secundario.

Pasos siguientes

Vaya a Instantánea de un momento determinado.

Instantánea de un momento determinado

En este procedimiento, la instantánea de un momento determinado se ha utilizado para sincronizar el volumen sombra del cluster primario con el volumen maestro del cluster primario. El volumen maestro es d200, el volumen de mapa de bits es d203 y el volumen shadow es d201.

Antes de empezar

Realice el procedimiento Replicación por duplicación remota.

- Acceda a nodeA con el rol que proporciona las autorizaciones de RBAC solaris.cluster.modify y solaris.cluster.admin.

- Desactive el recurso que se esté ejecutando en nodeA.

nodeA# clresource disable nfs-rs

- Cambie el cluster primario a modo de registro.

Ejecute el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -n -l lhost-reprg-prim \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 lhost-reprg-sec \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 ip sync

Cuando se escribe el volumen de datos en el disco, se actualiza el archivo de mapa de bits en el mismo disco. No se produce ninguna replicación.

- Sincronice el volumen sombra del cluster primario con el volumen maestro del cluster primario.

Ejecute el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/iiadm -u s /dev/md/nfsset/rdsk/d201 nodeA# /usr/sbin/iiadm -w /dev/md/nfsset/rdsk/d201

- Sincronice el volumen sombra del cluster secundario con el volumen maestro del cluster secundario.

Ejecute el comando siguiente para el software Sun StorageTek Availability Suite:

nodeC# /usr/sbin/iiadm -u s /dev/md/nfsset/rdsk/d201 nodeC# /usr/sbin/iiadm -w /dev/md/nfsset/rdsk/d201

- Reinicie la aplicación en el nodo nodeA.

nodeA# clresource enable nfs-rs

- Vuelva a sincronizar el volumen secundario con el volumen principal.

Ejecute el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -n -u lhost-reprg-prim \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 lhost-reprg-sec \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 ip sync

Pasos siguientes

Vaya a Procedimiento para comprobar la configuración de la replicación.

Procedimiento para comprobar la configuración de la replicación

Antes de empezar

Complete el procedimiento Instantánea de un momento determinado.

- Acceda a nodeA y nodeC con el rol que proporciona la autorización de RBAC solaris.cluster.admin.

- Compruebe que el cluster primario esté en modo de replicación, con la

sincronización automática activada.

Utilice el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -P

La salida debe ser similar a la siguiente:

/dev/md/nfsset/rdsk/d200 -> lhost-reprg-sec:/dev/md/nfsset/rdsk/d200 autosync: on, max q writes:4194304, max q fbas:16384, mode:sync,ctag: devgrp, state: replicating

En modo de replicación, el estado es logging y el estado activo de la sincronización automática es off. Cuando se escribe en el volumen principal, el software Sun StorageTek Availability Suite, actualiza el volumen secundario.

- Si el cluster primario no está en modo de replicación, póngalo en ese modo.

Utilice el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -n -u lhost-reprg-prim \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 lhost-reprg-sec \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 ip sync

- Cree un directorio en un equipo cliente.

- Monte el volumen principal en el directorio de aplicaciones y visualice el directorio montado.

- Desmonte el volumen principal del directorio de aplicaciones.

- Desmonte el volumen principal del directorio de aplicaciones.

client-machine# umount /dir

- Ponga el grupo de recursos de aplicaciones fuera de línea en el cluster primario.

nodeA# clresource disable -g nfs-rg + nodeA# clresourcegroup offline nfs-rg

- Cambie el cluster primario a modo de registro.

Ejecute el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -n -l lhost-reprg-prim \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 lhost-reprg-sec \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 ip sync

Cuando se escribe el volumen de datos en el disco, se actualiza el archivo de mapa de bits en el mismo disco. No se produce ninguna replicación.

- Asegúrese de que el directorio PathPrefix esté disponible.

nodeC# mount | grep /global/etc

- Confirme que el sistema de archivos se adecue para ser montado en el cluster secundario.

nodeC# fsck -y /dev/md/nfsset/rdsk/d200

- Establezca la aplicación en el estado gestionado y establézcala en línea en el cluster secundario.

nodeC# clresourcegroup online -eM nodeC nfs-rg

- Acceda a la máquina cliente como rol root.

Verá un indicador con un aspecto similar al siguiente:

client-machine#

- Monte el directorio de aplicaciones creado en el Step 4 para el directorio de aplicaciones en el volumen secundario.

client-machine# mount -o rw lhost-nfsrg-sec:/global/mountpoint /dir

- Visualice el directorio montado.

client-machine# ls /dir

- Desmonte el volumen principal del directorio de aplicaciones.

- Compruebe que el directorio mostrado en el Step 5 sea el mismo del Step 6.

- Devuelva la aplicación del volumen principal al directorio de aplicaciones montado.

- Establezca sin conexión el grupo de recursos de aplicaciones en el volumen secundario.

nodeC# clresource disable -g nfs-rg + nodeC# clresourcegroup offline nfs-rg

- Asegúrese de que el volumen global se desmonte del volumen secundario.

nodeC# umount /global/mountpoint

- Establezca el grupo de recursos de aplicaciones en estado gestionado y establézcalo en línea en el cluster principal.

nodeA# clresourcegroup online -eM nodeA nfs-rg

- Cambie el volumen principal al modo de replicación.

Ejecute el comando siguiente para el software Sun StorageTek Availability Suite:

nodeA# /usr/sbin/sndradm -n -u lhost-reprg-prim \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 lhost-reprg-sec \ /dev/md/nfsset/rdsk/d200 \ /dev/md/nfsset/rdsk/d203 ip sync

Cuando se escribe en el volumen principal, el software Sun StorageTek Availability Suite, actualiza el volumen secundario.

- Establezca sin conexión el grupo de recursos de aplicaciones en el volumen secundario.

Véase también

Ejemplo de cómo gestionar una recuperación

Ejemplo de cómo gestionar una recuperación

En esta sección, se describe cómo actualizar las entradas DNS. Para obtener más información, consulte Directrices para la gestión de una recuperación.

En esta sección, se incluye el siguiente procedimiento:

Actualización de la entrada de DNS

Si desea una ilustración de cómo asigna el DNS un cliente a un cluster, consulte la Figure A–6.

- Inicie el comando nsupdate.

Para obtener más información, consulte la página del comando man nsupdate(1M).

- Elimine en ambos clusters la asignación de DNS actual entre el nombre de host lógico del grupo de recursos de aplicaciones y la dirección IP del cluster.

> update delete lhost-nfsrg-prim A > update delete lhost-nfsrg-sec A > update delete ipaddress1rev.in-addr.arpa ttl PTR lhost-nfsrg-prim > update delete ipaddress2rev.in-addr.arpa ttl PTR lhost-nfsrg-sec

- ipaddress1rev

Dirección IP del cluster primario en orden inverso.

- ipaddress2rev

Dirección IP del cluster secundario en orden inverso.

- ttl

Tiempo de vida, en segundos. Un valor normal es 3600.

- Cree la nueva asignación de DNS entre el nombre de host lógico del grupo de recursos de aplicaciones y la dirección IP del cluster en ambos clusters.

Asigne el nombre de host lógico principal a la dirección IP del cluster secundario y el nombre sistema lógico secundario a la dirección IP del cluster primario.

> update add lhost-nfsrg-prim ttl A ipaddress2fwd > update add lhost-nfsrg-sec ttl A ipaddress1fwd > update add ipaddress2rev.in-addr.arpa ttl PTR lhost-nfsrg-prim > update add ipaddress1rev.in-addr.arpa ttl PTR lhost-nfsrg-sec

- ipaddress2fwd

Dirección IP del cluster secundario hacia delante.

- ipaddress1fwd

Dirección IP del cluster primario hacia delante.