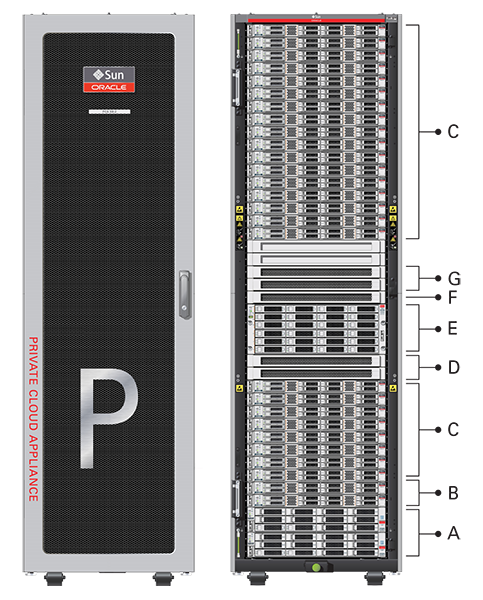

出荷時に設置されたコントローラ・ソフトウェア・リリース2.4.xを含む現在のOracle Private Cloud Applianceハードウェア・プラットフォームは、「図1.1」に識別されたハードウェア・コンポーネントが移入されたOracle Rackキャビネット1242ベースで構成されます。 ハードウェア・コンポーネントの前の世代は、次のように、最新のコントローラ・ソフトウェアで引き続きサポートされます。

表1.1 図の説明

項目 | 数量 | 説明 |

|---|---|---|

A | 2 | Oracle ZFS Storage Appliance ZS7-2コントローラ・サーバー |

B | 2 | 管理ノードとして使用されるOracle Server X8-2 |

C | 2-25 | 仮想化コンピュート・ノードとして使用されるOracle Server X8-2 (アプライアンスに22kVA PDUが装備されている場合、Oracle Server X8-2の電源要件により、コンピュート・ノードの最大数は22です。 15KVAを使用するPDUの最大コンピュート・ノード数は13コンピュート・ノードです。) |

D | 2 | Cisco Nexus 9336C-FX2 Switch(リーフ/データ・スイッチとして使用) |

E | 1 | Oracle ZFS Storage Appliance ZS7-2ディスク・シェルフ |

F | 1 | Cisco Nexus 9348GC-FXPスイッチ |

G | 2 | スパイン・スイッチとして使用されるCisco Nexus 9336C-FX2スイッチ |

ハードウェア・コンポーネントの以前の世代のサポート

Oracle Private Cloud Appliance Controllerソフトウェアの最新バージョンでは、以前のハードウェア・プラットフォームの構成がすべて引き続きサポートされます。 これには次のコンポーネントが含まれる場合があります。

表1.2 サポートされるハードウェア

コンポーネント・タイプ | コンポーネント名および最小ソフトウェア・バージョン |

|---|---|

管理ノード |

|

コンピュート・ノード |

|

ストレージ・アプライアンス |

|

InfiniBandネットワーク・ハードウェア |

|

内部管理スイッチ |

|

各Oracle Private Cloud Applianceのインストールの中心は、管理ノードのペアです。 これらはラック・ユニット5および6にインストールされ、高可用性のためのアクティブ/スタンバイ構成でクラスタを形成します: どちらのサーバーも同じサービスを実行でき、システム構成に同等のアクセス権を持ちますが、もう一方は障害が発生した場合にマスター関数を引き継ぐ準備がマスターとして機能します。 マスター管理ノードは必要なサービスのすべてを実行しますが、スタンバイ管理ノードは、マスター・ロールに昇格されるまでサービスのサブセットを実行します。 マスター・ロールは、iSCSI LUN上でOCFS 2分散ロック管理を介してブートされます。これは両方の管理ノードがラック内にインストールされたZFS Storage Appliance上で共有します。 ラック・ユニットは上から下へと番号が付けられ、下の4つはZFS Storage Applianceのコンポーネントによって占有されるため、通常、マスター管理ノードはラック・ユニット5のサーバーです。 アプライアンスをオンラインにするには、プロセス全体で管理者によって電源が投入される必要がある唯一のサーバーです。

Oracle Private Cloud Applianceで高可用性が実現される仕組みの詳細は、第1.5項、「高可用性」を参照してください。

Oracle Private Cloud Applianceに初めて電源を投入すると、データ・センターのネットワークから簡単に到達できるように、管理ノード・クラスタのファクトリ出荷時のデフォルトIP構成を変更できます。 管理ノードは仮想IPを共有し、管理webインタフェースにアクセスできます。 この仮想IPは、任意の時点でmasterロールを持つサーバーに割り当てられます。 システムの初期化中、管理クラスタが正常に設定されると、Oracle VMおよびそれに関連付けられたMySQLデータベースに加え、マスター管理ノードは多数のOracle Linuxサービスをロードします。 - network、sshd、ntpd、iscsiイニシエータ、dhcpdを含む - すべてのシステム・コンポーネントのプロビジョニングを編成します。 プロビジョニング時には、すべてのネットワークおよびストレージが構成され、すべてのコンピュート・ノードが検出およびインストールされてOracle VMサーバー・プールに追加されます。 すべてのプロビジョニング構成はファクトリで事前ロードされるため、顧客が変更することはできません。

プロビジョニング・プロセスの詳細は、第1.4項、「プロビジョニングおよびオーケストレーション」を参照してください。

仮想化プラットフォームは、Oracle Private Cloud Appliance内のコンピュート・ノードによって構成されます。 コンピュート・ノードでは、ホストする仮想サーバーの処理能力とメモリー容量が提供されます。 プロビジョニング・プロセス全体が管理ノードによってオーケストレーションされます: コンピュート・ノードは、Oracle VM Server 3.4.xおよびSoftware Defined Networkingの追加パッケージとともにインストールされます。 プロビジョニングが完了すると、Oracle Private Cloud Appliance Controllerソフトウェアは、同じラックのすべてのコンピュート・ノードが同じOracle VMサーバー・プールの一部であることを想定します。

コンピュート・ノードのハードウェア構成の詳細は、Oracle Private Cloud Applianceインストレーション・ガイドの「サーバー・コンポーネント」を参照してください。

Oracle Private Cloud ApplianceのDashboardを使用すると、管理者はコンピュート・ノードのヘルスとステータス、およびその他のすべてのラック・コンポーネントを監視し、特定のシステム操作を実行できます。 仮想インフラストラクチャはOracle VM Managerで構成および管理されます。

Oracle Private Cloud Applianceでは、ビジネス・ニーズに従って増加できるモジュラ・コンピュート能力を提供しています。 基本ラックの最小構成には2つのコンピュート・ノードのみが含まれますが、コンピュート・ノードの最大25個の時点で1つのノードによって拡張できます。 ハードウェアの設置以外に、コンピュート・ノードを追加する場合、管理者による操作は必要ありません。 新しいノードは、マスター管理ノードによって自動的に検出、電源投入およびプロビジョニングされます。 追加のコンピュート・ノードは既存の構成に統合されているため、Oracle VMサーバー・プールはより多くの仮想マシンの容量の増加を提供します。

さらなる拡張オプションとして、Oracle Server X8-2のコンピュート・ノードは、設置後に事前に取り付けられたファイバ・チャネル・カードにオーダーしたり、ファイバ・チャネル・カードを装備したりできます。 これらのコンピュート・ノードがOracle Private Cloud Appliance環境に統合されると、ファイバ・チャネルHBAはデータセンター内の標準のFCスイッチおよびストレージ・ハードウェアに接続できます。 外部FCストレージ構成は、Oracle VM Managerを介して管理されます。 詳細は、「Oracle VM概要ガイド」の「ネットワークにアタッチされたファイバ・チャネル・ストレージ」に関する項を参照してください。

InfiniBandベースのネットワーク・アーキテクチャを備えたシステム内のファイバ・チャネル・カードが含まれる拡張ノードを使用する場合は、これらのコンピュート・ノードでvHBAsを無効にする必要があります。

仮想化シナリオの多様性により、コンピュート容量をいくつかの仮想マシンとして定量化することは困難です。 サイズ設定のガイドラインについては、「Oracle Private Cloud Applianceリリース・ノート」で「構成最大値」に適用される章を参照してください。

Oracle Private Cloud Appliance Controllerソフトウェアは、引き続き、ベース・ラックにインストールされたZFS Storage Applianceの以前の世代をサポートします。 ただし、Oracle ZFS Storage Appliance ZS7-2には、Ethernetベースのネットワーク・アーキテクチャを持つシステムの一部である機能的な相違点と、InfiniBandベースのネットワーク・アーキテクチャを持つシステムの一部であるZFS Storage Applianceの以前のモデルとの間に機能的な相違点があります。 わかりやすいように、この項では、様々なストレージ・アプライアンスについて別々に説明します。

Oracle ZFS Storage Appliance ZS7-2は、アプライアンス・ラックの下部に取り付けられた2つのコントローラ・サーバーと、途中のディスク・シェルフで構成され、アプライアンス全体に対してシステム・ディスクのロールを果たします。 Oracle Private Cloud Applianceソフトウェア用のストレージ領域を提供することが重要です。

ディスク領域の一部。デフォルトでは3 Tbが顧客の使用が可能になり、いくつかの仮想マシン、テンプレートおよびアセンブリがあるOracle VMストレージ・リポジトリに十分です。 合計ディスク領域の残りの約100TBの部分も、仮想マシン・リソースのストレージ・リポジトリとして構成できます。 外部ストレージとの追加の容量拡張も可能です。

Oracle ZFS Storage Appliance ZS7-2のハードウェア構成は、次のとおりです。

2つのクラスタ化されたストレージ・ヘッドと、それぞれ14TBハードディスク

ディスクのシャーシに14TBのハード・ディスクで完全に装着されている

ディスク・シェルフに取り付けられている4つのキャッシュ・ディスク: 2x 200GB SSDおよび2x 7.68TB SSD

RAID-1最適なデータ保護用の構成、使用可能な合計領域は約100TB

ストレージ・アプライアンスは、管理サブネット(192.168.4.0/24)およびストレージ・サブネット(192.168.40.0/24)に接続されています。 どちらのヘッドもアクティブ/パッシブ構成では、1つのストレージ・ヘッドで障害が発生した場合のサービスの継続を保証するためにクラスタを形成します。 ストレージ・ヘッドは、ストレージ・サブネット内の単一のIPを共有しますが、両方に簡単なメンテナンス・アクセス用の個々の管理IPアドレスがあります。 RAID-1ストレージ・プールには、OVCAおよびOVMという名前の2つのプロジェクトが含まれています。

OVCAプロジェクトには、Oracle Private Cloud Applianceソフトウェアが使用するすべてのLUNとファイルシステムが含まれます。

LUN

Locks(12GB) - 2つの管理ノード上のクラスタのロックに排他的に使用されます。Manager(200GB) - 両方の管理ノード上の追加ファイル・システムとして排他的に使用

ファイルシステム:

MGMT_ROOT- Oracle Private Cloud Applianceに固有のすべてのファイルのストレージで使用されますDatabase- データベースのプレースホルダー・ファイル・システムIncoming(20GB) - FTPファイル転送に使用するもの(主にOracle Private Cloud Applianceコンポーネントのバックアップ用)Templates- 将来使用するためのプレースホルダー・ファイル・システムUser- 将来使用するためのプレースホルダー・ファイル・システムYum- システム・パッケージの更新に使用

OVMプロジェクトには、Oracle VMで使用されるすべてのLUNとファイルシステムが含まれます。

LUN

iscsi_repository1(3TB) - Oracle VMストレージ・リポジトリとして使用されますiscsi_serverpool1(12GB) - Oracle VMクラスタ化サーバー・プール用のサーバー・プール・ファイル・システムとして使用されます

ファイルシステム:

nfs_repository1(3TB) -kdumpで使用され、顧客が使用することはできませんnfs_serverpool1(12GB) - NFSがiSCSIより優先される場合に、Oracle VMクラスタ化サーバー・プールのサーバー・プール・ファイル・システムとして使用されます

内部ZFS Storage Applianceに顧客作成のLUNが含まれている場合は、それらがデフォルトのイニシエータ・グループにマップされていないことを確認してください。 Oracle Private Cloud Applianceリリース・ノートの「顧客が作成したLUNが間違ったイニシエータ・グループにマップされます」に関する項を参照してください。

ZFS記憶域アプライアンスは、ストレージを提供するのみでなく、xinetdおよびtftpdサービスも実行します。 これらは、すべてのOracle Private Cloud Applianceシステム・コンポーネントのプロビジョニングを編成するために、マスター管理ノード上のOracle Linuxサービスを補完します。

アプライアンス・ラックの下部に取り付けられたOracle ZFS Storage Appliance ZS5-ESは、アプライアンス全体のシステム・ディスクと見なす必要があります。 その主な目的は、Oracle Private Cloud Applianceソフトウェアのストレージ領域を提供することです。 ディスク領域の一部がカスタマの使用可能になり、制限された数の仮想マシン、テンプレートおよびアセンブリを使用するOracle VMストレージ・リポジトリに十分です。

Oracle ZFS Storage Appliance ZS5-ESのハードウェア構成は次のとおりです。

2つのクラスタ化されたストレージ・ヘッド(それぞれ2つの3.2TB SSDがあり、キャッシュ専用に使用される)

1.2TB 10000 RPM SASハード・ディスクがすべて装着されたディスク・シャーシ1つ

RAID-Z2構成(パフォーマンスとデータ保護の最適なバランス用)および使用可能な合計容量(約15TB)

ソフトウェア・リリース2.3.3より前に出荷されたOracle Private Cloud Appliance基本ラックでは、Sun ZFS Storage Appliance 7320またはOracle ZFS Storage Appliance ZS3-ESを使用します。 これらのシステムを新しいソフトウェア・スタックにアップグレードすると、Oracle Private Cloud Applianceの各ストレージ構成を引き続きサポートします。 新しいストレージ・アプライアンスには、モデル化されたハードウェアと同じ機能と構成が提供されるため、パフォーマンスが向上します。

記憶域アプライアンスは、管理サブネット(192.168.4.0/24)およびInfiniBand (IPoIB)ストレージ・サブネット(192.168.40.0/24)に接続されています。 どちらのヘッドもアクティブ/パッシブ構成では、1つのストレージ・ヘッドで障害が発生した場合のサービスの継続を保証するためにクラスタを形成します。 ストレージ・ヘッドは、ストレージ・サブネット内の単一のIPを共有しますが、両方に簡単なメンテナンス・アクセス用の個々の管理IPアドレスがあります。 RAID-Z2ストレージ・プールには、OVCAおよびOVMという名前の2つのプロジェクトが含まれています。

OVCAプロジェクトには、Oracle Private Cloud Applianceソフトウェアが使用するすべてのLUNとファイルシステムが含まれます。

LUN

Locks(12GB) - 2つの管理ノード上のクラスタのロックに排他的に使用されます。Manager(200GB) - 両方の管理ノード上の追加ファイル・システムとして排他的に使用

ファイルシステム:

MGMT_ROOT- Oracle Private Cloud Applianceに固有のすべてのファイルのストレージで使用されますDatabase- データベースのプレースホルダー・ファイル・システムIncoming(20GB) - FTPファイル転送に使用するもの(主にOracle Private Cloud Applianceコンポーネントのバックアップ用)Templates- 将来使用するためのプレースホルダー・ファイル・システムUser- 将来使用するためのプレースホルダー・ファイル・システムYum- システム・パッケージの更新に使用

OVMプロジェクトには、Oracle VMで使用されるすべてのLUNとファイルシステムが含まれます。

LUN

iscsi_repository1(300GB) - Oracle VMストレージ・リポジトリとして使用されますiscsi_serverpool1(12GB) - Oracle VMクラスタ化サーバー・プール用のサーバー・プール・ファイル・システムとして使用されます

ファイルシステム:

nfs_repository1(300GB) - NFSがiSCSIより優先されている場合にOracle VMストレージ・リポジトリとして使用するnfs_serverpool1(12GB) - NFSがiSCSIより優先される場合に、Oracle VMクラスタ化サーバー・プールのサーバー・プール・ファイル・システムとして使用されます

内部ZFS Storage Applianceに顧客作成のLUNが含まれている場合は、それらがデフォルトのイニシエータ・グループにマップされていないことを確認してください。 Oracle Private Cloud Applianceリリース・ノートの「顧客が作成したLUNが間違ったイニシエータ・グループにマップされます」に関する項を参照してください。

ZFS記憶域アプライアンスは、ストレージを提供するのみでなく、xinetdおよびtftpdサービスも実行します。 これらは、すべてのOracle Private Cloud Applianceシステム・コンポーネントのプロビジョニングを編成するために、マスター管理ノード上のOracle Linuxサービスを補完します。

ネットワーク接続の場合、Oracle Private Cloud Applianceは必要な高可用性、帯域幅および速度を提供する物理レイヤーに依存します。 この上で、様々なタイプのデータ・トラフィックに対応するように、いくつかの異なる仮想ネットワークが最適に構成されます。 内部管理ネットワークのみが物理的なものであり、アプライアンス・データ接続はソフトウェア定義ネットワーク(SDN)を使用します。 アプライアンス・ラックには、障害が発生した場合のサービスの継続性を保証するためにファクトリで事前に有効化されている、冗長なネットワーク・ハードウェア・コンポーネントが含まれています。

アプライアンスの正確なハードウェア構成に応じて、物理ネットワーク層は高速EthernetまたはInfiniBandのいずれかになります。 この項では、両方のネットワーク・アーキテクチャについて詳しく説明します。

Ethernetベース・ネットワーク・アーキテクチャを備えたOracle Private Cloud Applianceは、冗長な物理的高速Ethernet接続に依存しています。

管理ネットワーク

管理ネットワークは、すべてのアプライアンス・コンポーネントの管理インタフェースへの内部アクセスを提供します。 これらには、Cisco Nexus 9348GC-FXPスイッチへのEthernet接続があり、すべて192.168.4.0/24範囲で事前定義済のIPアドレスがあります。 また、すべての管理ノードおよびコンピュート・ノードのIPアドレスは、この範囲でOracle Integrated Lights Out Manager (ILOM)接続に使用される2つ目のIPアドレスを持っています。

アプライアンスの初期化中は、データ・ネットワークにアクセスできません。つまり、内部管理ネットワークはシステムに接続するための唯一の一時的な方法です。 したがって、管理者は、Cisco Nexus 9348GC-FXPスイッチで予約済Ethernetポート48にワークステーションを接続し、固定IPアドレス192.168.4.254をワークステーションに割り当てる必要があります。 このワークステーションから、管理者は、https://192.168.4.216のマスター管理ノード上のwebサーバーへのブラウザ接続を開き、初期化プロセスをモニターして、アプライアンスの電源を初めて投入したときに初期構成ステップを実行します。

データ・ネットワーク

アプライアンス・データ接続は、リーフのスパイン・スイッチの冗長Cisco Nexus 9336C-FX2スイッチ上に組み込まれています。 この2レイヤーの設計では、リーフ・スイッチはラック・ハードウェア・コンポーネントを相互接続し、スパイン・スイッチはネットワークのバック結合を形成し、ルーティング・タスクを実行します。 各リーフ・スイッチは、相互に接続されているすべてのスパイン・スイッチに接続されます。 このネットワーク・アーキテクチャの主な利点は、拡張性とパスの最適化です。 Oracle Private Cloud Applianceラックには、2つのリーフ・スイッチと2つのスパイン・スイッチが含まれます。

Cisco Nexus 9336C-FX2 Switchでは、1ポート当たり最大スループットは100Gbitです。 スパイン・スイッチでは5つのインター・リンク(500Gbit)が使用され、リーフ・スイッチでは2つのインター・リンク(200Gビット)と2x2のクロス・リンクがスピンに使用されます。 各コンピュート・ノードは、リンク集計モードの2つの100Gbit Ethernetポートで構成されるbond1インタフェースを介して、ラック内の両方のリーフ・スイッチに接続されます。 2つのストレージ・コントローラは、4x40Gbit接続を使用してスパイン・スイッチに接続されています。

外部接続の場合、各スパイン・スイッチに5つのポートが予約されます。 カスタム・ネットワーク構成には4つのポートを使用できます。デフォルトのアップリンクには1つのポートが必要です。 この「デフォルト外部アップリンク」では、両方のスパイン・スイッチのポート5がQSFP+-to-SFP+ 4方向のスプリッタまたはブレークアウト・ケーブルを使用して分割されている必要があります。 スパイン・スイッチの4つの10GbE SFP+ブレークアウト・ポート、ポート5/1および5/2の2つは、ラックの上位またはToRスイッチとも呼ばれる次レベルのデータ・センター・スイッチのペアに接続されている必要があります。

ソフトウェア定義ネットワーク

前述の物理データ・ネットワークではデータ・パケットの転送が可能ですが、実際の接続はソフトウェア定義ネットワーク(SDN)を介して実装されます。 VxLANのカプセル化とVLANのタグ付けを使用して、数千の仮想ネットワークをデプロイして、分離されたデータ交換を提供できます。 トラフィックは、アプライアンス環境内のリソース間、または外部へのネットワーク・ストレージ、アプリケーション、またはデータセンターやインターネット上のその他のリソースに対する外部リソースとなります。 SDNでは、分離された接続のトラフィックの分離を保持し、パフォーマンスや動的(再)割当てを向上させます。 顧客ネットワークから見て、Oracle Private Cloud ApplianceでのVxLANsの使用は透過的です: カプセル化およびカプセル化解除は、インバウンドまたはアウトバウンドのデータ・パケットを変更せずに内部的に実行されます。 つまり、この設計では、アプライアンスでホストされる仮想化環境に、顧客のネットワーク(タグ付けまたはタグ付けの解除)を拡張します。

Oracle Private Cloud Applianceの初期化プロセス時に、いくつかの必須のデフォルト・ネットワークが構成されます。

「内部ストレージ・ネットワーク」は、スパイン・スイッチからZFSストレージ・アプライアンスへの冗長40GbitEthernet接続です。 4つのストレージ・コントローラ・インタフェースはすべて、LACPを使用して1つのデータリンクに結合されます。 管理ノードおよびコンピュート・ノードは、VLAN 3093で

192.168.40.0/21サブネット全体に内部ストレージに到達できます。 このネットワークは、クラスタ化されたOracle VMサーバー・プールのハートビート機能も満たします。「内部管理ネットワーク」によって、管理ノードと、VLAN 3092のサブネット

192.168.32.0/21にあるコンピュート・ノード間の接続が提供されます。 Oracle VM Manager、Oracle VM ServerおよびOracle VM Agentsに固有のすべてのネットワーク・トラフィックで使用されます。「内部基礎ネットワーク」は、コンピュート・ノード間のデータ・トラフィックに対応するインフラストラクチャ・レイヤーを提供します。 これは、VLAN 3091上のサブネット

192.168.64.0/21を使用します。 内部基礎ネットワークの上位には、内部アクセスのみが必要な仮想マシン接続を有効化するために、内部VxLANオーバーレイ・ネットワークが構築されます。そのような内部VxLANの1つが事前に構成されています: すべてのコンピュート・ノードがそれぞれの

vx2インタフェースを使用して接続される「デフォルトの内部VMネットワーク」。 タグ付け解除されたトラフィックは、デフォルトでこのネットワーク上でサポートされます。 カスタマは、選択したVLANをOracle VMネットワーク構成に追加し、仮想マシン・レベルでIPアドレス割当てに適したサブネットを定義できます。「外部基礎ネットワーク」は、Oracle Private Cloud Applianceとデータ・センター・ネットワーク間のデータ・トラフィック用のインフラストラクチャ・レイヤーを提供します。 これは、VLAN 3090上のサブネット

192.168.72.0/21を使用します。 外部基礎ネットワークの上には、外部アクセスのあるVxLANオーバーレイ・ネットワークが構築されて、物理ノードおよびホストするすべての仮想マシンのパブリック接続が可能になります。そのようなパブリックVxLANの1つは事前に構成されています: すべてのコンピュート・ノードおよび管理ノードの

vx13040インタフェースを使用して接続先の「デフォルトの外部ネットワーク」 タグ付けされたトラフィックとタグ付けされていないトラフィックの両方は、このネットワーク上でデフォルトでサポートされます。 カスタマは、選択したVLANをOracle VMネットワーク構成に追加し、仮想マシン・レベルでIPアドレス割当てに適したサブネットを定義できます。デフォルトの外部ネットワークでは、データ・センター・ネットワークから管理ノードにアクセスし、複数のシステム・サービスを管理ノードで実行することもできます。 管理ノードの外部ネットワーク設定は、Oracle Private Cloud Appliance Dashboardの「ネットワーク設定」タブ」で構成できます。 このネットワークがVLANの場合、そのIDまたはタグは、ダッシュボードの「ネットワーク設定」タブ内で構成する必要があります。

アプライアンスのデフォルト・ネットワークを正常に構成するには、アプライアンスの初期化を開始する前にデフォルトの外部アップリンクを設定する必要があります。 管理者は、初期化プロセスの最後に、データ・センター(パブリック)のネットワーク範囲からOracle Private Cloud Applianceの管理ノード・クラスタに3つの予約済IPアドレスを割り当てます: 1つは各管理ノード用、もう1つはクラスタ化ノードによって共有される仮想IPです。 これ以降、仮想IPを使用してマスター管理ノードwebサーバーに接続します。このサーバーは、Oracle Private Cloud ApplianceダッシュボードとOracle VM Manager Webインタフェースの両方をホストします。

両方のスパインCisco Nexus 9336C-FX2スイッチは、次のレベルのデータ・センター・スイッチのペアにそれぞれ2つの10GbE接続を持つことが重要です。 このため、4方向の遮断ケーブルを各スパイン・スイッチのポート5にアタッチし、10GbE遮断ポート5/1および5/2をアップリンクとして使用する必要があります。 ポート5/3および5/4は使用されないままです。

このアウトバウンド配線は、サービスの最適な継続性を確保するために、スパイン・スイッチとデータ・センター・ネットワーク間のケーブル接続を超えているか、または調整する必要があります。

Oracle Private Cloud ApplianceとInfiniBandベースのネットワーク・アーキテクチャでは、物理的なInfiniBandネットワーク・ファブリックを使用して、内部管理通信用の追加のEthernet接続を確保します。

イーサネット

Ethernetネットワークは、他のすべてのラック・コンポーネントがCAT 6 Ethernetケーブルで接続される、2つの相互接続されたOracle Switch ES1-24スイッチに依存しています。 このネットワークはアプライアンス管理ネットワークとして機能し、すべてのコンポーネントは192.168.4.0/24の範囲に事前定義されたIPアドレスを持ちます。 また、すべての管理ノードおよびコンピュート・ノードのIPアドレスは、この範囲でOracle Integrated Lights Out Manager (ILOM)接続に使用される2つ目のIPアドレスを持っています。

アプライアンスの初期化中は、InfiniBandファブリックにアクセスできません。つまり、管理ネットワークはシステムに接続するための唯一の方法です。 そのため、管理者は、Oracle Switch ES1-24スイッチの1つで使用可能なEthernetポート19にワークステーションを接続し、固定IPアドレス192.168.4.254をワークステーションに割り当てる必要があります。 このワークステーションから、管理者は、http://192.168.4.216のマスター管理ノード上のwebサーバーへのブラウザ接続を開き、初期化プロセスをモニターして、アプライアンスの電源を初めて投入したときに初期構成ステップを実行します。

InfiniBand

Oracle Private Cloud Applianceラックには、2つのNM2-36P Sun Datacenter InfiniBand拡張スイッチがあります。 これらの冗長スイッチには、各管理ノードの両方のInfiniBandポート、コンピュート・ノードおよびストレージ・ヘッドへの冗長ケーブル接続があります。 どちらのInfiniBandスイッチも、ラック内の両方のFabricインターコネクトに冗長なケーブル接続を備えています。 これらのコンポーネントをすべて組み合せて、物理InfiniBandバックプレーンを40Gbit(Quad Data Rate)帯域幅で形成します。

アプライアンスの初期化が完了すると、ホスト・ドライバやInfiniBandカーネル・モジュールなど、必要なすべてのOracle Private Cloud Applianceソフトウェア・パッケージがインストールされ、各コンポーネントで構成されます。 この時点で、システムは物理的なInfiniBandファブリックの上に構成されたソフトウェア定義ネットワーク(SDN)を使用できます。 SDNは、Fabric Interconnectを介して実装されます。

Fabric Interconnect

すべてのOracle Private Cloud Applianceネットワーク接続は、Fabric Interconnectで管理されます。 データは物理的なInfiniBandファブリック間で転送されますが、接続はソフトウェア定義Networks (SDN)の形式で実装されます。この形式は、クラウドと呼ばれることもあります。 物理的なInfiniBandバックプレーンは、何千もの仮想ネットワークをホストできます。 これらのプライベート仮想インターコネクト(PVI)では、仮想マシンとベアメタル・サーバーをネットワーク、ストレージおよびその他の仮想マシンに動的に接続すると同時に、ハード接続のトラフィック分離を維持し、それらのパフォーマンスを向上させます。

Oracle Private Cloud Applianceの初期化プロセス中に、SDNを含む5つの必須ネットワークが構成されます: ストレージ・ネットワーク、Oracle VM管理ネットワーク、管理Ethernetネットワークおよび2つの仮想マシン・ネットワーク。 タグ付けされた仮想マシン・トラフィックおよびタグ付けされていない仮想マシン・トラフィックがサポートされています。 VLANは、コンピュート・ノードの既存の結合インタフェースの上位にある仮想インタフェースを使用して構成できます。

storage networkは、技術的にはソフトウェア定義されず、管理ノードとZFSストレージ・アプライアンス間のボンディングされたIPoIB接続であり、

192.168.40.0/24サブネットを使用します。 このネットワークは、クラスタ化されたOracle VMサーバー・プールのハートビート機能も満たします。 DHCPにより、コンピュート・ノードには、このサブネット内のIPアドレスが割り当てられます。「Oracle VM管理ネットワーク」は、

192.168.140.0/24サブネットの管理ノードとコンピュート・ノードを接続するPVIです。 Oracle VM Manager、Oracle VM ServerおよびOracle VM Agentsに固有のすべてのネットワーク・トラフィックで使用されます。「管理Ethernetネットワーク」は、管理ノード間の結合されたEthernet接続です。 このネットワークの主要な機能は、データ・センター・ネットワークから管理ノードへのアクセスを提供し、管理ノードが多数のシステム・サービスを実行できるようにすることです。 すべてのコンピュート・ノードもこのネットワークに接続されているため、Oracle VMでは、データ・センター・ネットワークとの間のアクセスを使用して、仮想マシン接続のために使用できます。 管理ノードの外部ネットワーク設定は、Oracle Private Cloud Appliance Dashboardの「ネットワーク設定」タブ」で構成できます。 このネットワークがVLANの場合、そのIDまたはタグは、ダッシュボードの「ネットワーク設定」タブ内で構成する必要があります。

「パブリック仮想マシン・ネットワーク」は、コンピュート・ノード間の結合されたEthernet接続です。 Oracle VMは、外部アクセスが必要な仮想マシン接続にこのネットワークを使用します。 タグ付け解除されたトラフィックは、デフォルトでこのネットワーク上でサポートされます。 顧客はOracle VMネットワーク構成に独自のVLANを追加して、仮想マシン・レベルでIPアドレス割当てに適したサブネットを定義できます。 外部接続の場合、タグ付けされたVLANトラフィックを受け入れるように、次レベルのデータ・センター・スイッチを構成する必要があります。

「プライベート仮想マシンのネットワーク」は、コンピュート・ノード間の結合されたEthernet接続です。 Oracle VMは、内部アクセスのみが必要な仮想マシン接続にこのネットワークを使用します。 タグ付け解除されたトラフィックは、デフォルトでこのネットワーク上でサポートされます。 カスタマは、選択したVLANをOracle VMネットワーク構成に追加し、仮想マシン・レベルでIPアドレス割当てに適したサブネットを定義できます。

最後に、Fabricインターコネクトでは、Oracle Private Cloud Applianceの物理的なパブリック・ネットワーク接続も管理されます。 各Fabric Interconnect上の2つの10GbEポートは、冗長な次レベルのデータセンター・スイッチに接続する必要があります。 管理者は、初期化プロセスの最後に、データ・センター(パブリック)のネットワーク範囲からOracle Private Cloud Applianceの管理ノード・クラスタに3つの予約済IPアドレスを割り当てます: 1つは各管理ノード用、もう1つはクラスタ化ノードによって共有される仮想IPです。 これ以降、仮想IPを使用してマスター管理ノードwebサーバーに接続します。このサーバーは、Oracle Private Cloud ApplianceダッシュボードとOracle VM Manager Webインタフェースの両方をホストします。

両方のFabricインターコネクトには、次のデータ・センター・スイッチのペアへの2つの10GbE接続が必要です。 この構成には、4つのケーブル接続があり、Fabricインターコネクトのレベル、10GbEポート、およびデータ・センター・スイッチでの冗長性と負荷の分割が提供されます。 このアウトバウンド配線は、Fabric Interconnectのペアへの内部接続がすでにそのように構成されているため、それを超えることはできません(接続)。 配線のパターンは、Fabric Interconnectの停止やその他のコンポーネントに関連するフェイルオーバー・シナリオにおけるサービスの継続に重要なロールを果たします。